Cet article est un portage de mon Medium et a été publié originellement le 17 Juin 2025

Si vous avez suivi l’actualité récente autour du salon VivaTech qui s’est tenu à Paris du 11 au 14 juin, vous aurez probablement entendu parler de la conférence qu’a tenue AMD ainsi que des annonces chocs que Lisa Su a pu faire.

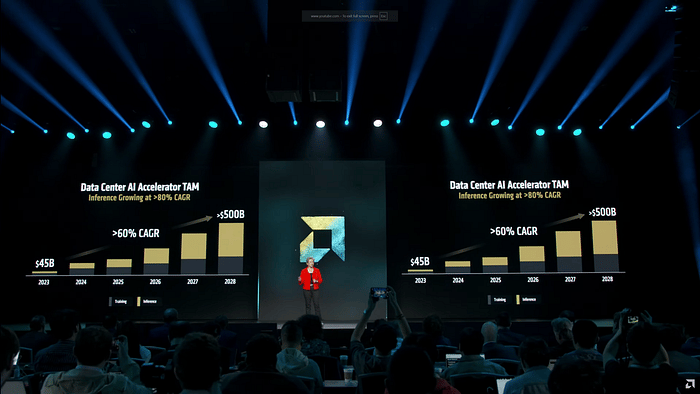

La première annonce qui a pu cristalliser l’intérêt des investisseurs est celle de Lisa Su sur la taille du marché des accélérateurs IA, évaluée à 500B$ d’ici 2028. Rien de nouveau cependant puisqu’elle avait déjà partagé ses anticipations il y a de ça quelques mois lors de la présentation des résultats du Q3 2024.

Cependant, cette keynote intitulée “Advancing AI” a eu bien plus d’annonces et je vous propose aujourd’hui de rentrer dans les détails pour comprendre les implications et essayer de voir les avancements qu’AMD a pu effectuer.

MI355X, MI400X, Helios, un déferlement de nouveaux produits !

Outre les annonces très optimistes de Lisa Su (CEO d’AMD) sur la taille future du marché des accélérateurs IA (segment qui comprend les GPUs mais aussi les ASIC) — soit dit en passant, je trouve que ces annonces sont assez réalistes de la taille du marché, même si ça paraît énorme — la vraie annonce a surtout été du côté de la roadmap d’AMD pour les prochaines années.

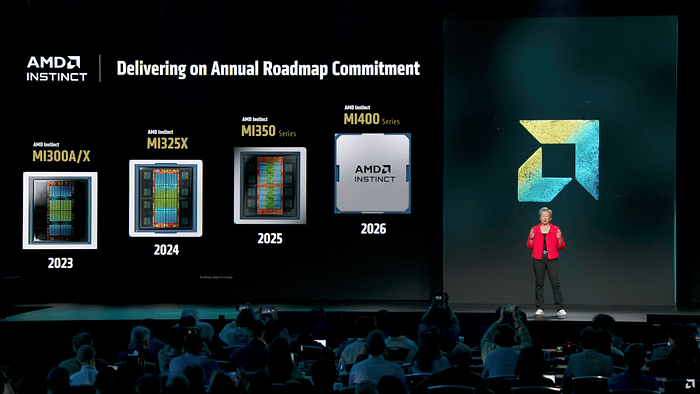

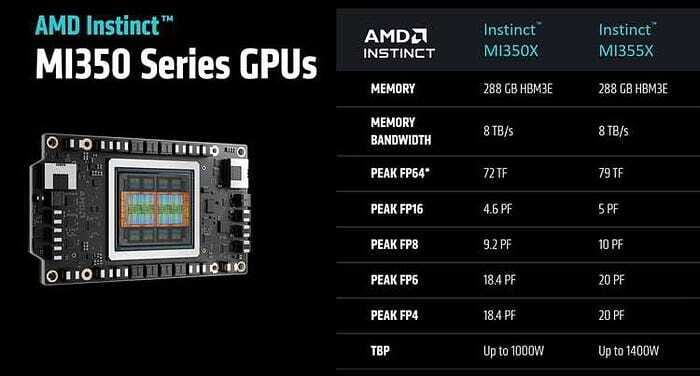

Premièrement sur les puces, Lisa Su a pu annoncer une version améliorée et boostée de la MI350X, la MI355X, ainsi que la prochaine génération, la MI400X.

Globalement, sur les performances de la MI355X, AMD annonce un ratio Perf/TCO (en gros, le nombre de token générés par rapport au coût total d’achat et d’utilisation — ça comprend l’achat du matériel et la consommation électrique) 40% meilleur que la B200. C’est franchement très bon.

Maintenant, si vous me lisez depuis un moment, vous devriez savoir que la puissance brute de la puce, on s’en carre un peu, ce qui est important, c’est le système, car aujourd’hui, on achète plus un GPU ou une puce, on achète un système entier.

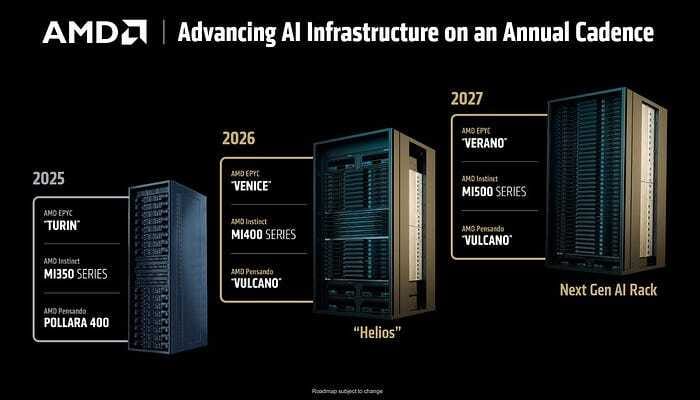

Et c’est la grande annonce de cette keynote car AMD vient enfin de dévoiler sa solution rack base qui sera en mesure de venir concurrencer les racks NVL72 GB200 d’Nvidia.

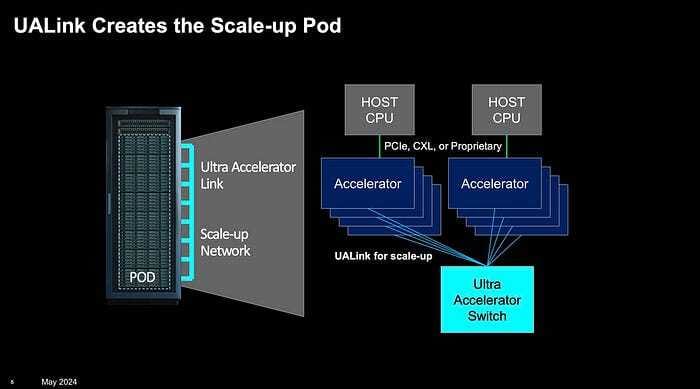

C’était un des points sur lesquels AMD avait un énorme retard et ils viennent enfin d’actualiser leur offre (c’est pas trop tôt…). La technologie UALink, développée conjointement avec Meta, Microsoft, Broadcom, Google, Cisco, Intel et HPE permettra enfin de scaler des GPUs sur l’échelle d’un rack entier, chose qui était réservée pour le moment à Nvidia grâce à son système propriétaire NVLink.

Helios, de son nom de code, le prochain rack d’AMD sera le premier à adopter UALink et sera équipé de 72 GPUs interconnectés grâce à cette technologie, le tout dans un rack “double-wide”.

Niveau spécifications, UALink est similaire à NVLink 5, la technologie actuelle équipée sur les racks Blackwell.

Cette annonce est une réelle avancée et permet enfin à AMD d’être compétitif sur le matériel, là où avant ils étaient bloqués sur des systèmes archaïques non scalable.

Oui, mais…

Cependant, il y a un mais… Car oui, la MI355X est annoncée comme 40% plus performante en Perf/TCO que la B200. Sauf que si vous m’avez suivi, vous devriez avoir remarqué que la MI355X n’est pas scalable.

Ici, AMD compare sa puce au système HGX B200 qui équipe au maximum 8 puces, et n’est quasiment pas déployé par manque de scalabilité. Nvidia reste donc encore aujourd’hui sans concurrent réel.

Pour rappel, la dernière puce d’Nvidia, Blackwell, est disponible sous deux versions: le serveur HGX B200 dont l’architecture ressemble en gros à un ordinateur survitaminé (un CPU x86/AMD64 et 8 GPUs) et le serveur GB200 qui est la version moderne et privilégiée car elle est plus facilement scalable

Serveur GB200 à gauche et HGX B200 à droite — au milieu c’est un rack NVL72 GB200

Mais soit, c’est un détail, puisque dans tous les cas, la MI400X sera scalable et Nvidia perdra l’avantage qu’ils ont sur ce point précis. Car la grande force d’AMD pour avoir un si bon Perf/TCO, c’est d’avoir plus de HBM (de la mémoire à haute bande passante). Il n’y a rien de magique ici et il y a fort à parier que si Nvidia équipait ses puces de plus de mémoire, elles seraient tout autant voir plus compétitives en puissance brute.

Non, le plus gros soucis pour AMD c’est une toute petite spécificité que vous avez lu il y a quelques lignes mais dont vous n’avez sans doute pas prêté attention: “double-wide”.

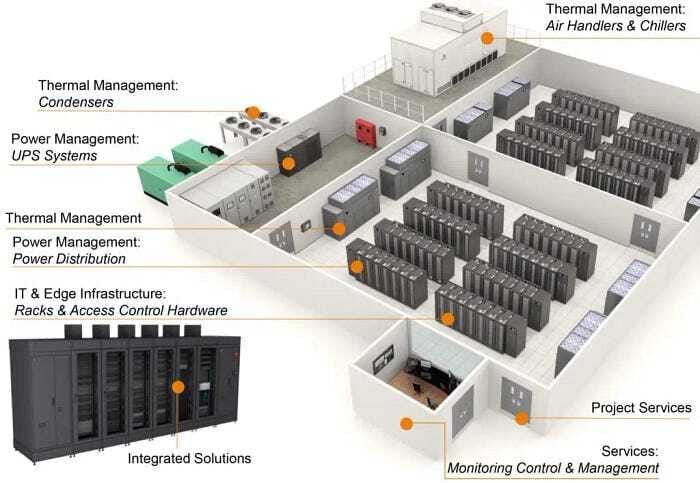

Car oui, si vous n’avez jamais mis les pieds dans un datacenter, il faut savoir que la taille des serveurs est extrêmement standardisée car ils faut qu’ils puissent rentrer dans des racks.

Armoire 48U

Ces racks sont hérités de la téléphonie et de la standardisation qui s’est opérée à la fin des années 90 pour permettre une meilleure inter-opérabilité et faciliter la maintenance et la mise à niveau.

Ces racks mesurent précisément 19" (48,26cm) de largeur intérieure (600 à 800mm de largeur externe) et 48U de hauteur intérieure avec 1U qui équivaut 1,75" (44,45mm) soit environ 2,13m de hauteur totale. La profondeur est variable mais se situe généralement entre 1m et 1,2m, tout dépend de la place qu’on laisse aux câbles et aux systèmes de refroidissement.

Mais alors, où est le problème ? En théorie, il serait bien plus simple d’augmenter la taille des racks pour accueillir plus de serveurs et les connecter entre-eux via du cuivre, pas cher, ne proposant aucune latence, plutôt que de passer via des solutions complexes comme la photonique, non ?

Et bien le soucis, comme vous pouvez probablement vous en douter, c’est que TOUT est articulé autour de cette norme de taille de rack. Que ce soit:

Le floor plan (plan d’installation du matériel en datacenter) avec la taille des “rooms” (car oui, il y a plusieurs “rooms” dans un datacenter) qui en est directement impactée

Le matériel, que ce soit l’alimentation (PSU), les serveurs (mais dans notre cas on s’en moque puisque AMD les design), les swicths, et même les systèmes de refroidissement

Mais aussi le matériel de maintenance, avec les lève-racks conçus pour les racks simple-wide standard

Premièrement, changer ce standard, ça veut dire qu’il faut redesigner toute la room, et pour certaines room, il ne sera tout simplement pas possible de les réadapter par manque de place. Donc le premier problème sur l’adoption ici c’est que ça forcera à avoir des room dédiées dans les new-build (nouveaux datacenters) et que le retrofit sera vraiment compliqué, voire impossible car le mix-up (le fait d’avoir et des simple-wide et des double-wide) sera un vrai enfer.

Ce problème en implique un deuxième: s’il faut créer des rooms spécialisées, ça veut dire qu’on créé une dépendance à un format spécifique, même si techniquement, ça sera possible de “downsizer” pour repasser sur du simple-wide en perdant probablement de la place.

Troisième problème: le matériel ! Car oui, il faudra qu’il y ait des entreprises qui fabriquent des alimentations et switchs en double-wide. Alors peut-être que le marché existera, mais ce sera aussi un risque à prendre pour ces entreprises, pas sûr qu’elles le veuillent vraiment.

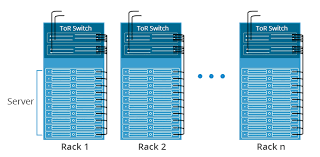

Petite précision technique: Si vous vous souvenez de mon schéma réseau d’un datacenter (lien ici — dans la section sur Nvidia Photonics), vous devriez vous rappeler qu’on a tout un empilement de couches réseau avant d’arriver aux racks serveurs. Ici, rien ne change sur le format de ces couches réseau, et même si ça pourrait poser problème (mix-up simple-wide/double-wide), les switchs dont je fais allusion ici sont ce qu’on appelle les ToRs (pour top of the rack), qui sont les switchs qui connectent les GPUs au réseau.

D’ailleurs, aucune entreprise comme Cisco ou Arista n’a annoncé de partenariat avec AMD pour la fourniture des ToRs, ce qui fait qu’Helios reste à ce jour une solution partielle et incomplète.

Quatrième problème: la maintenance ! Car oui, un serveur HPC aujourd’hui pèse à peu près 80 à 100kg. C’est énorme. En double-wide, on passera à 160–200kg, ce qui pose des risques majeurs pour les techniciens. Il faudra changer les lève-racks pour les adapter à cette nouvelle taille et ce poids important pour garantir la sécurité.

Cinquième problème: les rails. Chaque serveur est monté sur rails, ce qui facilite la maintenance. Cependant, seul KingSlide a la certification nécessaire pour fournir les rails pour les serveurs HPC. Avec un poids doublé et une taille plus grande, les contraintes mécaniques seront décuplées et il faudra renforcer énormément ces rails, ce qui fera mécaniquement exploser les coûts.

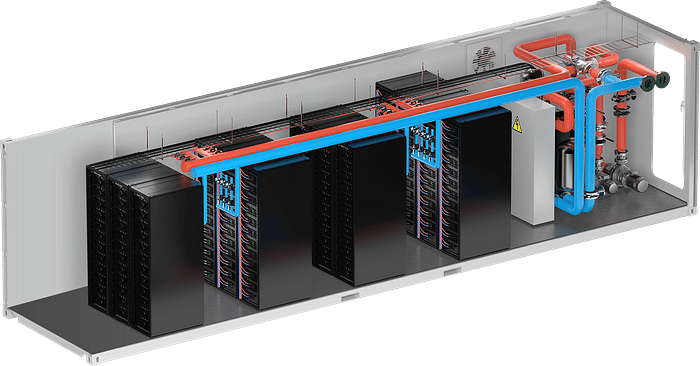

Sixième problème: le système de refroidissement, car même ce dernier est pensé autour de la taille standardisée des racks. Car oui, augmenter la taille des racks veut dire avoir un circuit plus long, avec plus de puces et de chaleur à évacuer, ce qui oblige à avoir un débit plus important.

Mais vous pourriez penser qu’on pourrait contourner le problème en ayant deux circuits à la place d’un. Et c’est vrai que cette solution permet de contourner le problème… Au prix d’un plus grand risque de fuites et donc d’une maintenance plus fréquente et complexe.

Et pour finir, il y a un septième problème: celui de l’encombrement. En effet dans les datacenters actuels, on est majoritairement contraints par deux choses: la consommation énergétique et l’espace.

Pour ce qui est de la consommation énergétique, AMD ne s’en sort pas si bien puisque sa puce MI355X consomme jusqu’à 1400W alors que le package B200 (2 GPUs), solution comparable d’Nvidia, consomme entre 1000 et 1200W, soit environ 14% de moins. C’est énorme.

Niveau encombrement et densité de calcul, AMD reste encore une fois bien à la traine, même avec Helios puisqu’ils promettent une capacité de 72 GPUs sur un rack double-wide alors qu’Nvidia propose un système comparable en simple-wide.

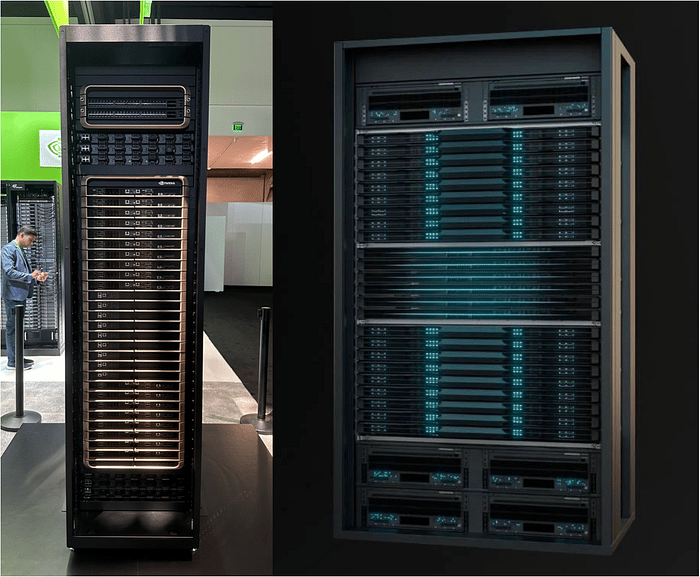

À gauche le Nvidia GB200 NVL72 et à droite le AMD Helios

En gros, les GPUs Nvidia consomment moins tout en occupant 2 fois moins d’espace et sans les contraintes qu’on a citées au dessus, et ça, pour un système qui sera vieux de 2 ans quand celui d’AMD commencera sa production…

De plus, cette plus faible densité implique un autre problème: l’éloignement entre les GPUs. Si vous vous souvenez de mon article sur la GTC, j’en parlais dans la section sur Rubin et la section sur Nvidia Photonics: une des grosses problématiques pour augmenter la taille des clusters, c’est la latence induite entre les différents racks. Et moins un système est dense, plus le réseau sera complexe et induira de la latence.

Dans la prochaine section, je vais faire une parenthèse personnelle qui n’apporte que peu de valeur à l’analyse. Si ça ne vous intéresse pas, on se rejoint à la conclusion.

Parenthèse personnelle

J’avoue qu’il devient de plus en plus difficile pour moi de parler d’AMD — et même de Nvidia — avec le bon équilibre. À chaque annonce d’AMD, j’ai un petit espoir: “tiens, peut-être cette fois ?”. Mais rapidement, en creusant, je tombe sur des détails qui me paraissent rédhibitoires.

Ce qui est paradoxal, c’est que j’aimerais sincèrement qu’AMD me donne tort. Qu’ils arrivent enfin avec une vraie alternative crédible à l’écosystème Nvidia. Mais à chaque fois, une pièce du puzzle manque: hier c’était l’absence de système rack-scale, aujourd’hui c’est un rack double-wide difficilement intégrable.

Le soucis que j’ai c’est que je suis toujours très positif quand je parle d’Nvidia et j’ai peur de passer pour le fanboy aveugle, sentiment qui peut être exacerbé par ma forte pondération dans le titre.

Mais d’un autre côté, j’ai vraiment l’impression qu’Nvidia évolue dans un autre monde avec au moins 5 coups d’avance sur la concurrence qui peine à rattraper son retard.

En fait, si l’idée paraît bonne sur le papier, la réalité est tout autre comme j’ai pu le montrer au dessus. Pour faire une analogie, c’est comme si Lancia, au milieu des années 80, avait décidé de mettre 2 moteurs dans sa voiture pour battre Audi en Groupe B plutôt que de travailler sur des technologies de rupture comme le Turbo ou les 4 roues motrices (pour ceux qui n’ont pas la référence, je vous invite à aller voir cette vidéo)…

Conclusion

En bref, la conférence d’AMD reste bonne en soit pour AMD. Ils gardent un train de retard mais leur solution progresse et ils adressent petit à petit les énormes lacunes qu’ils avaient.

Cependant, leurs solutions sont loin d’être optimales et vont poser d’énormes problèmes d’intégration. Nvidia reste encore loin devant sur le hardware, sans parler de la maturité de leur écosystème (car oui, UALink sera dans sa première version qui méritera probablement de nombreux ajustements — à côté, NVLink sera dans sa 6è version).

Et puis tout ça, c’est sans parler de l’adoption de ROCm par les développeurs, chose qui est encore loin d’être acquise et qui conditionnera le succès (ou l’échec) d’AMD dans les prochaines années.