Cet article est un portage de mon Medium et a été publié originellement le 5 Juin 2025

Nvidia vient tout juste de publier ses résultats cette semaine et ils sont excellents ! Mais un point qui vous aura probablement titillé si vous suivez de près l’entreprise: le segment networking regagne des couleurs.

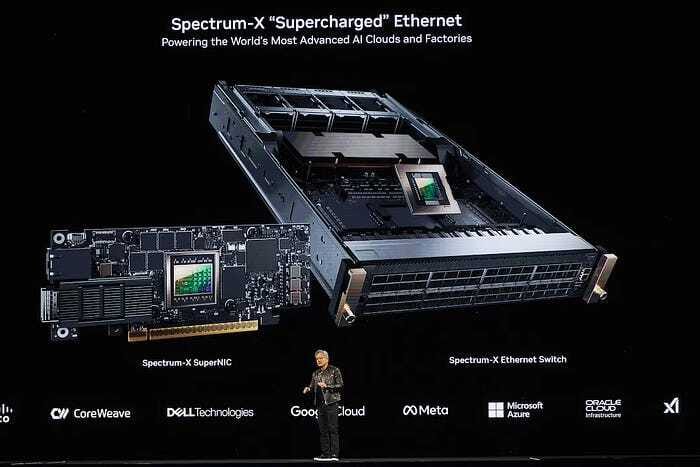

Durant cette même annonce de résultat, Nvidia a d’ailleurs précisé que Google et Meta avaient décidé d’opter pour Spectrum X au lieu de la solution concurrente de Broadcom. Cette annonce n’a pas tardé à faire réagir les marchés avec Arista Networks qui a pris -6% le lendemain.

Cette annonce est extrêmement positive pour Nvidia mais terriblement négative pour Broadcom et les fabricants de matériels réseau qui se reposent sur la technologie de ce dernier.

Et aujourd’hui, je vous propose d’étayer ma thèse en revenant rapidement sur ce que fait Broadcom, pourquoi elle est tant appréciée en bourse aujourd’hui et pourquoi Broadcom a du soucis à se faire.

Tomahawk 5 et les XPU

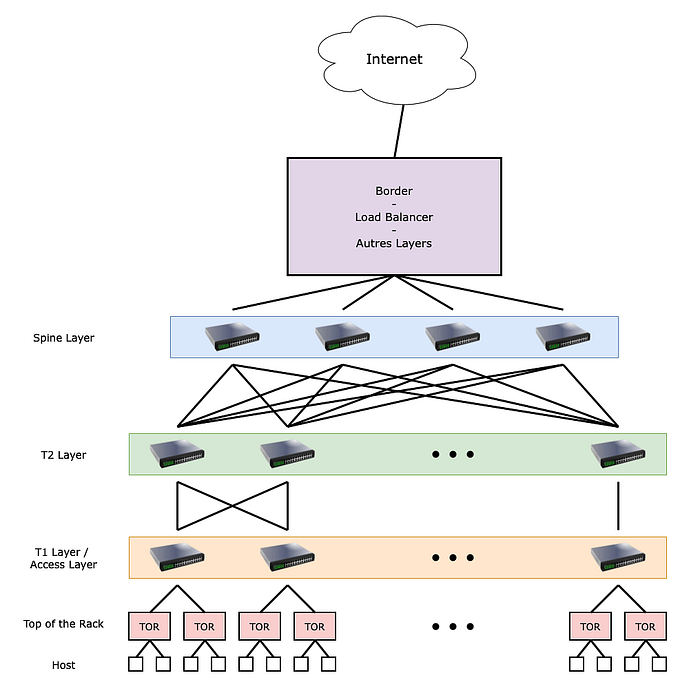

Bon, commençons rapidement par un petit rappel du fonctionnement d’un datacenter. Pour ça, je vous propose le schéma ci-dessous extrait de mon article sur la GTC:

Comme on peut le voir un datacenter est grossièrement un empilement de couches réseaux avec des routeurs et des switchs (commutateurs) qui acheminent le traffic vers des serveurs.

Le coeur de métier de Broadcom est la fabrication de divers matériels réseau dont des composants optiques, des systèmes cuivrés ainsi que des puces dédiées au réseau.

En réalité, Broadcom ne fabrique pas directement des produits pour les datacenters mais fabrique et conçoit des composants essentiels. Aujourd’hui, si Broadcom est tant appréciée en bourse c’est pour deux raisons:

Sa technologie TomaHawk 5

Ses accélérateurs IA, les XPU (ce sont des ASIC)

J’aurais l’occasion de vous faire une analyse de Broadcom plus en détail, le but ici n’est pas d’expliquer ce que fait exactement Broadcom mais de donner une “overview” pour mieux comprendre la suite

Comme vous le savez, ce qui drive actuellement le marché des semi-conducteurs, c’est l’appétit gargantuesque des hyperscalers et autres fournisseurs de cloud pour l’intelligence artificielle.

Et ces datacenter IA ont deux grosses contraintes:

La première c’est de pouvoir acheminer rapidement l’information et de pouvoir faire communiquer efficacement des dizaines de milliers de puces entre elles

La seconde c’est d’optimiser les coûts ainsi que la consommation énergétique

Et aujourd’hui il n’y a que deux acteurs proposant une technologie réseau suffisante pour faire communiquer rapidement les puces entre-elles: Nvidia et Broadcom.

Pour ce qui est des ASIC, c’est un sujet assez long à développer, mais retenez que c’est une puce conçue pour un usage spécifique, ce qui veut dire qu’elle est donc bien plus efficiente (donc que la performance par watt est bien supérieure) que les GPU.

La réflexion simple (qui commence à être démontrée comme étant bien erronée, comme toutes les réflexions simples) c’était de dire que comme les ASIC étaient plus efficients et moins chers que les GPUs, alors ils allaient prendre des parts de marché dans les workloads IA, d’où l’attrait des marchés financiers.

La menace Nvidia

Comme vous devez vous en douter, si je fais cet article, c’est qu’il y a un loup. Et ce loup est nommé Nvidia.

Comme expliqué dans la partie précédente, il y a deux acteurs ayant la technologie nécessaire pour répondre aux besoins réseaux des datacenters IA: Broadcom et Nvidia.

En réalité, il y a deux acteurs mais aussi deux technologies: Ethernet et InfiniBand. La technologie Ethernet est un protocole normé par la directive IEEE 802.3, ce qui veut dire que la technologie est publique et accessible à tous.

TomaHawk 5 de Broadcom et Spectrum X d’Nvidia sont tous deux basés sur le protocole Ethernet.

InfiniBand en revanche est une technologie propriétaire Nvidia. Et, si l’on pensait il y a encore un an qu’Ethernet avait gagné la bataille, il semblerait qu’InfiniBand ait aussi son mot à dire, surtout sur les plus petits clusters où il semble bien plus facile à déployer et moins cher.

Parce qu’ici, il y a deux choses à comprendre en amont:

Premièrement, les GPUs Nvidia sont rares et tout le monde se les arrache. Si les hyperscalers se tournent vers AMD ou tentent de faire leurs propres puces, c’est en grande partie pour pallier au manque de production d’Nvidia

Nvidia se soumet à une pratique commerciale discutable: si vous commandez ses technologies réseau en même temps que les GPUs, alors votre commande sera traitée en priorité et vous pourrez aussi commander plus de GPUs

Alors, pourquoi Nvidia exerce cette pratique commerciale ? Surtout que l’on sait que les technologies Ethernet sont plus ou moins interchangeables et que pour les plus petits clusters, la question se pose à peine, autant partir sur du InfiniBand.

Et bien la réponse se résume en 2 mots: coût et flexibilité.

Premièrement sur le coût: c’est de notoriété publique, Nvidia aime les grosses marges (comme toutes entreprises ceci dit me direz vous). La conséquence directe, c’est que les switchs Spectrum X et InfiniBand sont bien plus chers que ceux de la concurrence, pour des performances équivalentes.

Le côté plus sournois, c’est qu’Nvidia impose l’utilisation d’optiques “Nvidia certified optics”, qui sont environ 2 fois plus chères que des optiques traditionnelles.

Si pour le cas d’un cluster de de petite taille, cela ne pose pas trop de soucis, dans le cas de clusters gigantesques, le coût des optiques devient totalement déraisonnable (ça peut représenter plus des 3/4 des coûts sur le matériel réseau).

Et donc vous l’aurez deviné, utiliser Spectrum X ou InfiniBand, c’est sacrifier de la flexibilité.

Cependant, et c’est là où je sors ma carte contre-Uno: la technologie Broadcom n’est pas un produit miracle et a une grosse faiblesse, la compatibilité.

En gros, pour résumer, vous avez le choix entre utiliser la technologie Nvidia, pouvoir déployer rapidement sans soucis d’optimisation et de compatibilité car tout fait parti d’un écosystème, mais raquer sur le matériel, OU utiliser la technologie Broadcom, ce qui permet de faire des économies drastiques, mais économies qui seront mangées par le budget R&D pour faire fonctionner le tout ensemble.

Donc dans le cas des hyperscaler, l’avantage est clairement à Broadcom car l’échelle des déploiement et la taille de ces derniers favorisent clairement les économies réalisées sur le matériel. Ces entreprises ont des budgets R&D immense et ils sont dérisoires par rapport au budget qu’ils mettent dans le matériel.

Mais pour ce qui est des plus petites structures, même dans le cas de gros clusters IA, le coût de l’ingénierie pourrait être peu avantageux.

C3PO ? Non, CPO

Si vous faites partie de mes lecteurs assidus, ou si vous travaillez dans le secteur, vous êtes sûrement en train de vous dir : « Oui mais Julien, tu ne nous apprends rien de nouveau », et vous auriez raison.

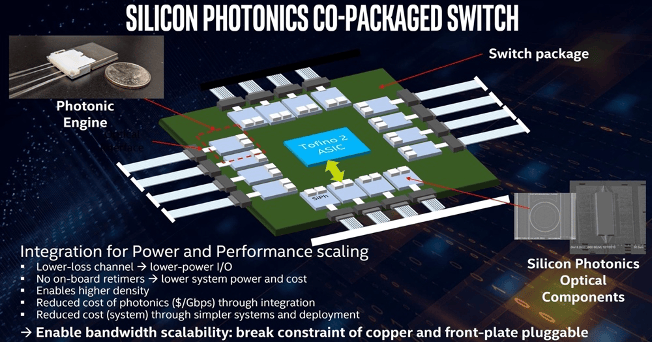

Pourtant, une technologie est en train de bouleverser le paysage — et Nvidia pourrait bien en sortir une nouvelle fois grande gagnante. Cette technologie, c’est la photonique, plus précisément la Co-Packaged Optics.

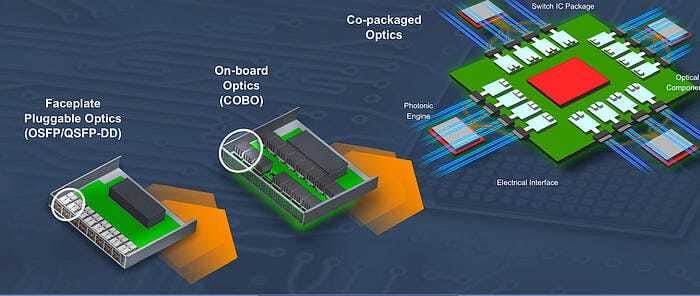

Si vous avez lu mon article sur la GTC, cela vous rappellera des choses. Mais pour ceux qui ne l’auraient pas lu, voici un rapide rappel: dans un datacenter, les puces (CPU, GPU, switchs, etc.) sont interconnectées via de la fibre optique.

Mais cette fibre ne se connecte pas directement aux puces. Elle passe d’abord par un transceiver qui convertit le signal lumineux (analogique) en signal électrique (numérique) — et inversement.

L’intérêt des transceivers, c’est qu’ils permettent d’utiliser une infrastructure en fibre tout en conservant des interfaces cuivre bien maîtrisées. Ce changement a permis de multiplier les débits tout en conservant une architecture relativement simple.

Cependant, on se heurte aujourd’hui à deux limites majeures: la consommation et la latence. Chaque transceiver consomme environ 30W. À l’échelle d’un datacenter, cela représente jusqu’à 30 % de la consommation énergétique totale, rien que pour la couche réseau. Et qui dit consommation dit aussi chaleur — un vrai casse-tête thermique.

Autre point crucial: le temps de conversion entre signal optique et signal électrique ajoute une latence. Pour des modèles IA géants, où chaque milliseconde compte, cette latence peut devenir un goulot d’étranglement.

En résumé, l’optique classique atteint ses limites. C’est là qu’entre en jeu la photonique intégrée, ou Co-Packaged Optics (CPO) — aussi appelée SiPh (Silicon Photonics) dans le monde des semi-conducteurs.

Ici, l’idée est de regrouper la puce réseau et les interfaces optiques dans un même package, afin de recevoir directement un signal lumineux, sans conversion électrique intermédiaire. Le résultat ?

✅ Une consommation réduite de 70 % côté optique (soit environ 21% de gain sur l’ensemble du datacenter)

✅ Une latence bien plus faible

✅ Une bande passante encore accrue

✅ Et surtout: beaucoup moins de chaleur à dissiper

Et je ne parle même pas du gain financier, vu qu’on aura plus besoin d’autant d’optiques (il en faudra toujours, mais beaucoup moins).

C’est bel et bien une révolution. Et tous les datacenters de prochaine génération adopteront cette technologie, c’est une certitude.

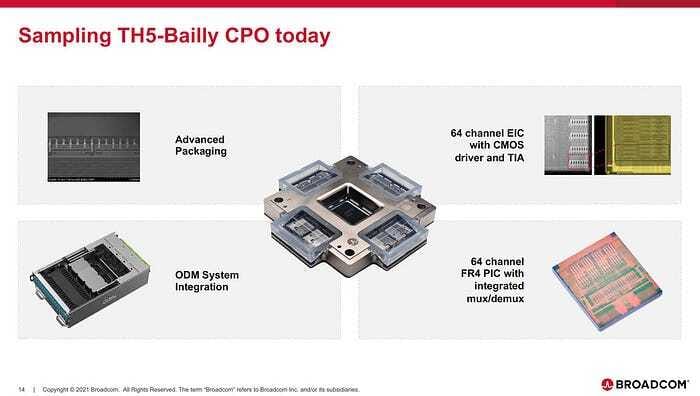

Revenons à Broadcom et Nvidia. Broadcom a été le premier à annoncer une puce photonique, nommée Bailly, en mars 2024. Nvidia a suivi avec ses propres annonces lors de sa GTC.

Mais souvenez-vous: Broadcom ne vend pas de matériel réseau fini, seulement des composants. Résultat: bien que Bailly ait été annoncé, aucun acteur majeur du marché (Arista, Celestica, Cisco, HPE, Juniper…) n’a encore annoncé de produit commercial l’intégrant.

Seul Micas Networks, un constructeur émergent peu connu du grand public, a lancé une première offre autour de Bailly — davantage comme preuve de concept que comme lancement d’envergure.

En général, il faut compter 18 à 24 mois entre l’annonce d’une puce Broadcom et son intégration dans un système vendu en volume.

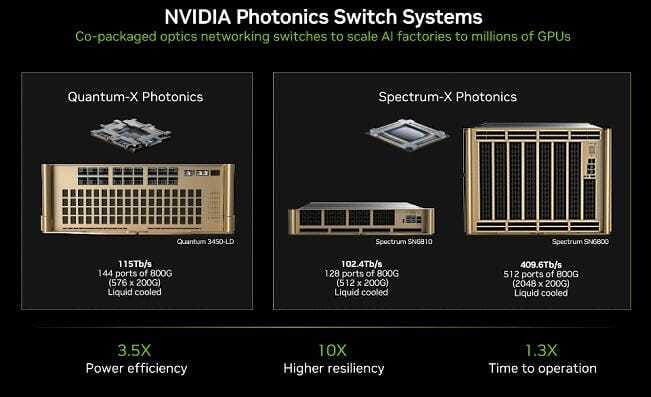

Et c’est là qu’Nvidia prend l’avantage. Malgré son année de retard, la firme a déjà annoncé des dates de disponibilité pour sa propre solution photonique:

InfiniBand Photonics (Quantum-X): disponible dès fin 2025

Spectrum-X Photonics: commercialisé au premier semestre 2026

Là où Broadcom dépend de l’écosystème pour adopter Bailly, Nvidia contrôle toute la pile matérielle et logicielle, ce qui lui permet d’accélérer le time-to-market.

En conclusion

Techniquement, Broadcom garde une longueur d’avance : expertise historique, maîtrise du silicium photonic, flexibilité architecturale… Mais Nvidia n’a pas dit son dernier mot — et pourrait même prendre le dessus.

Sur des technologies de rupture comme le CPO, le time-to-market est crucial. Il ne s’agit pas juste d’intégrer une nouvelle technologie: il faut redessiner les datacenters, réinventer les topologies réseau et revoir toute la chaîne de valeur. Et vu les gains promis (consommation, latence, bande passante), les clients ne vont pas attendre.

Si l’on y rajoute le chantage qu'effectue Nvidia pour faire adopter sa solution, Broadcom se retrouve d’autant plus défavorisé.

En plus, seuls les hyperscalers ont vraiment les moyens d’intégrer les solutions Broadcom, vu les coûts d’ingénierie nécessaires. Or, voir Google et Meta signer directement avec Nvidia, c’est un véritable séisme pour l’écosystème.

Broadcom reste une très belle entreprise. Mais à ce stade, je trouve sa valorisation difficile à justifier au vu des risques réels: dépendance à des intégrateurs, lenteur de l’écosystème, et surtout pression croissante d’Nvidia.

En réalité, les plus exposés sont peut-être les équipementiers réseau: Arista (même si elle est probablement la mieux armée), Juniper, et surtout Cisco, qui persiste à concevoir ses propres puces malgré un retard technologique abyssal.