Cet article est un portage de mon Medium et a été publié originellement le 15 Mai 2025

Vous l’avez peut-être vu passer mais un des cadres de Microsoft a été interviewé peu après la publication de résultats d’AMD et ce qui en est ressorti, c’est qu’AMD avait un vrai coup à jouer sur l’inférence et pouvait menacer l’hégémonie d’Nvidia.

Comme certains le savent, je suis fortement exposé à Nvidia et je prends cette interview très au sérieux. Cependant, il y a aussi eu certains commentaires fait de la part d’équipes de Microsoft pointant le fait qu’ils ont du mal à louer les puces AMD. Cette situation pouvant montrer des signes de conflit d’intérêt, je me suis mis en tête de démêler le vrai du faux pour savoir si oui ou non, il pourrait être intéressant de rebalancer son portefeuille d’Nvidia à AMD. Attention, ça va être technique !

L’entraînement: un non sujet

Bon, ici, il n’y a vraiment aucun débat, Nvidia surdomine l’entraînement. C’est admis par tout le monde, même dans cette interview. Cependant, je me suis dit qu’il serait intéressant d’expliquer pourquoi Nvidia a une telle domination. Ça permettra aussi de comprendre pourquoi c’est différent sur l’inférence.

Pour ça, il faut se pencher sur les technologies utilisées pour faire l’entraînement. Aujourd’hui, pour entraîner un modèle, on utilise cuDNN, cuBLAS, NCCL et PyTorch avec un support natif de CUDA.

Toute cette stack (à part PyTorch, mais qui ici est optimisé pour CUDA), est une technologie propriétaire d’Nvidia. Même si AMD essaie de proposer une alternative avec ROCm, Nvidia a une base de développeurs acquis et changer de stack technologique reviendrait à prendre un risque énorme, qui ne serait même pas payant aujourd’hui.

Nvidia a donc un monopole total et complet sur l’entraînement. Maintenant, qu’en est-il de l’inférence ?

L’inférence: des besoins différents et un monopole contestable ?

Là où sur l’entraînement il y a un monopole technologique pour Nvidia, sur l’inférence les technologies utilisées sont plus open-source. Le monopole d’Nvidia en devient donc par nature plus contestable.

Ici, plusieurs technologies rentrent en compétition:

ONNX Runtime : open standard soutenu par Microsoft, permet d’abstraire le matériel (Intel, AMD, Nvidia…).

TensorRT (Nvidia) : compiler propriétaire pour inférence ultra-optimisée sur leurs GPU.

Triton Inference Server : serveur multi-framework de Nvidia, mais très intégré à leur stack.

TVM, OpenVINO (Intel), Vitis AI (Xilinx), et récemment MLIR (Google) : autres graph compilers généralistes ou propriétaires.

Hugging Face Optimum ou vLLM : frameworks d’optimisation compatibles avec plusieurs backends.

Ici donc, très peu de dépendance à CUDA, même si TensorRT reste dominant poussant donc l’utilisation de GPUs Nvidia. Cependant, et vous devriez déjà le savoir si vous me lisez depuis un moment, Nvidia n’est pas Intel et continue d’innover.

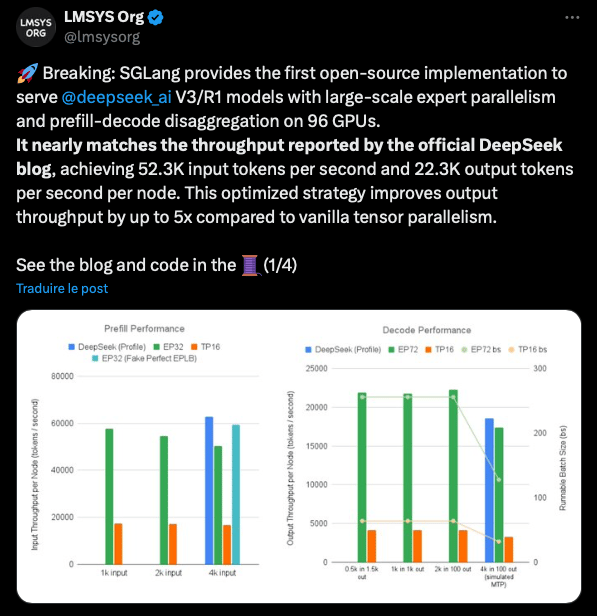

Récemment, Nvidia a introduit un nouveau framework, Dynamo, lors de sa GTC 2025. Dynamo vise à augmenter les performance en inférence multi-GPU, notamment en optimisant les connexions inter-GPU avec une nouvelle version du NCCL, un smart router et un GPU planner, mais aussi en optimisant la gestion du KV-Cache, composant essentiel en inférence.

D’après les premiers test, Dynamo permettrai de multiplier par 5 le nombre de tokens générés par rapport à un parallélisme tensoriel classique.

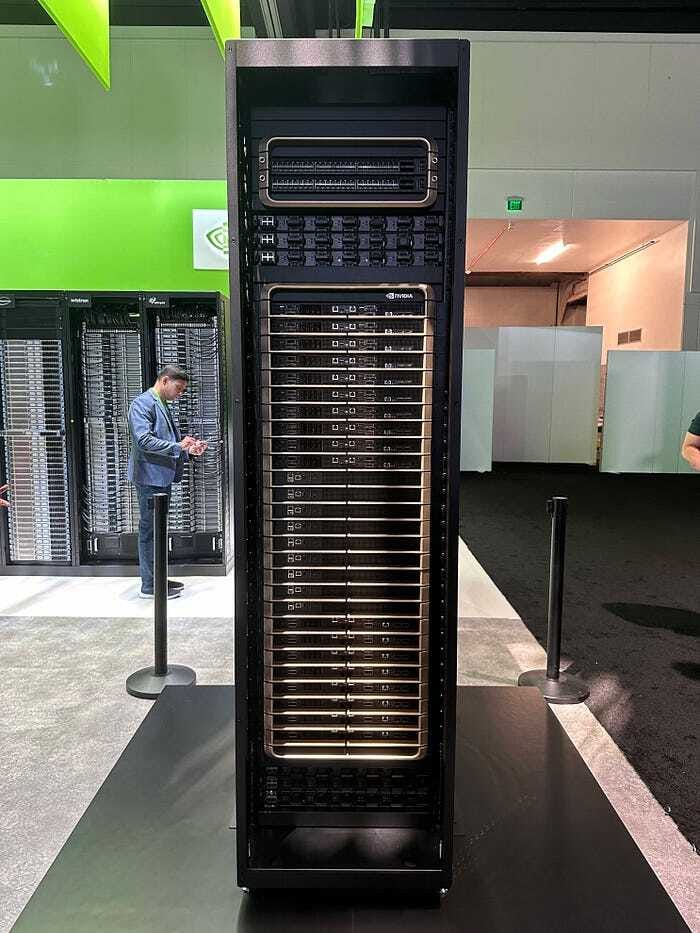

De plus, Blackwell est un monstre de puissance et est aujourd’hui bien moins chère que tout équivalent quand on compare à donnée comparable, c’est-à-dire en utilisant le TCO (Total Cost of Ownership, ce qui inclue le coût upfront mais aussi le coût d’usage).

Blackwell est aussi nativement optimisé pour le MoE (Mixture of Experts), une technologie très en vogue actuellement. Il ne faut d’ailleurs pas voir Blackwell comme simplement une puce, mais plus comme un système à part entière.

Aujourd’hui, comme le note SemiAnalysis, la MI355X, dernière puce d’AMD, n’est toujours pas compétitive face au flagship d’Nvidia, le GB200 NVL72. Nvidia est capable d’intégrer une densité de calcul folle dans un seul rack, ce qu’AMD n’est pas capable de faire.

Non seulement, AMD perd la bataille en chip vs chip, mais si on y rajoute le système, AMD n’est en mesure d’équiper seulement 8 GPUs par rack (et en air-cooled uniquement) contre 144 pour Nvidia (chaque package GB200 contient deux GPU Blackwell et un CPU Grace).

Et tout ceci, c’est sans compter l’écosystème software ni l’écosystème hardware avec le système NVLink et les Switch InfiniBand (et bientôt Nvidia Photonics) qui renforcent la supériorité d’Nvidia.

Alors oui, AMD peut devenir compétitif sur les plus petits modèles (avec moins de 70B de paramètres) car ils ne nécessitent pas tant de puissance de calcul et donc que les technologies de pointes ne sont pas nécessaires.

Mais pour ce qui est des plus gros modèles, Nvidia pourrait encore verrouiller la stack technologique, et c’est d’ailleurs ce qui est en train de se passer.

La dynamique actuelle: vraiment pas en faveur d’AMD

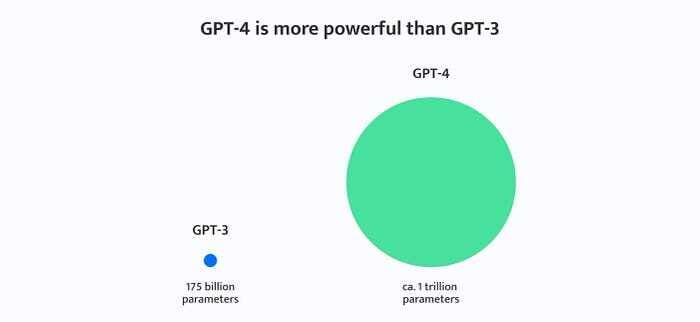

Aujourd’hui, on a une réelle premiumisation des modèles. Si l’on compare GPT-3 à GPT-4, on passe de 175B de paramètres à environ 1T de paramètres avec du MoE. Il en est de même pour les derniers modèles de Meta, d’Anthropic et de Google.

Alors oui, les modèles sont plus efficaces à taille de modèle équivalente car on active qu’un certain nombre de paramètres et d’experts, ce qui diminue le coût de l’inférence effective par token.

Cependant, cette inférence est rendue de plus en plus complexe, avec un routage dynamique, un KV-Cache massif à gérer, des communications inter-GPU critiques et une planification à gérer. Exactement ce pourquoi Dynamo a été créé.

De plus, si l’on prend l’exemple des token de raisonnement, leur nombre explose, ce qui rend l’inférence multi-GPU primordiale. Sans infrastructures et technologies comme celles d’Nvidia, l’inférence sur plus de 16 GPUs est impossible.

Ici, Nvidia fournit le hardware (avec Blackwell et les NVLink), le compiler (TensorRT-LLM) et le runtime (Triton Inference Server, TensorRT-LLM serving, Dynamo). Et cette complexité rend cette stack technologique extrêmement complexe à reproduire, surtout en open source.

Des datacenter spécialisés, vraiment ?

Le dernier point qu’il me reste à évoquer dans cette interview, c’est celui sur les datacenters spécialisés. Je vais faire court: je n’y crois pas un instant.

Jamais dans l’histoire de l’informatique on a eu des datacenters spécialisés. Et ça repose sur un principe fondamental: la mutualisation et les coûts d’échelle.

Plus on mutualise les ressources, plus le coût par VM diminue. Un datacenter 100% dédié à l’inférence pourrait vite devenir obsolète si les modèles ou si les puces évoluaient trop rapidement.

Par ailleurs, les contraintes thermiques, de bande passante (Infiniband, NVLink), et de densité mémoire ne sont pas homogènes entre workloads. Il est donc préférable de partitioner un datacenter que de le spécialiser à 100%.

Par contre, il est tout à fait probable d’avoir des pods spécialisés et mutualisés pour optimiser la gestion des ressources, surtout sur les workloads IA intensifs. Ça serait donc une spécialisation locale et logique mais pas une spécialisation sur l’infrastructure.

Pour ce qui est des puces spécialisées, on tombe encore face au même problème. Une puce généraliste comme celles que proposent Nvidia permettent bien plus de flexibilité, ce qui permet une simplicité opérationnelle et un amortissement maximal.

Une puce spécialisée est non seulement plus risquée car elle peut devenir obsolète très rapidement en cas de revirement technologique, mais elle vient aussi avec son lot de problèmes: moins bonne utilisation moyenne sur la durée et peu ou pas de support logiciel universel.

Dans une infrastructure cloud on veut des GPUs toujours utilisables, même quand la demande fluctue entre les besoins en inférence ou en training. Donc même si le TCO devenait plus cher pour Nvidia, rien qu’entre l’adoption des développeurs et la flexibilité permise par des puces plus génériques, il serait préférable pour les hyperscaler de s’équiper en puces Nvidia (et ça vaut encore plus pour les plus petits acteurs).

En conclusion

AMD pourrait venir effectivement grignoter des parts de marché à Nvidia. Mais contrairement à ce qui est dit, cela se ferait à la marge, pour diminuer les coûts sur des tâches peu monétisables ou à faible valeur ajoutée (LLM grand public).

Nvidia surdomine le marché de l’entraînement et est bien parti pour verrouiller le marché de l’inférence haut de gamme, qui sera principalement utilisé par les entreprises au vu du coût que cette inférence représente.

Non seulement AMD a du chemin a faire sur la partie logicielle, mais aussi matérielle avec des puces qui ne sont pas encore compétitive en puissance brute, mais qui sont aussi moins scalables et moins agiles. Sans parler de l’écosystème hardware manquant.

Une fois les lacunes comblées, il faudra encore qu’AMD réussisse à convaincre les développeurs d’adopter ses solutions. Encore faut-il que ses solutions restent compétitives face à Nvidia qui ne cesse d’innover, et à un rythme extrêmement soutenu.

Ce qui me fait peur pour AMD personnellement, c’est que le segment où elle ira se battre (l’inférence pour les petits modèles) est un secteur qui sera aussi pris d’assault par les ASIC. Les marges d’AMD pourraient donc venir à diminuer, ce qui limiterait fortement le potentiel à la hausse pour le titre.

En bref, selon moi, investir sur AMD aujourd’hui relève du pari avec peu de chances de succès. Les défis dont AMD fait face ne sont pas des moindre et le marché des puces IA évolue extrêmement rapidement. Il se pourrait que d’ici 2 mois, le marché de l’inférence haut de gamme soit déjà verrouillé pour les 5 à 10 prochaines années par Nvidia, avec l’adoption de plus en plus massive de Blackwell et l’arrivée de Blackwell Ultra.