Bonjour à tous et bienvenue dans un nouvel épisode de Deep Silicon !

Avant de commencer, je tiens à te dire que je suis content de te retrouver pour le 2è épisode de Deep Silicon. Vous êtes actuellement 1 157 lecteurs ! Je souhaite la bienvenue aux nouveaux et je tiens à tous vous remercier pour votre confiance.

Si on t’a transféré cet e-mail, sache que tu peux t’inscrire gratuitement à cette newsletter en cliquant sur le bouton ci-dessous 👇

S’il y a bien une chose qui a fait le tour des médias en cette fin d’année, c’est la nouvelle position short de Michael Burry, le célèbre investisseur qui a shorté les subprimes en 2007 avant l’effondrement en 2008 📉.

Le docteur Burry accuse les géants de la tech américaine (Microsoft, Amazon, Google et Meta), de trafiquer leurs comptes en allongeant la durée d’amortissement des GPUs achetés pour l’IA 🤖.

Il compare aussi Nvidia à Cisco, soutient que les dépenses actuelles des hyperscalers ne sont pas tenables et que la demande en capacité de calcul va s’effondrer, créant ainsi l’un des plus gros krachs boursiers depuis la bulle 🫧 internet.

Dans la suite de cette newsletter, je vais t’expliquer pourquoi je pense que Michael Burry a tort et pourquoi je pense que la bulle internet n’a rien à voir avec ce qu’il se passe actuellement sur l’IA 🤖.

📊 Des comptes maquillés ?

La principale accusation de Michael Burry, et celle qui a cristallisé l’attention du marché, concerne les hyperscalers, c’est-à-dire Microsoft, Amazon, Google et Meta. Michael Burry les accuse de fraude 🚨 en allongeant au-delà du raisonnable la durée d’amortissement des puces.

Pourquoi c’est important ? Il faut comprendre que les investissements, ou CapEx, ne sont pas représentés de la même manière dans le compte de résultats et dans le tableau des flux de trésorerie.

Comme un exemple vaut mieux qu’une longue explication, je vous propose de prendre deux entreprises, A et B, investissant chacune 100B$ 💸 dans leurs datacenters et générant chacune 100B$ d’EBITDA 💰sur 2025.

Sur ces 100B$ investis, 50B$ partent dans de l’infrastructure 🏭 à durée de vie longue (20 ans d’amortissement) et 50B$ partent dans du matériel informatique 🖥️ à durée de vie courte. L’entreprise A amortit son matériel informatique sur 5 ans alors que l’entreprise B, plus conservatrice, amortit son matériel sur 3 ans.

Pour des raisons de simplification, partons du principe que ces entreprises n’affichent aucune croissance, le même niveau de taxation et exactement le même profil financier. Ainsi, on a:

En charges d’amortissement annuelles:

12,5B$/an sur les 5 premières années puis 2,5B$/an sur les 15 années suivantes pour A

19,67B$/an sur les 3 premières années puis 2,5B$/an sur les 17 années suivantes pour B

Sur le compte de résultats:

87,5B$ d’EBIT/an sur les 5 premières années puis 97,5B$ d’EBIT/an sur les 15 années suivantes pour A

80,33B$ d’EBIT/an sur les 3 premières années puis 97,5B$ d’EBIT/an sur les 17 années suivantes pour B

⚠ Attention: ce n’est pas parce que l’actif est complètement amorti (i.e. il vaut 0 au bilan) qu’il n’a plus de valeur économique. Par exemple, on peut avoir des GPUs complètement amortis qui génèrent encore du chiffre d’affaires. Dans ces cas là, la marge bénéficiaire est plus importante car il n’y a aucune charge d’amortissement.

Techniquement, le résultat est le même sur la durée, la seule différence se fait à court terme avec des charges d’amortissements qui pèsent plus ou moins sur les bénéfices. Cependant, il reste un point important à aborder: celui de la durée de vie utile et économique.

Là où le problème se situe, c’est plus dans le cas où le matériel acheté a une durée de vie utile plus faible que sa durée d’amortissement 🚩. Pour faire simple, imaginons que le matériel informatique tombe en panne au bout de 3 ans et qu’il faille le remplacer.

Dans le cas de l’entreprise A, il va y avoir une charge exceptionnelle sur l’année 3 de 20B$ qui vont s’ajouter aux 12,5B$ de charge d’amortissement (on appelle ça un impairment en anglais), ce qui va mener l’EBIT à 67,5B$ et faire naturellement dégonfler le bilan 🔻.

Dans le cas de l’entreprise B en revanche, il ne se passe rien comme le matériel est déjà 100% amorti et vaut techniquement 0 dans le bilan.

Ce qu’il faut comprendre ici, c’est qu’augmenter la durée d’amortissement:

Gonfle la taille du bilan 📈: comme les charges d’amortissement sont plus faibles, l’actif garde une valeur plus importante plus longtemps au bilan, ce qui augmente mécaniquement le risque d’impairment

Gonfle le bénéfice à court terme 📈: pour la même raison que pour le bilan, comme les charges d’amortissements sont plus faibles, l’EBIT et donc les bénéfices sont moins impactés

Et cette mécanique financière que Burry pointe du doigt 🫵 en accusant les hyperscalers d’augmenter la durée de dépréciation pour maquiller leurs comptes et les faire apparaître meilleurs qu’ils ne le sont réellement, soutenant artificiellement les cours de bourse.

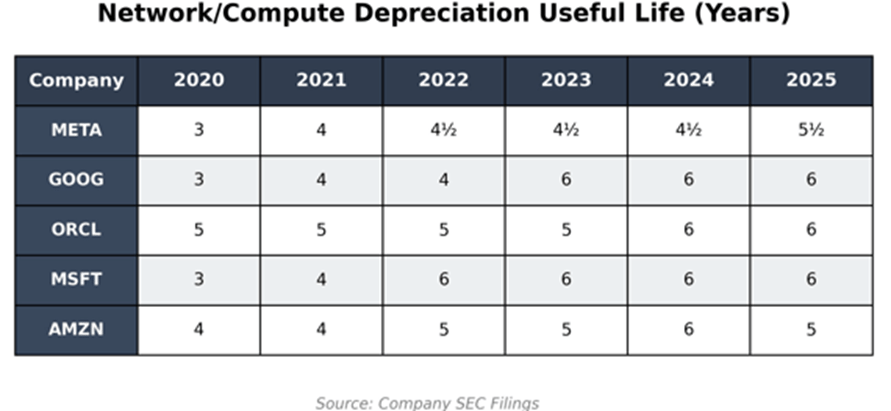

Une durée de vie qui s’allonge

Voici le tableau exact qu’a publié Michael Burry le 10 novembre dernier. Et effectivement, montré comme ça, sans explication ni contexte, les chiffres sont inquiétants.

Cependant (et tu te doutes qu’il n’y aurait pas eu une newsletter sans “mais”), il s’agit ici d’un simple reflet de l’évolution du business.

Pour ce qui est du matériel réseau 🛜, la dépréciation était déjà supérieure à 5 ans, souvent plus proche de 8 ans. En réalité, le matériel réseau est souvent changé lors du changement de la topologie et de l’architecture réseau.

Comme ça, on fait d’une pierre deux coups et on évite de supporter une architecture datée sur un matériel plus récent. Ici, les hyperscalers co-développent le matériel avec l’architecture, ce qui permet d’avoir des performances optimisées.

Pour ce qui est des GPUs et serveurs 🖥️ en revanche, là c’est une autre histoire. Pour tout ce qui est serveur classique (x86/AMD64/ARM64), la dépréciation est la même que pour le matériel réseau. C’est du matériel stable, qui ne génère pas trop de chaleur ♨, facile à maintenir, donc qu’on peut utiliser longtemps.

De plus, les évolutions apportées par les nouvelles générations de puces n’apportent qu’un gain de performances marginal.

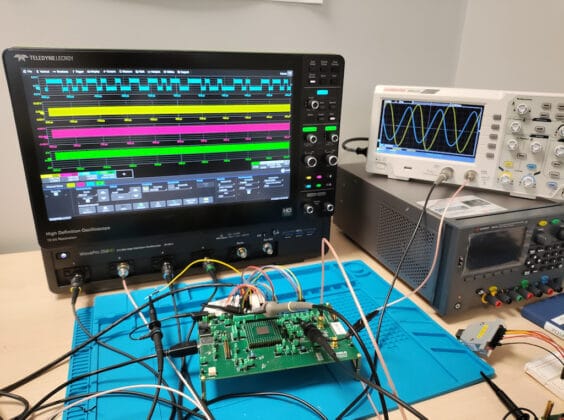

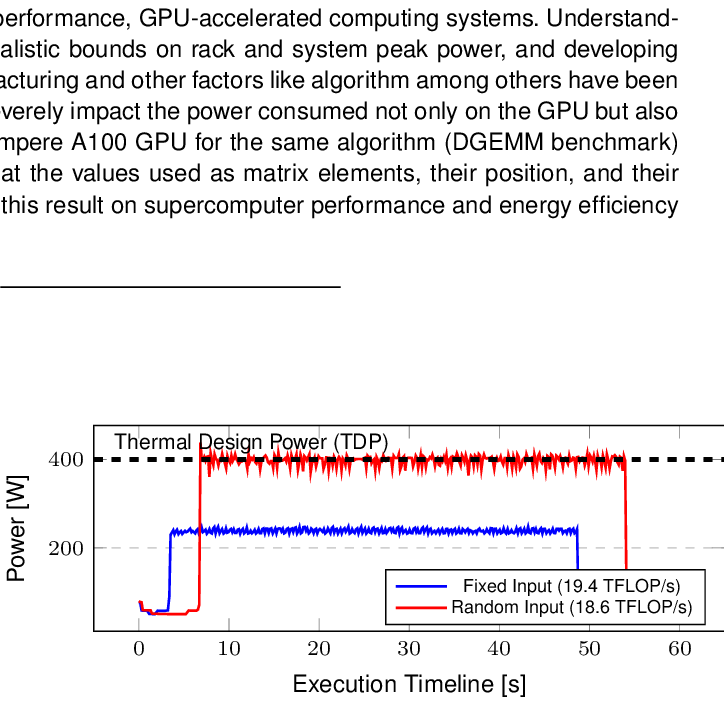

Les GPUs, par contre, avaient historiquement un cycle de dépréciation plus rapide 🔄. Pour cause, c’est du matériel qui chauffe beaucoup plus 🔥, avec plus d’erreurs de kernel (noyau système) et ECC (mémoire auto-correctrice d’erreurs), donc plus dur à maintenir.

⚡ Point à noter: la chauffe et l’utilisation d’un processeur accentue directement son usure (augmentation de l’électromigration). Utiliser un CPU ou un GPU 100% du temps peut diviser par plus de 2 sa durée de vie par rapport à une utilisation normale (70% de charge).

C’était particulièrement vrai sur les architectures Tesla (V100) et Ampere (A100) qui étaient les premières instances déployées dans le cloud ☁(notamment chez AWS avec P3 et P4). Cependant, tous les acteurs ont travaillé d’arrache-pied pour améliorer la fiabilité des puces.

Du côté des hyperscalers, des mécanismes ont été mis en place pour isoler les GPUs instables. Les erreurs matérielles sont détectées🕵️♂️ proactivement avec une quarantaine automatique. La télémétrie a vu aussi son lot d’amélioration avec des pannes détectées avant qu’elles arrivent et les GPUs sont remplacés préventivement.

Le refroidissement ❄ a vu arriver de nombreuses avancées comme le passage au refroidissement liquide direct-to-chip, ce qui a permis de réduire les “hotspots”, le thermal cycling et de limiter l’électromigration, notamment dans les interposeurs et les interconnexions avec la HBM.

Les progrès dans le refroidissement ont aussi permis de stabiliser la HBM qui est hyper sensible à la chauffe ♨. Avec des températures plus basses, on a aussi moins d’erreurs ECC et des fréquences plus stables.

Une autre amélioration, souvent oubliée et sous-estimée, est celle sur les alimentations ⚡ qui sont bien plus stables. Elles sont maintenant beaucoup plus rapides pour switcher 🎚️ en cas de panne, et elles sont désormais capable de gérer les pics d’intensités ⛰ qui arrivent régulièrement dans les workloads IA.

Les pannes d’alimentation étaient d’ailleurs la cause n°2 des défauts sur les puces P100/V100, derrière les pannes liées au refroidissement.

Nvidia, de son côté, a procédé à une refonte totale du kernel, notamment depuis Ampere et Hopper. Cette refonte a permis une amélioration de la gestion des page-faults, une meilleure stabilité du MIG (le fait de pouvoir partitionner son GPU, c’est très utilisé en cluster IA) et un meilleur scheduling 🕛 interne.

Beaucoup d’erreurs pré-A100 venaient en réalité des interactions kernel - GPU driver. Aujourd’hui, le software des puces Nvidia est 10 fois plus stable en environnement cloud qu’en 2019.

Hopper a par ailleurs introduit une nouvelle hiérarchie ECC, de la redondance dans certaines structures mais aussi une isolation fine des erreurs. Ainsi, une erreur locale ne fait plus planter tout le GPU.

Les nouvelles générations d’NVLink, NVSwitch et PCIe implémentées par Hopper et Blackwell sont aussi beaucoup plus stables, ce qui permet une réduction des erreurs de communication (CRC) lors des sessions d’entraînement de modèle IA 🤖.

Côté supply chain, Nvidia a aussi procédé à quelques ajustements. Le testing est beaucoup plus agressif depuis Hopper avec des phases renforcées sur le burn-in, le HTOL (High Temperature Operating Life) et le stress test de la HBM et de l’interposeur.

Je ne rentrerais pas dans le détail sur le testing, ça fera l’objet d’une prochaine newsletter. Aujourd’hui, le testing a pris une place prépondérante et Nvidia n’y est pas pour rien.

Les GPUs sont désormais testés plus longtemps 🕛 et Nvidia collabore étroitement avec TSMC pour détecter les défauts systémiques. Le taux de puces DOA (Dead On Arrival) a drastiquement chuté, tout comme le taux de early-life-failure.

Par ailleurs, les besoins évoluent rapidement. Il y a encore deux ans, l’entraînement représentait la grande majorité de l’utilisation des GPUs — souvent plus de 70% selon les workloads. Aujourd’hui, on peut raisonnablement estimer que l’entraînement tourne plutôt autour de 40 à 50% de l’utilisation totale, le reste étant absorbé par l’inférence.

Si l’entraînement est extrêmement intensif 😮💨 et très sensible aux pannes GPU, l’inférence l’est beaucoup moins. Une puce utilisée en entraînement dépasse rarement 2 à 3 ans sur des modèles de pointe, mais elle peut ensuite être reconvertie ♻ pour de l’inférence — un usage plus irrégulier, par pics, qui limite l’usure et prolonge sa durée de vie effective.

Toutes ces mécaniques 🛠 ont rendu les puces beaucoup plus stables et fiables qu’il y a ne serait-ce que 5 ans. Comme il n’y a plus besoin de renouveler les puces tous les 3 ans par manque de fiabilité et que les besoins évoluent, la durée de dépréciation s’est mécaniquement adaptée pour mieux refléter la réalité de terrain.

⚡ Petite note à part:

Je ne souhaite pas discréditer Michael Burry. Cependant, pour accuser les hyperscaler de frauder car ils mentiraient sur la durée de vie utile des puces, encore faut-il avoir les données de renouvellement.

Or c’est une donnée extrêmement sensible qui n’est jamais fournie car elle donne une indication directe sur la stratégie des hyperscalers et sur leur compétitivité. Même moi qui travaille chez AWS je n’y ai pas accès: ces informations sont strictement cloisonnées et réservées à un périmètre très restreint.

La demande insatiable et des puces économiquement viables plus longtemps que prévu

Cependant, ce n’est pas le seul argument de Michael Burry. Il pointe du doigt une demande bien plus faible que prévue, avec un prix à la location qui s’effondre 📉 et des puces qui perdent jusqu’à 90% de leur valeur après 3 ans.

Ce n’est pas exactement ses mots, il a plutôt comparé avec un iPhone qui perd 90% de sa valeur après 3 ans. Je ne sais pas d’où il tient ses chiffres mais je te mets au défi de trouver un iPhone 14 à moins de 350-400€, même en occasion (900€ neuf donc -60% au maximum après 3 ans).

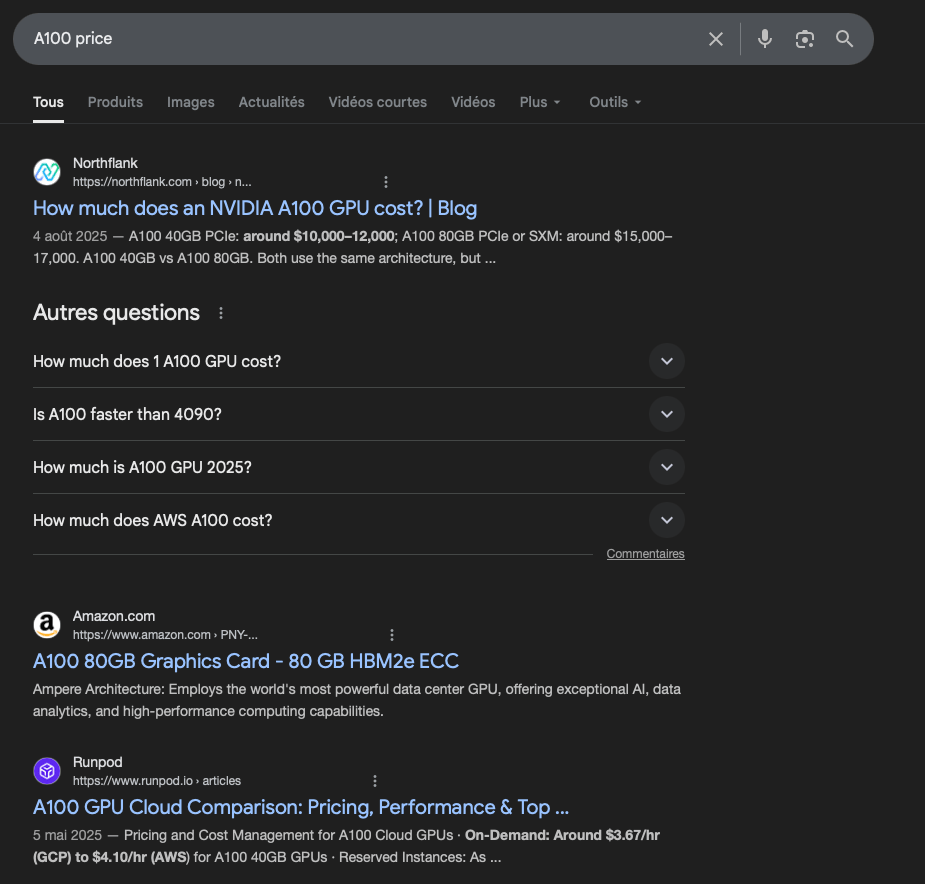

C’est à ce moment que ça va être extrêmement compliqué pour moi de rester neutre dans mon approche, car une simple recherche sur Google sert à démontrer qu’il a tort.

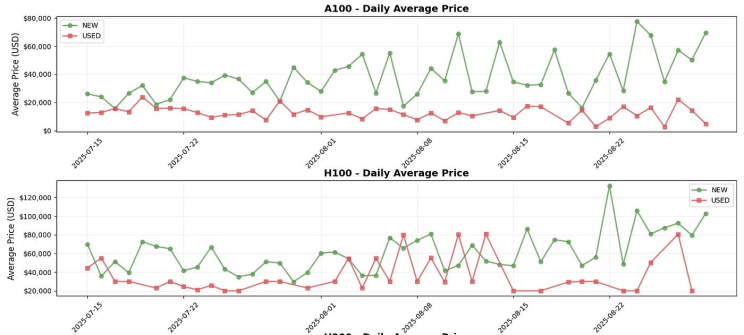

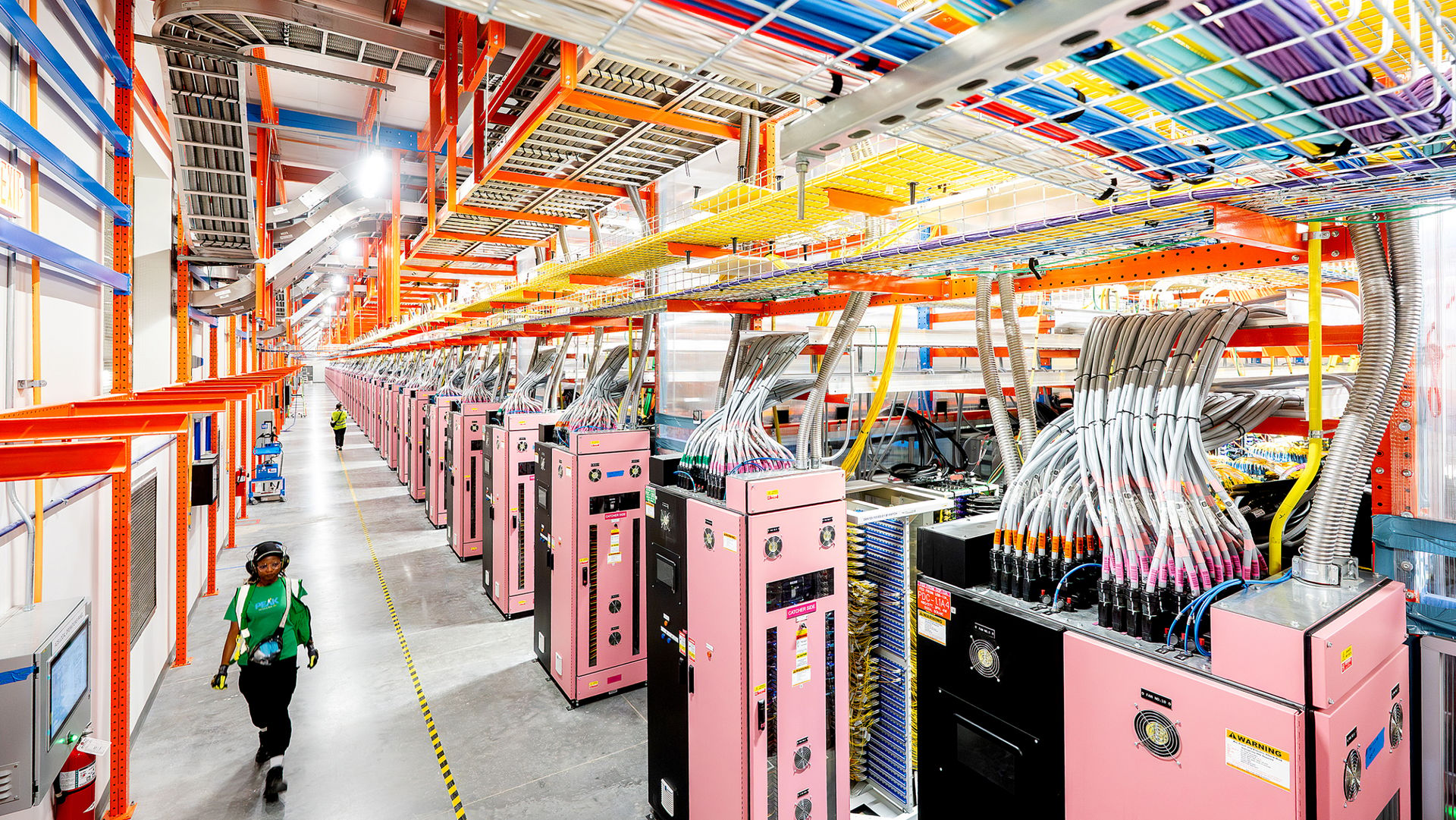

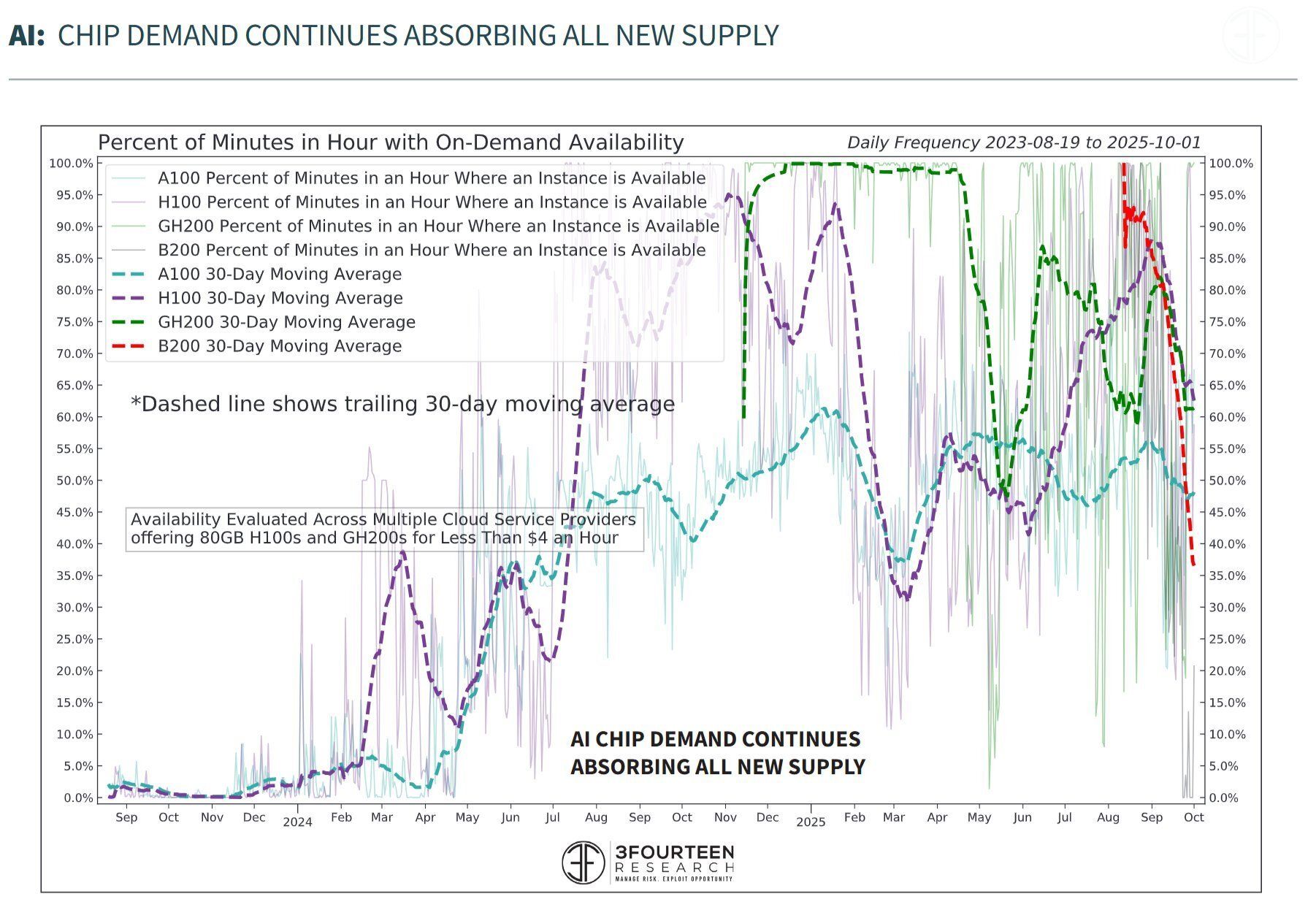

Ci-dessous, tu peux trouver un graphique illustrant la disponibilité des GPUs Nvidia “on-demand”, c’est-à-dire sans contrat préalable (en pay-as-you-go), ce qui représente une infime partie du marché actuel sur le cloud IA👇

On peut y voir notamment qu’en Octobre, la disponibilité des A100 était plus faible🔻 qu’en Janvier/Février dernier, pour une puce vieille de 5 ans, alors même que des clusters NVL72 GB200/300 sont en train d’être déployés massivement…

Par ailleurs, on peut aussi écouter le discours des hyperscalers qui sont contraints par la loi de dire la vérité 👇

"[…] nous sommes… et je l’ai déjà dit, cela fait maintenant plusieurs trimestres que nous sommes en situation de pénurie. Je pensais que nous allions rattraper le retard, mais ce n’est pas le cas. La demande augmente. Et elle n’augmente pas dans un seul domaine: elle augmente partout."

"Sur GCP, nous observons une forte demande pour l’infrastructure d’IA destinée aux entreprises — incluant les TPUs et GPUs — ainsi que pour les solutions d’IA pour entreprises […]. Comme je l’ai déjà mentionné lors de précédents appels de résultats, bien que nous travaillions intensément à augmenter notre capacité — et que nous ayons accéléré le rythme de déploiement des serveurs et de construction des data centers — nous nous attendons malgré tout à rester dans un environnement où la demande excède l’offre au quatrième trimestre et en 2026."

"Du côté de la capacité, nous avons ajouté une quantité significative de ressources — comme je l’ai mentionné dans mes remarques d’ouverture, 3.8GW de capacité au cours de l’année écoulée, avec plus d’un GW supplémentaire attendu au quatrième trimestre, et nous prévoyons de doubler notre capacité totale d’ici la fin 2027. […] Et aussi vite que nous l’ajoutons, nous parvenons à la monétiser."

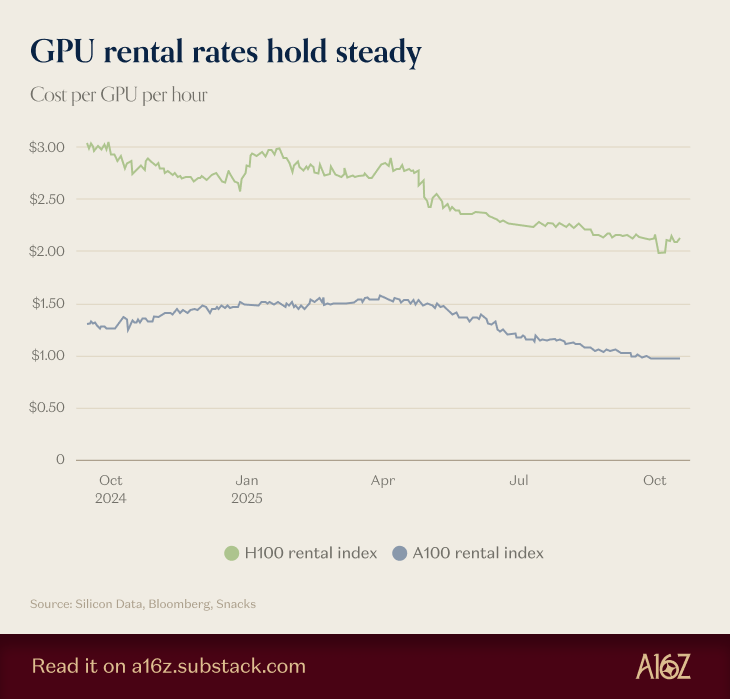

Concernant le prix à la location, c’est exactement la même dynamique. Même si les prix à l’heure sont à la baisse 📉 parce que Blackwell commence à être disponible, on remarque une forte stabilité des prix…

Ce graphique, issu de A16Z, montre d’ailleurs les prix globaux, incluant les prix à la location fixés sur des contrats longue durée, ainsi que les prix pour différentes configurations de puces (les A100 sont disponibles en 40 et 80Go - sans parler de la taille des clusters). En pay-as-you-go, difficile de trouver une A100 à moins de 1.4-1.5$/h.

Cependant, ce graphique ne dit pas tout… Est-ce que c’est encore rentable de louer une A100 pour un CSP (Cloud Service Provider) 🤔 ? Alors, même si le bon sens nous ferait dire que oui, je pense qu’on peut vérifier ça par le calcul.

Pour ça, je vais regarder le coût opérationnel de chaque puce (combien d’électricité elle consomme). Ça va nous permettre de savoir à partir de quel seuil, en excluant l’investissement initial sur la puce et l’infrastructure, les CSP sont rentables. Pour information, le prix moyen du kWh pour les entreprises aux US est de 0.125$ à 0.14$ actuellement.

Une A100 consomme au maximum 400W ⚡. Soyons un peu généreux et estimons que le réseau consomme 400W supplémentaire (il consomme probablement beaucoup moins que ça). Ça fait une consommation maximale de 800W. Dans la réalité, on est plus proche des 50-70% de charge, même en pay-as-you-go, ce qui fait une consommation totale de 560W soit 0.07$ à 0.0784$ par heure.

Une H100 consomme au maximum 700W ⚡. Le réseau consomme à peu près la même chose, ce qui fait une consommation maximale de 1100W. Donc à 70% de charge, on se situe à 770W de consommation maximale, soit 0.9625$ à 0.1078$ de l’heure.

Pour s’amuser, prenons en compte le prix d’achat. Disons qu’une A100 (80Go) a été payée 20k$ et qu’une H100 a été payée 30k$. Pour refléter la réalité, disons que l’infrastructure rajoute 10k$/puce (le bâtiment dure bien plus longtemps que la puce) et qu’on met 5k$ de plus pour le changement de pièces défectueuses.

Avec un amortissement sur 4 ans (donc plus conservateur qu’actuellement), et une charge de 50% (louée 50% du temps), une A100 a un amortissement horaire de 2$/h sur 4 ans et 2,57$/h pour une H100.

Pour résumer: si la puce n’est louée que 50% du temps et amortie sur 4 ans (contre 5 à 6 actuellement), les CSPs sont rentables sur la location au dessus de 2,67$/h pour une H100.

⚠ Attention, j’ai volontairement pris des hypothèses conservatrices. Les hyperscalers négocient les prix des puces et de l’infrastructure et la majorité des puces achetées aujourd’hui le sont pour un contrat, et donc louées 100% du temps (mais à un prix préférentiel).

Concernant le prix de revente, le discours est le même:

Les prix sont relativement stables et les GPUs se revendent très bien, même utilisés, même vieux de 3 ans (c’est le cas pour la H100). Une H100 d’occasion se revend dans les 20k$ soit une décote d’environ 20 à 35% de son prix neuf, loin des chiffres annoncés par Michael Burry.

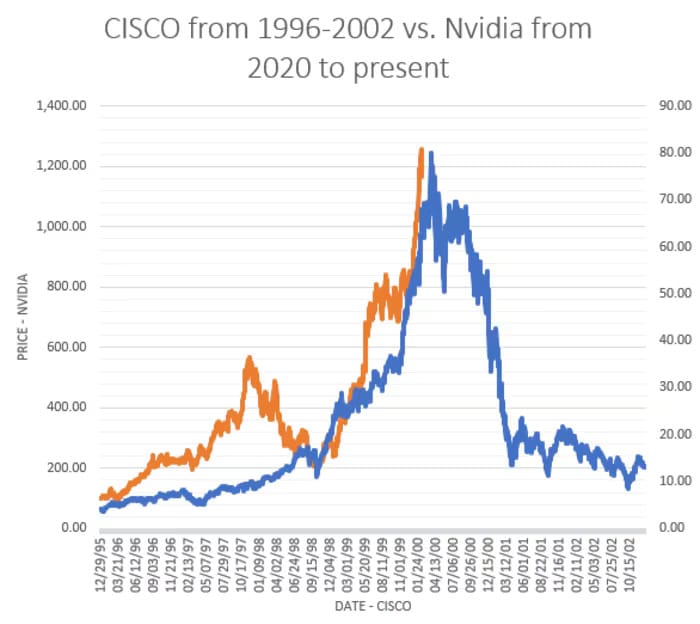

😱 Nvidia: le nouveau Cisco ?

Cependant, Michael Burry ne s’est pas arrêté là: il a comparé Nvidia à Cisco pendant la bulle 🫧 internet. Et il n’est d’ailleurs pas le seul, on peut régulièrement voir des graphiques comme celui ci-dessous 👇

En dehors du fait que superposer des courbes n’a rien d’intellectuellement pertinent, je pense que la situation n’est absolument pas la même, même si ça mérite d’être creusé.

Une valorisation stratosphérique

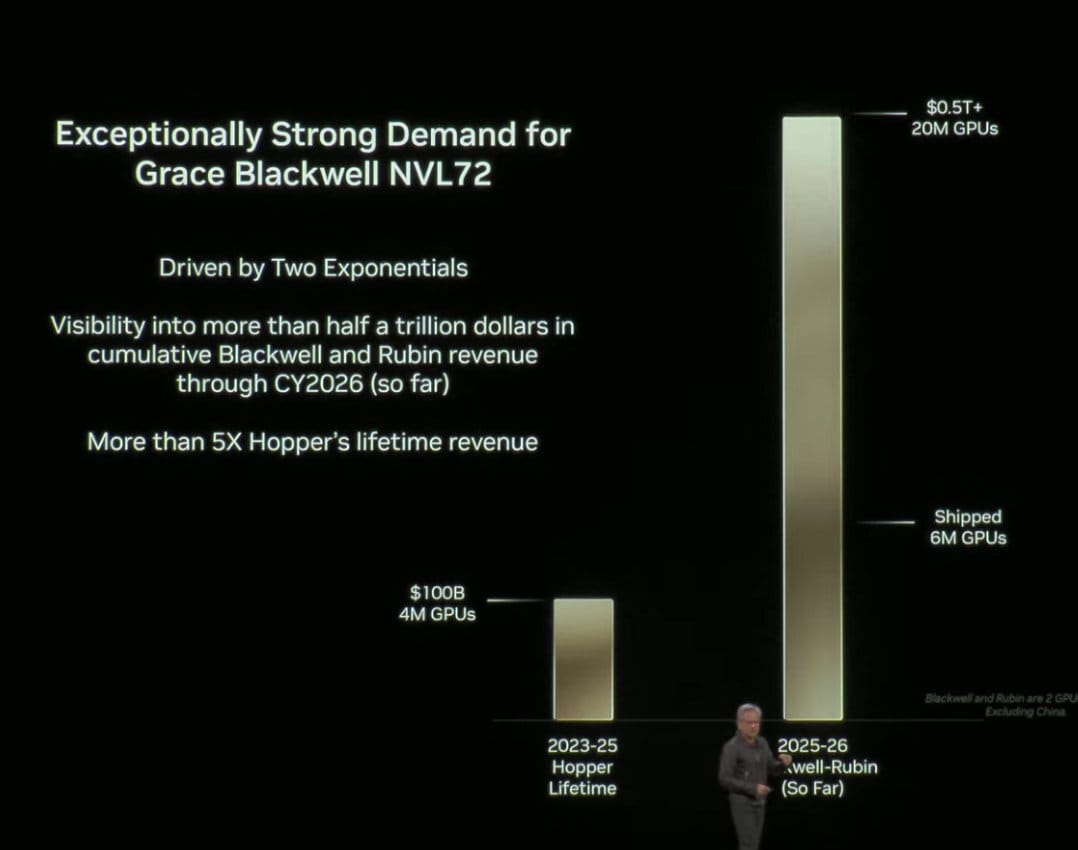

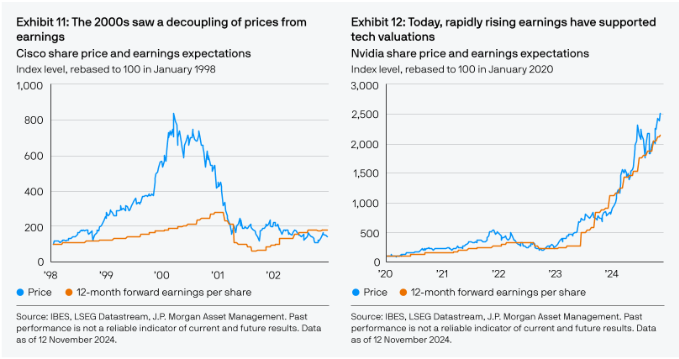

Le point qui revient le plus souvent, c’est celui sur la valorisation. Et effectivement, 45 de PER (la valorisation actuelle d’Nvidia), c’est beaucoup. Mais c’est omettre la croissance 📈: il y a ne serait-ce qu’un an, Nvidia faisait 35B$ de chiffres d’affaires par trimestre, aujourd’hui, c’est 57B$, le tout avec des marges équivalentes.

Avec une telle croissance, si on veut correctement valoriser Nvidia, il faut prendre soit un PER actualisé (dernier trimestre x4), soit le PER à un an, soit le PEG. Et ici, on a 35 de PER actualisé, 25 de PER à un an et 0.8 de PEG. C’est loin d’être survalorisé…

Cependant, je vais anticiper ton commentaire: non, même s’il s’agit de prévisions, il n’est pas déraisonnable d’utiliser ces ratios de valorisation. Nvidia a annoncé le 28 octobre avoir un backlog de 350B$💰sur les 4 prochains trimestres, donc la visibilité est là. Et le pire, c’est qu’il y a fort à parier qu’ils fassent mieux.

Par ailleurs, il ne faut pas non plus oublier la définition d’une bulle 🫧: il s’agit d’une déconnexion entre les fondamentaux d’une entreprise et sa valorisation. Si on prend le cas de Cisco en 2000, elle s’échangeait à 200 fois le PER à un an 🤯, soit 8 fois plus qu’Nvidia actuellement.

Si Nvidia était l’équivalent de Cisco de la bulle internet, il faudrait que l’entreprise s’échange actuellement à 35T$ de valorisation, ou 1 456$ par action…

Là où je trouve la comparaison encore plus hasardeuse c’est qu’elle ne prend pas en compte le contexte. Pendant la bulle internet, on a construit des infrastructures 🏭 en espérant avoir une demande du côté applicatif.

Ça a mené à des surinvestissements et à une construction de capacité non-nécessaire, le tout en employant de la dette et des mécanismes de crédit-vendeur.

Quand les fonds d’investissements ont arrêté 🛑 de financer les projets non-rentables, nombre d’entreprises se sont retrouvées en faillite et dans l’incapacité de payer les dettes contractées. Ça a fait chuter ⏬ d’autant plus la demande pour de l’infrastructure.

La situation pour l’IA 🤖 est totalement différente. Aujourd’hui, les entreprises ont un besoin d’automatisation. Les clients sont déjà là et prêt à payer cher, comme JP Morgan qui dépense 2B$ par an dans l’IA et a annoncé être rentable sur ses investissements.

Les infrastructures sont financées par les cash flows 💵 des entreprises les plus riches du monde, qui n’ont aujourd’hui quasiment aucune dette et des milliers de milliards dans leurs comptes en banque.

La vraie différence est là: pas ou peu de dettes contractées et une pénurie d’infrastructures face à une demande qui vient du côté applicatif, tout l’inverse de la bulle internet.

Les deals circulaires

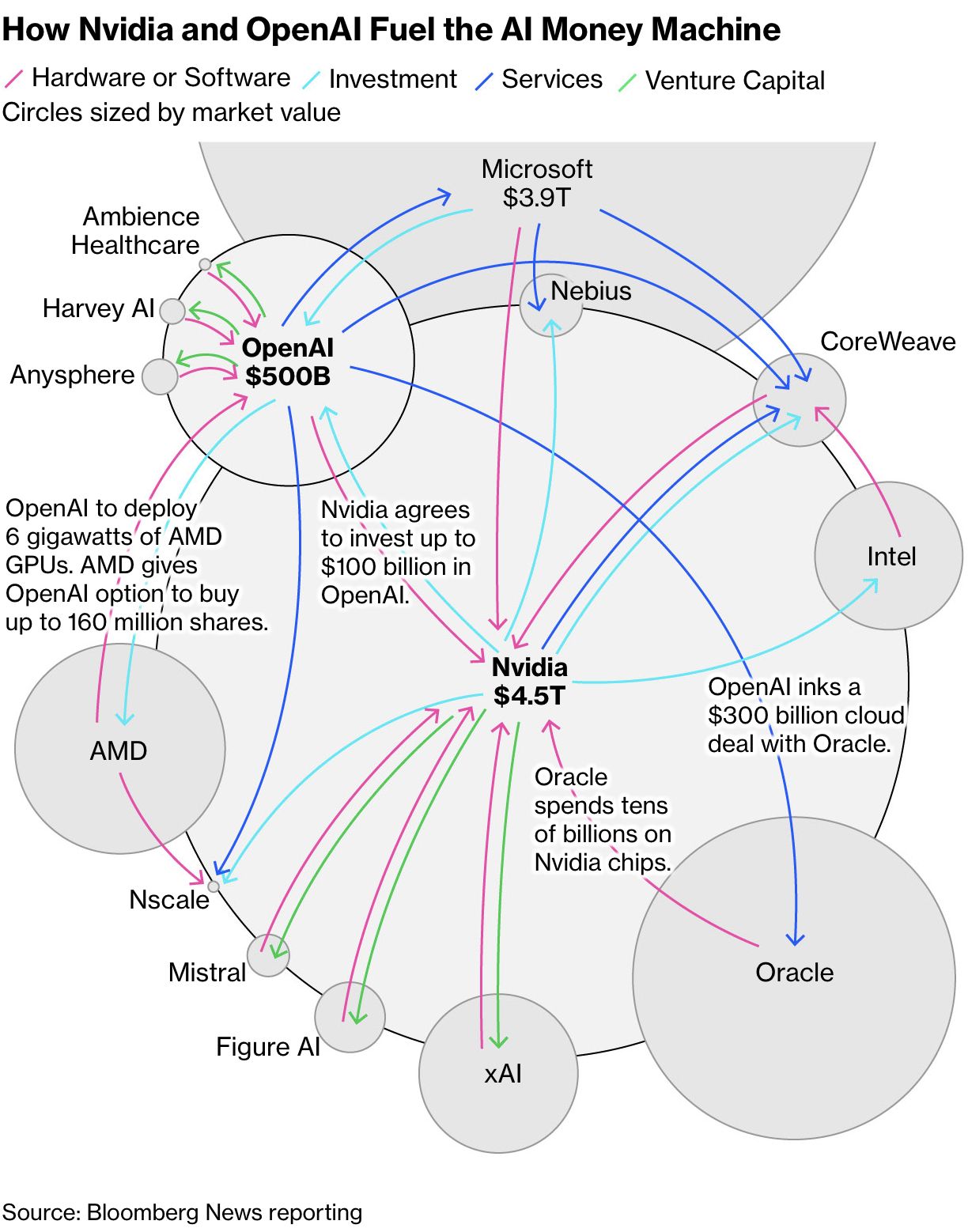

Cependant, ce n’est pas le seul argument de Michael Burry. Il a utilisé le graphique ci-dessous pour parler des deals circulaires ♻ et accuse Nvidia de financer directement la demande pour ses propres puces (il n’est pas le seul d’ailleurs).

Alors, effectivement, la critique est valide. Cependant, je pense que le problème sous-jacent est bien plus complexe qu’il n’en a l’air.

En réalité, les géants de la tech ont une montagne de cash 💰tellement immense qu’ils se substituent aujourd’hui beaucoup aux fonds de VC (Venture Capital) ou même aux banques. Ces entreprises financent de nombreuses startup dans l’espoir de pouvoir les racheter un jour si elles explosent.

D’ailleurs, les montants engagés sont tellement colossaux que le système bancaire et de financement par les VC arrive aujourd’hui à ses limites 🛑. Il ne reste donc plus que les géants de la tech pour financer des projets aussi ambitieux.

Là où Microsoft, Alphabet, Amazon et les autres hyperscalers construisent leur infrastructure et donc limitent aujourd’hui les financements de startup, Nvidia se retrouve avec un problème tout nouveau pour eux: ils ont trop d’argent 💰.

Dit comme ça, ça peut faire rire: qui ne voudrait pas être dans la même situation ? Sauf que dans le cas d’une entreprise, ne pas savoir que faire de son capital peut être fatal.

Une entreprise a 4 manières d’utiliser son cash: l’investissement, soit dans son propre business, soit en rachetant des entreprises; le retour à l’actionnaire via les rachats d’action ou un dividende; réduire sa dette; ou ne rien faire et le garder pour plus tard.

Le souci c’est qu’il faut prendre en compte la rentabilité:

Du cash gardé pour plus tard, il faut qu’il serve à quelque chose à un moment donné, sinon c’est juste une perte de rendement pour l’actionnaire.

Le réinvestissement dans son business c’est bien, mais est-ce qu’il y a un intérêt ? Si le retour sur investissement n’est pas assez important, autant retourner cet argent aux actionnaires…

Nvidia n’a pas de dettes actuellement et a une dette nette de -50B$, donc cette option est caduque.

Son business est majoritairement à coûts fixes donc l’option du réinvestissement dans le business est limitée. Nvidia rachète déjà massivement ses actions, un plan de 50B$ de rachats est en cours.

L’entreprise ne veut pas non plus de l’option du dividende: une fois mis en place, on est contraint de l’augmenter pour satisfaire les actionnaires (rien d’officiel ou d’obligatoire, il s’agit plus d’un accord tacite).

Il ne reste plus que l’option d’investir le cash ailleurs, dans des startup innovantes qui peuvent générer un rendement très intéressant. D’ailleurs, le simple fait qu’Nvidia se positionne fait souvent grimper les cours 📈 (il n’y a qu’à voir le cours d’Intel).

Nvidia investit ici dans son secteur et c’est une pratique courante. Il s’agit simplement d’une stratégie d’allocation de capital, même si elle peut être discutable.

🚨 Les vrais problèmes autour de l’IA

Malgré tout, je pense qu’il y a effectivement certains problèmes autour de l’écosystème IA actuel, c’est juste qu’ils ne se situent pas où Michael Burry les voit.

Le cas OpenAI

Premièrement, parlons d’OpenAI, même si je pourrais probablement faire une newsletter entière à leur sujet…

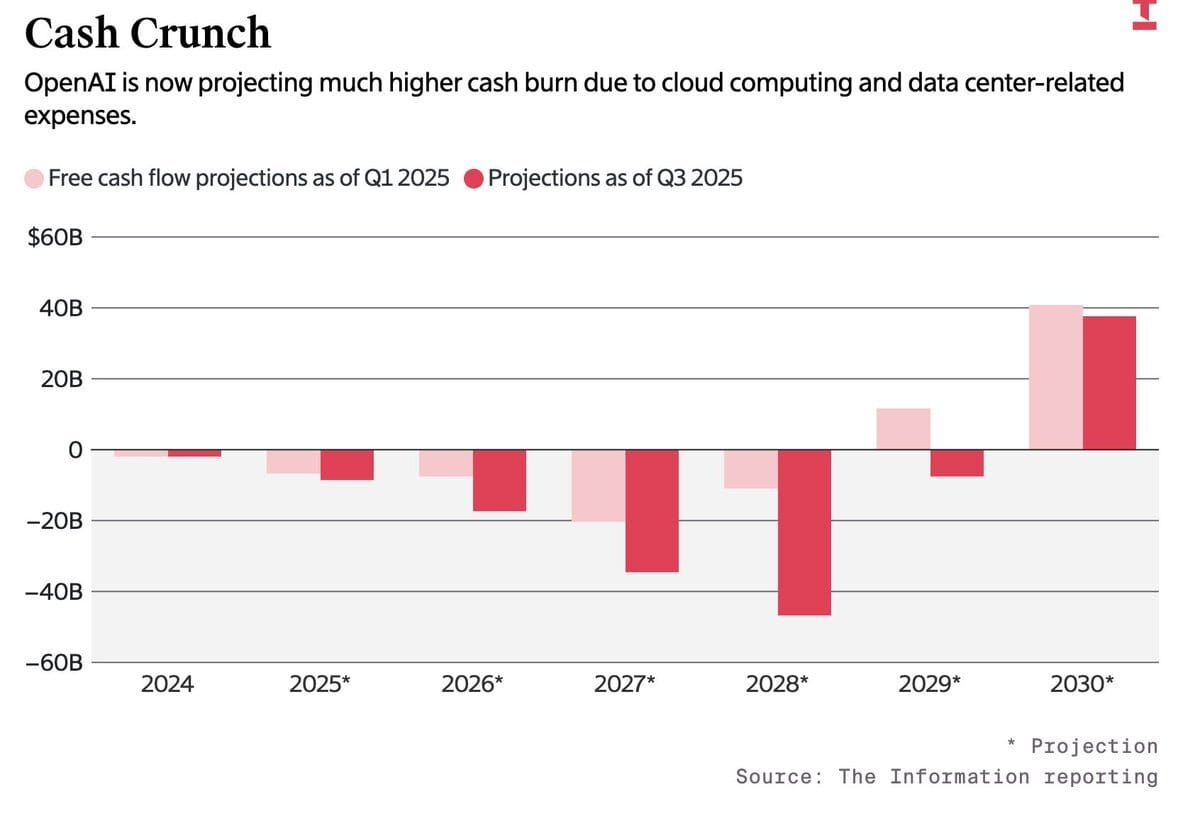

Ils se sont engagés sur 1.4T$ de dépenses en infrastructures IA 🤯, mais avec quel argent ? Car oui, OpenAI fait probablement 13B$ de chiffres d’affaires annuel en 2025 mais trouve quand même le moyen de générer 8.5B$ de pertes 💥.

Au vu de leurs engagements, leur plan de rentabilité à horizon 2030 me paraît plus qu’illusoire. Ils prévoient de construire 26GW ⚡ de capacités de calcul, soit l’équivalent de la capacité actuelle cumulée d’AWS, Azure et GCP 🤯(cloud traditionnel + cloud IA).

Et ça uniquement sur du cloud IA, plus cher et complexe à maintenir, et sans l’expertise que ces entreprises ont pu acquérir sur plus d’une décennie. Tout ça en ne générant “que” 200B$ de CA annuel (leurs prévisions).

Encore, s’ils construisaient eux-mêmes, pourquoi pas… Dans un scénario optimiste, c’est jouable (très optimiste). Mais là, ils passent par des proxy (Azure, GCP ou OCI), qui eux aussi doivent faire leur marge…

Mon avis c’est que, soit une partie des deals passeront à la trappe ❌, soit ils n’atteindront pas la rentabilité avant 2035 ❌. Et je parierais plus sur un scénario intermédiaire, avec une rentabilité pas avant 2032 et une partie des deals révisés à la baisse. Mais entre-temps, il faudra probablement financer des pertes se chiffrant en centaines de milliards de dollars.

Une structure financière douteuse

Mais si ce n’était qu’OpenAI, ça irait encore… Prenons le cas de Meta: par un jeu de structures financières opaque, Meta réussit à contracter de la dette et à la laisser hors bilan, ce qui fait apparaître l’entreprise sous un meilleur jour qu’elle ne l’est vraiment.

Pour faire simple, Meta et Blue Owl Capital ont créé un véhicule financier, une SPV, qui investit dans des datacenters 🏭. Meta est garant de cette société, ce qui lui permet de s’endetter à moindre coût. Techniquement, les datacenters n’appartiennent pas à Meta directement, mais à la SPV, qui loue les datacenters à Meta, qui lui-même opère ces datacenters…

Mais ils ne sont pas les seuls: Oracle par exemple s’endette pour construire de l’infrastructure IA pour OpenAI, sauf qu’ils n’ont pas les moyens de payer pour. Oracle fait donc un crédit vendeur en même temps que de s’endetter pour un revenu plus qu’incertain 😕 car il dépend des financements que pourra lever OpenAI.

Autant pour Meta on ne parle “que” de 40B$ de dettes, avec une entreprise qui reste encore peu endettée, mais pour Oracle, OpenAI a signé pour 300B$ de contrat…

D’ailleurs, Moody’s l’a remarqué et a émis un avertissement 🚩sur la dette d’Oracle. Les CDS sur Oracle ont d’ailleurs bien monté ces derniers temps, montrant que le marché commence à réaliser le problème, même si Oracle reste encore loin d’une situation de faillite.

Mais ça c’est pour les acteurs encore solides… Si on parle des neo-cloud comme CoreWeave, la situation est, comment dire… particulière. En effet, CoreWeave s’endette en mettant en collatéral ses GPUs pour payer… des GPUs 🚨.

Si cette mécanique fonctionne actuellement car on est en période de pénurie, elle reste tout de même risquée. Les GPUs sont des actifs à courte durée de vie et (même si ce n’est pas le cas aujourd’hui) ne gardent pas leur valeur dans le temps.

Si CoreWeave se retrouve dans l’incapacité de rembourser ses dettes dans quelques années et qu’il n’y a plus de pénurie sur les GPUs, il y a fort à parier que les créanciers subissent de lourdes pertes 🚨. Sans parler des actionnaires qui perdront probablement tout.

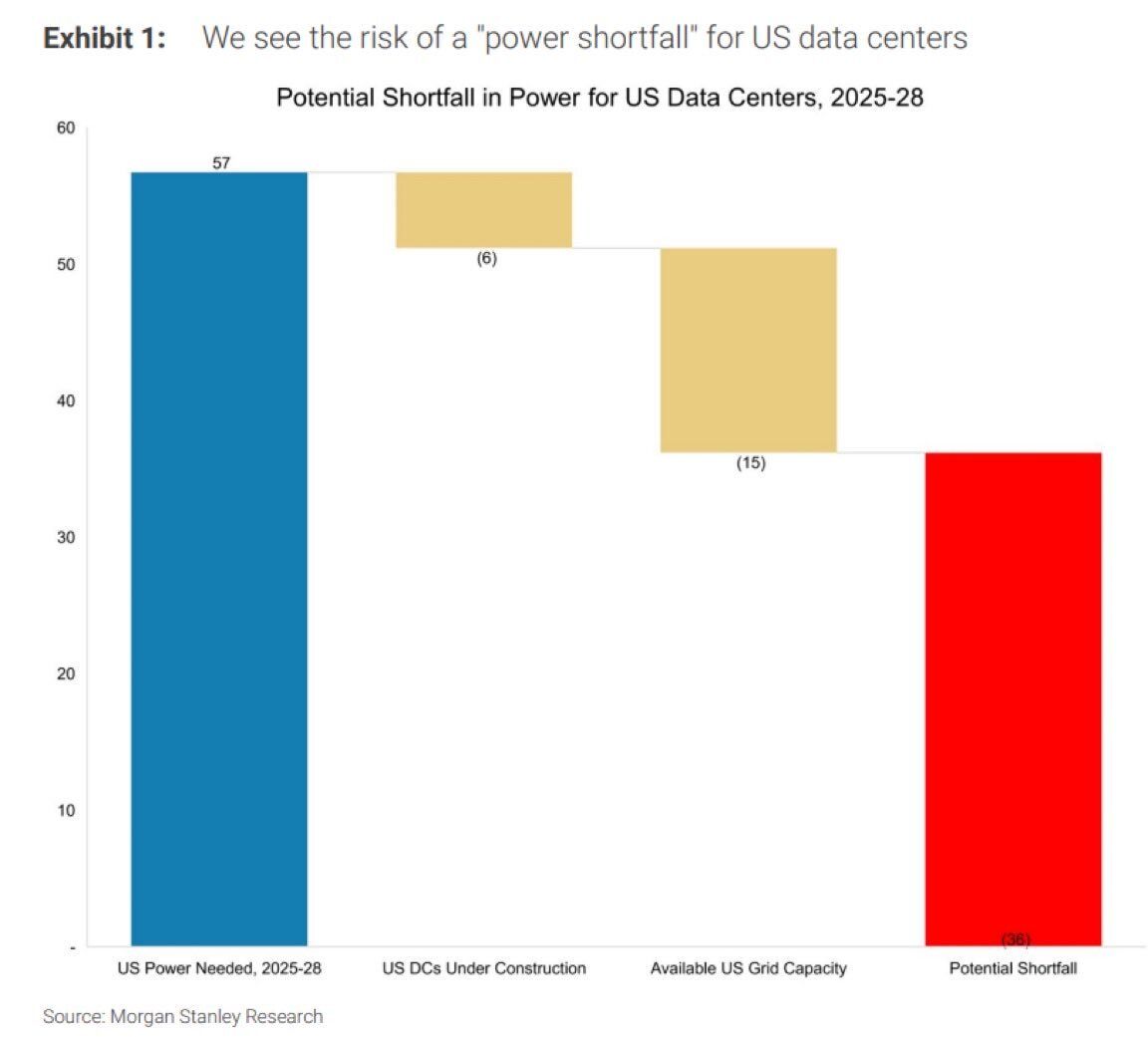

Un accès à l’énergie limité

Mais tout ça ce n’est qu’une partie du problème. J’en parle depuis plus d’un an et demi: l’énergie ⚡ est le vrai sujet sur l’IA. On trouvera toujours le moyen d’imprimer des billets, mais imprimer de l’électricité, on ne sait pas faire.

Les délais s’allongent sur l’approvisionnement de composants critiques pour les centrales, qu’elles soient à gaz ou nucléaires ☢. La grid énergétique aux US est vieillissante et absolument pas conçue pour supporter la demande sur des datacenters d’1GW.

Le solaire et l’éolien sont trop intermittents pour des datacenters nécessitant une alimentation des plus stables possibles. Et, même si le problème pourrait se régler partiellement avec des batteries 🔋, il s’agit plus d’un pansement que d’une réelle solution.

Et je n’évoquerai même pas le charbon car je doute qu’on ait envie de vivre dans des villes embuées en permanence.

Conclusion

Tout au long de cette newsletter, j’ai essayé de t’apporter mes lumières. Selon moi, les arguments de Michael Burry sont basés sur des données erronées. Il n’y a pas vraiment de soucis avec les hyperscalers, si ce n’est une question sur la rentabilité future.

Côté Nvidia, la comparer avec le Cisco de la bulle internet me paraît absurde, tant sur le point financier que technique. Le contexte n’est absolument pas le même.

Malgré mon discours globalement enthousiaste sur l’IA, il reste bien évidemment des problèmes autour d’un écosystème IA qui devient de moins en moins sain. Rien d’alarmant pour le moment, mais quelque chose qui faut garder à l’esprit et surveiller du coin de l’oeil.

J’ai tenté d’exposer au mieux mes arguments; le reste t’appartient. À toi de tirer tes propres conclusions sur les accusations de Michael Burry et sur l’état réel de l’écosystème IA aujourd’hui.