Cet article est un portage de mon Medium et a été publié originellement le 3 Juillet 2024

Cet article est extrait d’un article que j’ai publié la semaine dernière sur le club d’investisseurs «Club Bourseko». Si tu souhaites y adhérer, suis le lien ici: https://www.bourseko.fr/upgrade

La semaine dernière un de mes collègues m’a envoyé un article qui parlait des problématiques actuelles rencontrées en data center, plus spécifiquement sur les cluster GPUs dédiés à l’IA générative. Cet article, que je vous ai déjà partagé, fera l’objet d’un thread sur mon compte X mais je souhaitais vous proposer son analyse en avant première tant il distille de l’information essentielle pour comprendre la révolution qui est en marche.

Lien de l’article: https://www.semianalysis.com/p/100000-h100-clusters-power-network

En tant qu’investisseur, on entend souvent qu’investir sur la tendance actuelle est le meilleur moyen de se brûler les ailes vu que tout le monde possède déjà les valeurs en portefeuille, qu’elles sont déjà fortement valorisées et donc que leur potentiel de croissance est limité, surtout quand on parle d’entreprises les plus fortement capitalisées en bourse comme ici avec la tech américaine.

C’est vrai qu’il est difficile d’imaginer un Microsoft ou un Nvidia aller encore plus haut et il est plus facile de se dire qu’on devrait avoir le retour d’une croissance plus normale, ce qui implique que ces sociétés ne présentent pas les meilleures opportunités pour nos portefeuille. Je pense cependant que cette réflexion omet deux point importants.

Premièrement, la tendance depuis plus de 20 ans est à la digitalisation et tournée vers une adoption massive du cloud public en passant par les grands fournisseurs de Cloud que tout le monde connaît: Azure avec Microsoft, AWS avec Amazon et GCP avec Google. La croissance du secteur attendue sur les 10 prochaines années est de 16% par an avec les services logiciels adossés au Cloud (que l’on appelle SaaS pour Software as a Service) qui devraient capter la majeure partie de cette croissance. D’une part, les fournisseurs de Cloud proposent eux aussi des services logiciels en plus de leurs infrastructures mais d’autre part, l’augmentation de la demande pour le SaaS entraînera mécaniquement un accroissement de la demande pour l’infrastructure.

Si tu veux aller plus loin, je t’invite comme à l’habitude de lire la newsletter que j’ai co-écrite avec Bourseko ici: https://www.bourseko.fr/p/comment-gafam-dominent-cloud

Deuxièmement, au même titre qu’internet, l’IA générative devrait bouleverser nos vies. Pour commencer chez les professionnels où il sera plus facile de facturer les services ou d’augmenter le prix des prestations sur le dos de l’augmentation de la productivité; et ensuite chez les particuliers qui adopterons la technologie quand elle sera plus mature, quand les acteurs de l’IA auront trouvé un moyen de la monétiser efficacement et quand elle sera aussi bien moins couteuse en ressource. Dans le milieu, tout le monde évoque l’arrivée de l’IA générative comme au moins aussi grosse que l’arrivée d’internet. En même temps, difficile de dire le contraire quand on peut observer toutes les possibilités permises par cette dernière.

Cette longue introduction mise à part, revenons au sujet de cet analyse. Pour le résumer rapidement d’un point de vue investisseur, l’article nous dit clairement qu’il y a des enjeux majeurs dans la gestion énergétique, dans l’accroissement de la puissance de calcul avec des commandes démesurées et qui vont continuer de croître ainsi que dans les problématiques au niveau de la gestion de flux d’information par les réseaux et les technologies à notre disposition actuellement.

Cette analyse sera donc logiquement séparée en trois parties, en fonction du secteur. Je commencerais d’abord par expliquer comment fonctionne un data center, qu’est-ce qu’un cluster et quel est l’enjeu au niveau de GPUs et du matériel réseau. J’expliquerais ensuite les enjeux au niveau de l’infrastructure énergétique. Pour finir, je reparlerais des fournisseurs de Cloud. C’est parti !

La puissance de calcul et le matériel réseau

Le fonctionnement d’un data center et qu’est-ce qu’un cluster ?

Avant d’aborder cette section, je me dois de faire une digression sur les bases réseau. Pas d’inquiétude cependant, je resterai dans les basiques.

Comme beaucoup le savent, les ordinateurs communiquent à l’aide de 0s et de 1s, système que l’on nomme le binaire. Pourquoi le binaire ? Car c’est un signal qu’il est facile de générer à l’aide d’un interrupteur (0 correspondant à fermé et 1 à ouvert), et que sa conversion du format analogique à numérique laisse peu de place à l’erreur vu qu’il n’y a pas de nuance. L’inconvénient majeur c’est qu’on ne peut pas faire grand chose avec seulement deux possibilités. C’est là que viennent les octets. Un octet est un regroupement de huit bits, c’est à dire une suite de huit 0 ou 1. En prenant le modèle ASCI (modèle de représentation standard dans l’informatique), on peut associer la valeur d’un octet à une autre à l’aide d’une table de conversion.

Voilà, on est à présent en mesure de communiquer ! Cependant, pour diverses raisons techniques dans lesquelles je ne rentrerai pas en détail ici, la taille maximale d’un message envoyé au travers d’un réseau (que ce soit un réseau local ou même via internet) est de 1500 octets (c’est une norme, il en existe d’autres mais c’est celle la plus utilisée aujourd’hui). Ça peut paraître beaucoup, mais il faut comprendre que, comme pour une lettre, il faut une en-tête avec un expéditeur, un destinataire et d’autres information comme le type de message, les différents protocoles utilisés, etc… Ce qui fait que la taille maximale utilisable est de 1480 octets, ce qui correspond à un peu plus de 10 SMS. À titre de comparaison, un film aujourd’hui en qualité full HD fait environ 20 Go, soit 20 000 000 000 octets.

La bande passante de certains sites que je déploie aujourd'hui avec mon travail dépasse largement la dizaine de téra octets par seconde (soit une vitesse supérieure à 10 000 000 000 000 octets par seconde). Pour des raisons évidentes de confidentialité, je ne donnerais pas la vitesse exacte et je me contenterai de cet ordre de grandeur. Cependant, avec cette donnée, on comprend donc que les data center traitent une quantité absolument absurde de messages à la seconde, et que tout cela entraine des défis techniques impressionnants.

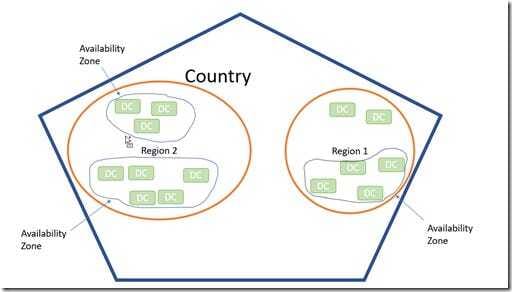

Tout ceci mis à part, essayons de comprendre la topologie réseau au sein d’un data center, mais pour commencer, regardons le concept d’availabilty zone:

Comme on peut le voir sur le graphique ci-dessus, au sein d’un même pays, on peut avoir plusieurs régions. Tout ceci permet d’éviter une surcharge et d’éviter la latence en rapprochant les data centers des multiples zones peuplées. On préfère donc avoir plus de data centers mais plus petits qu’un seul et unique gros data center (et cette information est très importante pour la suite). Au sein de la même région, on retrouve souvent plusieurs availability zone. Elles servent à mieux répartir la charge et garantir un service avec le moins de latence et de coupures possibles. Elles permettent aussi de définir une zone de maintenance, ce qui permet de mettre à jour les data center sans causer de problèmes sur le traffic.

Comme on peut aussi le voir au dessus, on a plusieurs data centers au sein de la même availability zone. Tout ceci est fait pour les mêmes raisons: éviter les coupures. Chaque data center est équipé de ses propres source de courants et de refroidissement, et chacune d’elle est redondante. Tous les data centers au sein d’une même availability zone sont interconnectés pour permettre une meilleure répartition de la charge de traffic. Regardons maintenant ensemble l’architecture au sein d’un data center:

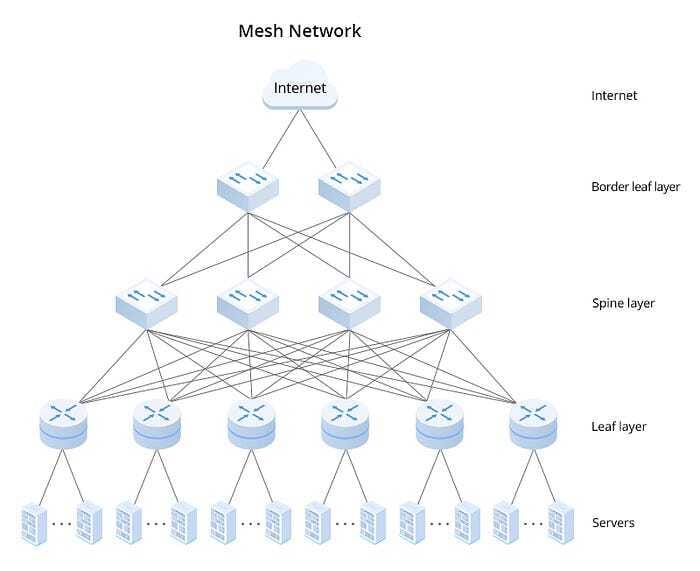

C’est bien entendu plus complexe que le schéma ci-dessus, mais globalement l’idée est la même. On peut voir ici qu’il y a plusieurs couches de routers et de switch (si vous ne savez pas ce que c’est, je vous revoie vers mon article sur Arista Networks ici) avant d’arriver aux serveurs (ou host). En réalité, le leaf layer est connecté aux TOR (Top of the Rack) qui eux-même se connectent à plusieurs serveurs. On peut le voir ci-dessous avec le rack NVL72 GB200 de chez Nvidia (leur dernier modèle) avec le TOR tout en haut et les multiples serveurs alignés en dessous:

On comprend donc vite ici que plus on descend bas dans la topologie, plus les nombres se multiplient. Pour reprendre l’analogie avec les racks Nvidia, chaque TOR est connecté à 36 serveurs qui contiennent chacun 2 puces Blackwell GB200. Chaque switch du leaf layer est connecté à 16 TOR, chaque Spine est connecté à 16 leaf, etc (j’ai pris un exemple avec une topologie simple mais on peut avoir encore plus de leaf/spine connecté)… Au total, si on prend 16 border leaf layer sur notre schéma ci-dessus, ça nous donne un total de 16x16x16x36 serveurs (soit un peu plus de 147 456 serveurs). En réalité, avec les redondances et les différents types de topologies, on est à bien moins que ça.

Pour aller plus loin, je vous recommande cet article de Meta: https://engineering.fb.com/2014/11/14/production-engineering/introducing-data-center-fabric-the-next-generation-facebook-data-center-network/

Pour revenir à la question du titre de cette sous-section. Un cluster est un ensemble d’appareils. Ici, quand on parle de cluster de GPUs, on parle de la couche tout en bas. Comme tous les GPUs sont inter-connectés, ils forment un seul “ordinateur” avec une puissance de calcul massive (d’où le nom cluster).

Les enjeux côté puissance

Revenons-en maintenant à l’article. L’article nous dit dès l’introduction que tous les modèles récents ont été entraînés avec une puissance de calcul stagnante. Le but des prochaines années (voire de prochains mois) va être d’entraîner des modèles d’IA générative à plusieurs billions de paramètres (plusieurs milliers de milliards).

Personne n’y est arrivé jusqu’à aujourd’hui et à raison: entraîner un tel modèle demanderait une puissance de calcul démesurée et prendrait des centaines d’années avec le matériel à notre disposition actuellement. De plus, même si l’on augmente la taille des data centers, on se retrouverait quand même avec plusieurs problèmes de taille que l’on évoquera tout au long de cette analyse.

Dans la suite de l’introduction, l’auteur nous explique que les GAFAM (notamment OpenAI/Microsoft, xAI et Meta, mais aussi d’autres) sont en train de faire la course à qui arrivera à construire un cluster de 100 000 GPUs… Aujourd’hui, seul Nvidia propose le matériel adéquat. Leur carnet de commande est plein et ils n’ont pas les capacités de production suffisante pour répondre à une telle demande. La demande est telle qu’on se croirait en pleine Guerre Froide pendant la course à la Lune…

Rien qu’en terme de puissance de calcul, ce cluster de 100 000 GPUs coûterait à lui seul plus de 4 milliards de dollars (pour rappel, un GPU H100 de chez Nvidia coûte 40 000$) ! Sauf qu’ici, on parle d’un seul cluster… Or, comme on a vu plus haut, il en faudra plusieurs si on veut maintenir une bonne disponibilité.

Les enjeux côté matériel réseau

Ici, tout commence à se compliquer (Attends quand même de voir la suite)… Un modèle comme ChatGPT4 à 1,8T de paramètres peut peser jusqu’à 10,8Tb, c’est bien plus que ce que possède un GPU H100 de chez Nvidia (80Gb, soit 135 fois moins que la taille du modèle). Il est donc évident qu’il faut mutualiser les ressources et c’est pour cela que l’on passe via des data centers surdimensionnés.

Le soucis, comme tu dois t’en douter, c’est qu’on doit introduire des notions de calcul en parallèle ainsi que des notions de transmissions de données (les deux vont ensemble en même temps). Tout ceci amène d’autre problématiques comme la latence ainsi que la vitesse de transfert de données. Cependant, pour que le parallélisme fonctionne correctement, il faut une grosse vitesse de transfert avec une faible latence et une excellente fiabilité. Et c’est là que ça commence à coincer…

Souvent, il est relativement aisé d’allier deux de ces points, mais les trois en même temps est extrêmement difficile. De plus, avec le nombre exorbitant de GPUs, la quantité d’optique nécessaire ferait exploser le coût en prenant une architecture traditionnelle. Cependant, même avec une architecture plus adaptée, il faut faire attention à certains points au risque d’engendrer les mêmes coûts pour une architecture plus complexe.

L’article nous précise aussi qu’avec l’arrivée massive des images et vidéos en donnée d’entraînement, les besoins en capacité réseau vont croître de manière exponentielle (et je peux le confirmer avec mon travail). La question ici n’est donc pas de se demander s’il y aura une augmentation de la demande en matériel réseau mais de quelle ampleur sera-t-elle ? Et qui va en profiter ? Je vous le donne dans le mille: Nvidia et Broadcom.

Cependant, tout ne s’arrête pas là pour ces dernier qui sont aussi en forte concurrence, malgré ce qu’on pourrait croire. Deux technologies s’affrontent pour raccorder tous ces serveurs ensemble: Spectrum-X d’Nvidia et Tomahawk 5 de Broadcom.

Le gros avantage de Spectrum-X est qu’il est développé par Nvidia et est donc le seul 100% compatible nativement avec le matériel et le logiciel Nvidia. De plus, en tant que client, si vous vous équipez de swicths Spectrum-X, vous serez priorisés sur la livraison des nouvelles puces. L’inconvénient, c’est que même si la solution permet une certaine réduction de coût, il faudra acheter des émetteurs-récepteurs LinkX de chez Nvidia qui coûtent plus cher. Un autre inconvénient vient sur la surconsommation de la solution d’Nvidia, mais on en reparlera plus tard.

Les switchs Tomahawk 5, eux sont beaucoup plus efficient en termes de consommation énergétique. La solution de Broadcom est aussi plus flexible et moins chère car elle permet de s’équiper avec des fournisseurs tiers comme Celestia pour les switchs ou bien Innolight ou Eoptolink pour les émetteurs-récepteurs. Le gros inconvénient cependant, c’est le manque de support pour les librairies spécialisées. Il faudra donc une armée d’ingénieurs pour adapter ces dites librairies, ce qui engendrera un surcoût supplémentaire.

Bien évidemment, je n’ai pas évoqué le sujet du besoin de pièces de rechange sur place, que ce soit pour les serveurs IA ou bien le matériel réseau dans son ensemble. Tout ceci accroît bien évidemment la demande.

Les enjeux énergétiques

Passons maintenant aux enjeux énergétiques. Je pense que tout est résumé dans cette citation:

One major power challenge is that currently no single datacenter building has the capacity for a new ~150MW deployment. When people refer to 100k GPU clusters, generally they mean on a single campus, not building. The search for power is so dire, X.AI is even converting an old factory in Memphis Tennessee into a datacenter due to the lack of other options.

100 000 GPUs dans un seul cluster est énorme. Habituellement, on parle de 100 000 GPUs sur un site entier, pas dans un seul bâtiment. Dans un data center, chaque bâtiment est équipé de sa source d’alimentation, d’une source d’alimentation de secours et d’onduleurs, chaque rack est lui aussi équipé d’onduleurs tout comme chaque serveur.

Pour remettre juste en perspective ce que représente 150 MW, le plus gros data center actuel, El Capitan, requiert “seulement” 30MW… Tout ceci amène la consommation annuelle à 1,59 TWh. Pour rappel, en 2019, la France entière a consommé 473 TWh d’électricité (soit un peu moins de 300 fois plus, ce qui veut dire qu’un seul data center de ce type représenterait à lui seul environ 0,3% de la consommation électrique française)…

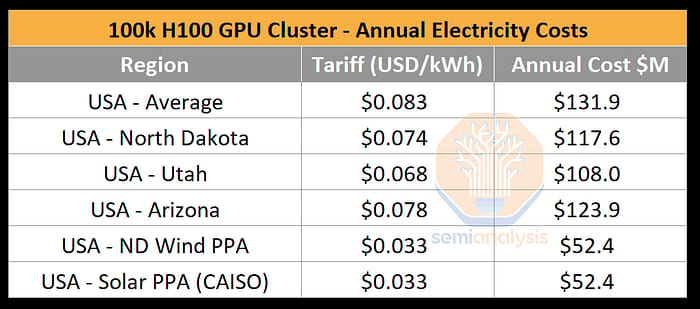

Par ailleurs, comme le montre le tableau ci-dessus, rien qu’en frais de fonctionnement, un data center de ce type coûterait pas moins de 132 millions de dollars par an en moyenne en électricité.

Cependant, ce calcul dépend de beaucoup de facteurs, comme le matériel utilisé (même si les puces IA sont trustés par Nvidia) ou les choix d’architecture et de matériel réseau utilisés. Par exemple, le choix de Spectrum-X comparé à Tomahawk se chiffrerait à 5MW de besoin énergétique supplémentaires. Par ailleurs, certaines topologies réseau sont bien plus consommatrices, ce qui peut accroître le besoin énergétique.

Qu’en est-il des GAFAM ?

Avec tout ceci, on en oublierait presque un acteur majeur de l’IA. En effet, tout ceci donne beaucoup d’indications sur les GAFAM. Premièrement, il s’agit réellement d’une course à l’armement. Je ne crois absolument pas au discours d’Alphabet qui vise à dire que les investissement colossaux sont temporaires et vont baisser.

Ces investissements dans les infrastructures IA vont continuer à croître pour le simple fait que c’est déjà rentable pour les fournisseurs de cloud et qu’il en va aussi de leur survie. Aujourd’hui, 1$ investi dans du matériel Nvidia se matérialise par au moins 5$ de généré sur la durée de vie du matériel (d’environ 4–5 ans en moyenne). Cela veut dire que le matériel est amorti dès la première année de mise en service.

Tout cet article montre aussi à quel point il est impossible de venir concurrencer un Microsoft, un Amazon ou un Alphabet sur l’infrastructure Cloud. Qui peut se permettre de mettre des dizaines de milliards dans des infrastructures liées à l’IA sans avoir de client ni de modèle à entraîner ? Qui peut se permettre tout les coûts de maintenance ?

Conclusion

La révolution de l’IA n’a rien à voir avec l’arrivée d’internet. On a ici des entreprises matures qui génèrent déjà des montagnes de cash. Comme dit Bill Gates: “AI is not Pets.com”. L’IA va réellement révolutionner nos vies et ça approche à grands pas.

Cette révolution solidifie encore plus l’oligopole du marché du Cloud. Aujourd’hui, presque personne ne peut dépenser de l’argent comme les fournisseurs de cloud (+ Meta) font. La question qu’on pourrait se poser ici n’est autre que “est-ce qu’on aurait pas déjà là nos grands gagnants de l’IA ?”.

Au niveau des semi-conducteurs, Nvidia possède une avance monstrueuse et un marché tellement énorme que même l’arrivée d’un concurrent sérieux n’entacherait pas sa croissance. Broadcom semble aussi proposer une alternative au matériel réseau Nvidia plus que viable, si on prend en compte le fait qu’une entreprise prête à investir plusieurs milliards de dollars peut se payer une équipe d’ingénieurs digne de ce nom.

Cependant, les enjeux et défis restent dingues. Rien qu’à voir la consommation énergétique, on se doute qu’il n’y aura pas que les fournisseurs de Cloud et les fabricants de semi-conducteurs qui tireront leur épingle du jeu. Les équipements énergétique vont devoir être sur-dimensionnés, ce qui fera le plaisir de Schneider-Electric et consorts. Par ailleurs, les défis technologiques sur le réseau vont devoir pousser Nvidia et Broadcom à continuer d’innover car l’étape des 100 000 GPUs n’est que le début.