>Toutes les illustration proviennent de Le Biais Financier (@Le_Biais_Fi sur X)

Bonjour à tous !

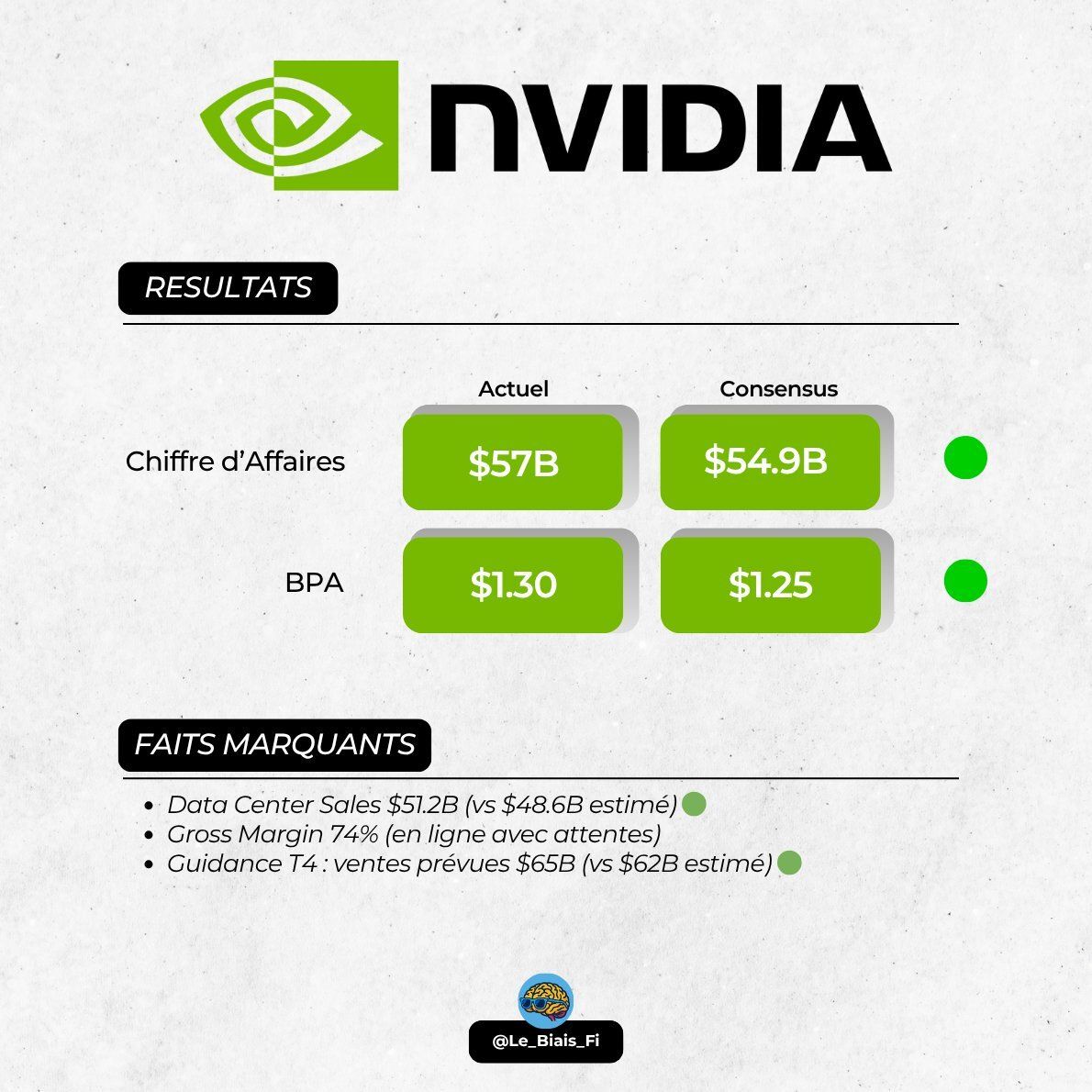

On se retrouve aujourd’hui pour les résultats (très attendus) d’Nvidia pour son 3è trimestre fiscal 2026 (Q3 2025 en année civile). Pour rappel, voici ce qu’attendait le consensus:

Chiffres d’affaires de 54,92B$

EPS de 1,25$

Guidance à 61,66B$ sur le CA et 1,43$ sur les EPS

Point fort du commentaire de la CFO 💬

Nvidia explose encore une fois les attentes avec un chiffres d’affaires publié de 57B$ (+3,79% vs consensus) et un EPS de 1,3$ (+4% vs consensus). La guidance est aussi battue largement avec le management qui donne une fourchette de ±2% autour de 65B$ (63,7B$ - 66,3B$), soit une borne inférieure supérieure de 3,31% face au consensus.

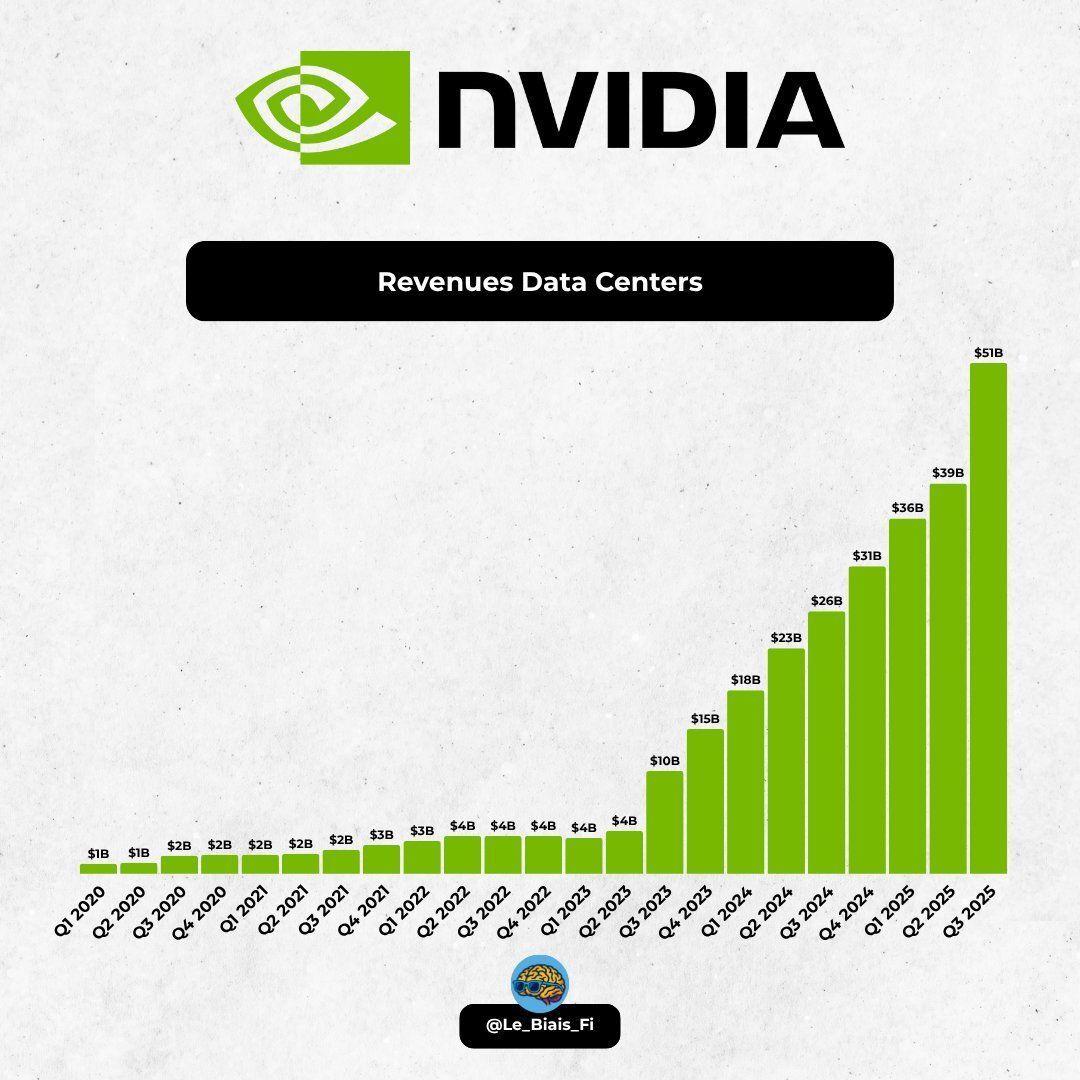

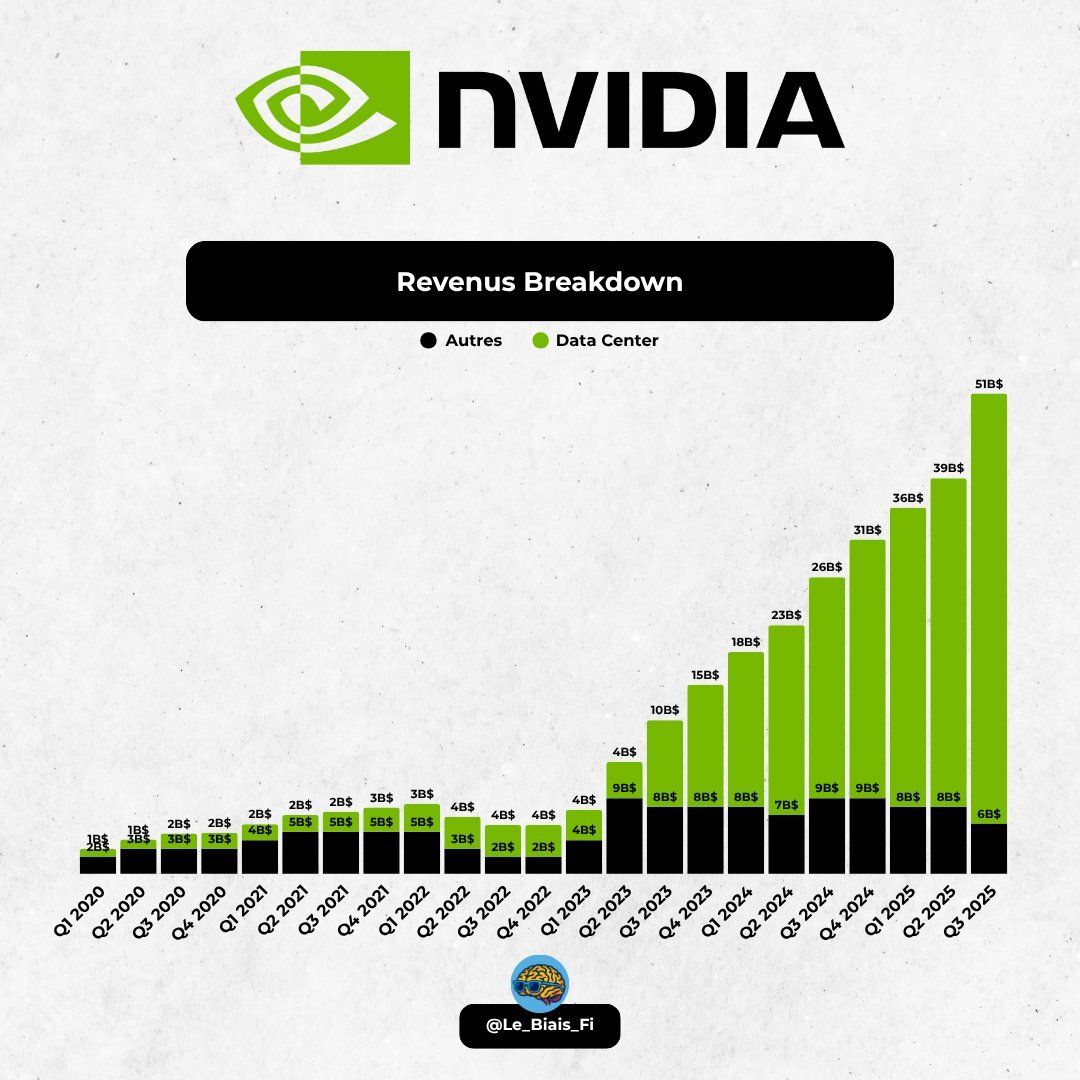

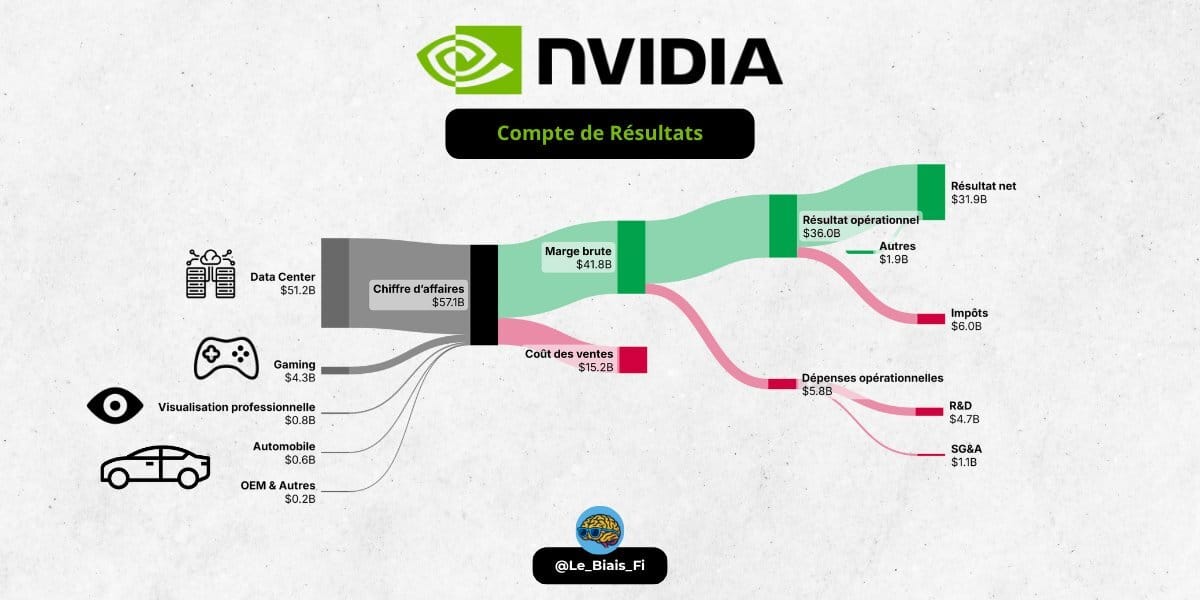

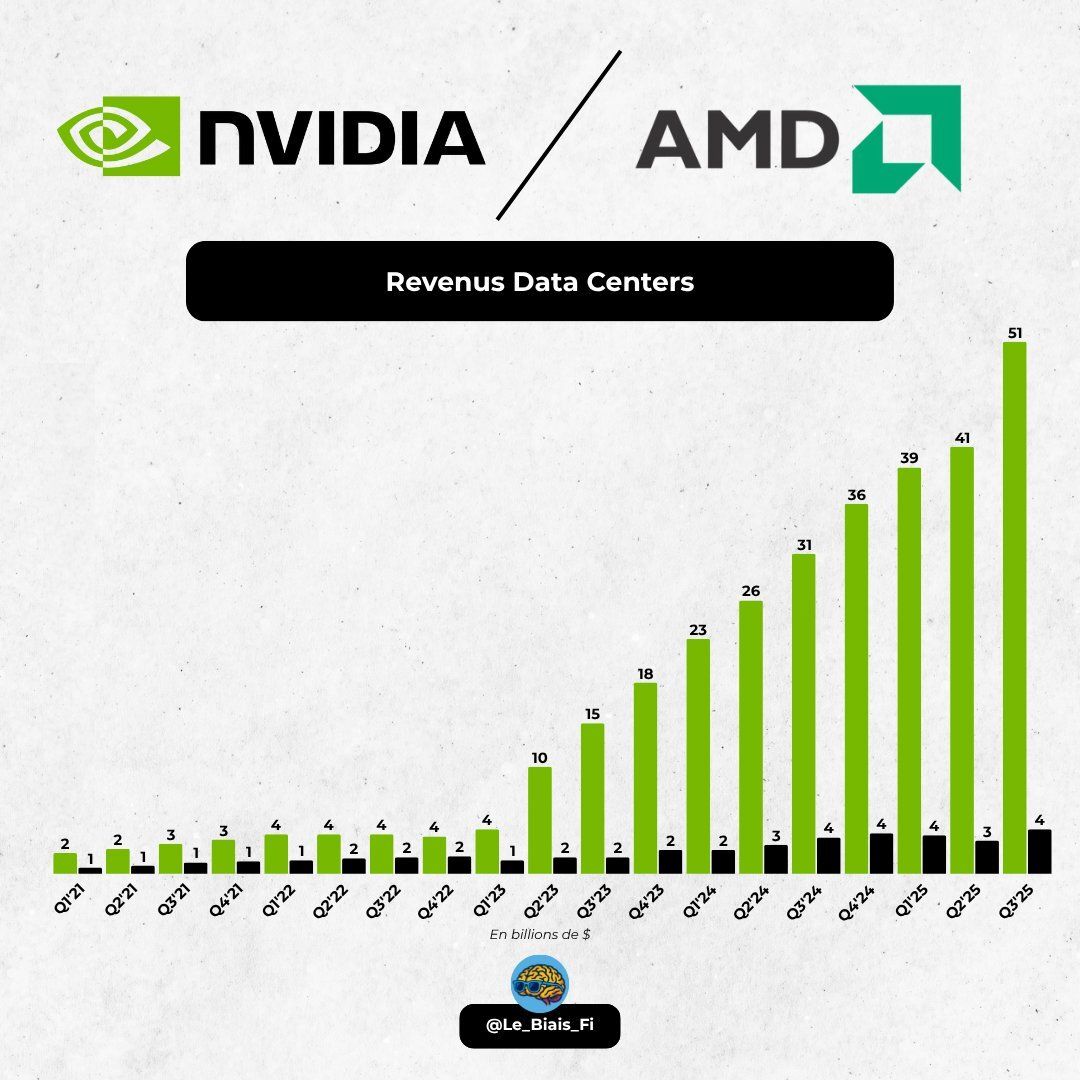

Du commentaire de la CFO, le chiffres d’affaires du segment datacenter s’est élevé à 51,2B$, en croissance de 66% YoY et de 25% QoQ. Comme vous vous en doutez, le segment datacenter comprend les puces mais aussi le matériel réseau. Pour plus de détails:

La partie compute (GPUs) a généré 43B$ ce trimestre, en croissance de 56% YoY et de 27% QoQ

La partie networking a généré 8,2B$, en croissance de 162% YoY et de 13% QoQ

Croissance du segment datacenter

On sent clairement une accélération du segment networking presque inexistant il y a ne serait-ce que 2 ans, le tout porté par les solutions NVLink, InfiniBand et Ethernet. Le management annonce aussi que Meta, Microsoft et Oracle vont déployer les solutions Ethernet, Spectrum-X, d’Nvidia.

Concernant les autres segments, je vais passer rapidement dessus: le segment Gaming est en croissance de 30% YoY (-1% QoQ), le segment Professional Vizualisation est en croissance de 56% YoY (+26% QoQ) et le segment Automotive affiche une croissance de 32% YoY (+1% QoQ).

Concernant les marges, Nvidia a effectué une transition des ventes de serveurs HGX (serveur nu qu’il faut équiper) à des solutions rack-scale avec l’arrivée de Blackwell (GB200/GB300), ce qui a impacté temporairement les marges. Aujourd’hui, le ramp-up est terminé et on voit une nouvelle appréciation des marges, avec une marge brute qui augmente de 100bps pour passer à 73,4% 📈.

Le management s’attend d’ailleurs à ce que la tendance continue au prochain trimestre avec une guidance à 75% sur la marge brute ±50bps.

⚠️ On peut cependant noter une augmentation des inventaires qui passent de 15B$ à 19,2B$. Le management attribue ça à une constitution de stock sur des composant en pénurie et qui affichent des délais fournisseurs longs.

Par contre, comme à son habitude, le cash 💰 s’accumule en passant à 60,6B$ en trésorerie, contre 38,5B$ un an plus tôt (56,8B$ au Q2). Nvidia a retourné 12,7B$ aux actionnaires, 12,5B$ en rachats d’actions et 243M$ en dividendes.

Avant de passer au call, voici quelques commentaires de Jensen Huang, CEO d’Nvidia 👇

“Blackwell est sold out, les ventes sont impressionnantes”

“La demande en capacité de calcul ne cesse d’accélérer et de se renforcer, tant pour l’entraînement que pour l’inférence — chacun connaissant une croissance exponentielle. Nous sommes entrés dans le cercle vertueux de l’IA. L’écosystème de l’IA se développe rapidement : plus de nouveaux créateurs de modèles fondamentaux, plus de startups d’IA, dans davantage de secteurs et dans plus de pays. L’IA se diffuse partout, fait tout, simultanément.”

Ce qu’il faut retenir du call ☎️

Comme d’habitude, le call post publication est une mine d’informations. Commençons par les points importants sur les ventes et le backlog. Comme vous devez le savoir, Nvidia a annoncé à sa GTC il y a quelques semaines qu’ils avaient 500B$ de backlog sur les 5 prochains trimestres (en comptant ce trimestre). Après précisions, Colette Kress, la CFO, a spécifié que le backlog qui restait à satisfaire sur les GPUs était de 350B$💰.

Lors du call, Colette Kress a spécifié que l’opportunité était encore plus grande et que les récents partenariats annoncés avec Anthropic ou encore l’Arabie Saoudite s’ajoutaient à ce backlog 👇

“Nous intégrons cela dans notre prévision de 500 milliards de dollars, et nous sommes sur la bonne trajectoire puisque nous avons déjà bouclé plusieurs trimestres. Il nous reste encore plusieurs trimestres devant nous jusqu’à la fin de l’année civile 2026. Le chiffre va augmenter, et nous répondrons, j’en suis sûr, à des besoins supplémentaires en compute qui seront livrables d’ici l’exercice fiscal 2026.

Nous avons expédié 50 milliards de dollars ce trimestre, mais nous n’en aurions pas fini si nous ne disions pas que nous allons probablement recevoir encore plus de commandes. Par exemple, rien qu’aujourd’hui, nos annonces avec l’Arabie saoudite, et cet accord en lui-même, représentent 400 000 à 600 000 GPU supplémentaires sur trois ans. Anthropic n’est pas nouveau non plus. Il y a clairement une opportunité pour nous d’aller au-delà des 500 milliards de dollars que nous avons annoncés.”

À cela, on peut aussi ajouter le fait que les revenus liés à la Chine sont toujours à 0, que ce soit ce trimestre ou dans la guidance. Le chiffre d’affaires provenant de la H20 est aussi minimal 👇

“Les ventes de H20 se sont élevées à environ 50 millions de dollars. D’importants bons de commande ne se sont jamais matérialisés au cours du trimestre en raison de problèmes géopolitiques et d’un marché chinois de plus en plus concurrentiel. Même si nous sommes déçus de la situation actuelle, qui nous empêche d’expédier des produits de calcul pour data centers plus compétitifs vers la Chine, nous restons déterminés à poursuivre le dialogue avec les gouvernements américain et chinois et continuerons de défendre la capacité de l’Amérique à être compétitive dans le monde entier.

Pour établir une position durable de leader dans le calcul IA, l’Amérique doit gagner le soutien de chaque développeur et être la plateforme de choix pour chaque entreprise commerciale, y compris celles basées en Chine.

[…]

Comme au trimestre précédent, nous n’intégrons aucun revenu lié au compute data center provenant de la Chine.”

Bien entendu, le management est déçu de ne pas pouvoir accéder au marché Chinois 🇨🇳. Ce n’est pas seulement le fait que le marché Chinois 🇨🇳 représente un marché potentiel d’au moins 50B$ annuel, c’est aussi le fait que la Chine peut créer un écosystème qui viendra concurrencer Nvidia, fragilisant l’avantage compétitif de l’entreprise.

Jensen Huang en a d’ailleurs parlé pendant le call, le principe derrière le financement des start-up et labs IA n’est pas de faire des deals circulaires mais de développer la plateforme d’Nvidia et de maintenir un avantage concurrentiel en verrouillant les clients dans l’écosystème 👇

“En ce qui concerne les investissements, c’est un travail vraiment, vraiment important que nous menons. Tous les investissements que nous avons réalisés jusqu’à présent — en fait, sur toute la période — sont liés à l’expansion de la portée de CUDA, à l’élargissement de l’écosystème. Si vous regardez les travaux, les investissements que nous avons faits avec OpenAI, c’est bien sûr une relation que nous entretenons depuis 2016. J’ai livré le tout premier superordinateur d’IA jamais conçu à OpenAI. Nous avons entretenu depuis lors une relation étroite et excellente avec OpenAI. Tout ce que fait OpenAI fonctionne aujourd’hui sur NVIDIA. Tous les clouds dans lesquels ils déploient, que ce soit pour l’entraînement ou l’inférence, tournent sur NVIDIA, et nous adorons travailler avec eux. Le partenariat que nous avons avec eux vise à ce que nous puissions collaborer encore plus profondément sur le plan technique afin de soutenir leur croissance accélérée.

[…]

Nous investissons dans OpenAI dans le cadre d’un partenariat technique approfondi de co-développement pour étendre notre écosystème et soutenir leur croissance. Bien sûr, plutôt que de céder une part de notre entreprise, nous obtenons une part de la leur. Nous avons investi dans l’une des entreprises les plus importantes, l’une de ces entreprises qui n’apparaissent qu’une fois par génération, et dans laquelle nous détenons une participation. Je m’attends pleinement à ce que cet investissement se traduise par des rendements extraordinaires.

[…]

Dans le cas d’Anthropic, c’est la première fois qu’Anthropic sera sur l’architecture de NVIDIA. Pour la première fois, Anthropic sera sur l’architecture de NVIDIA : c’est la deuxième IA la plus performante au monde en termes de nombre total d’utilisateurs. Dans l’entreprise, ils se débrouillent incroyablement bien. Claude Code fonctionne extrêmement bien. Claude fonctionne extrêmement bien dans les entreprises du monde entier. Nous avons maintenant l’opportunité d’avoir un partenariat profond avec eux pour amener Claude sur la plateforme NVIDIA.

[…]

Grâce aux investissements que nous réalisons dans l’écosystème, nous avons la capacité de collaborer — profondément et sur le plan technique — avec certaines des meilleures et des plus brillantes entreprises au monde. Nous étendons la portée de notre écosystème, et nous obtenons une part et un investissement dans ce qui sera une entreprise très performante, souvent une entreprise qui n’apparaît qu’une fois par génération. C’est notre thèse d’investissement.”

Pour revenir maintenant sur quelques inquiétudes de Wall Street, Jensen Huang en a principalement adressée 2: La bulle de l’IA et la dépréciation des cartes graphiques.

Comme le mentionne Jensen Huang, il y a encore sur le marché des GPUs A100 (génération Ampere) qui ont 6 ans et tournent encore, et ce, malgré les innovations massives apportées par Nvidia.

En effet, Ampere est aujourd’hui largement dépassée. Pourtant, si ces puces sont encore utilisées c’est principalement pour deux raisons: Nvidia a grandement amélioré CUDA, ce qui permet d’utiliser d’anciennes cartes graphiques, mais aussi parce que la demande est très forte, ce qui oblige les entreprises à utiliser la moindre capacité disponible.

“La plupart des accélérateurs dépourvus de CUDA et de l’architecture polyvalente et éprouvée de NVIDIA sont devenus obsolètes en quelques années, à mesure que les technologies de modèles évoluent. Grâce à CUDA, les GPU A100 que nous avons livrés il y a six ans tournent encore aujourd’hui à pleine utilisation, portés par une pile logicielle considérablement améliorée.

[…]

Les clouds sont sold out, et notre base installée de GPU — aussi bien les nouvelles que les anciennes générations, y compris Blackwell, Hopper et Ampere — est pleinement utilisée.”

Concernant la bulle 🫧 de l’IA, Jensen Huang essaie de rassurer le marché en rappelant qu’il se passe aujourd’hui 3 grandes transformations:

Premièrement on assiste à une transition des workloads traditionnels utilisant des CPUs à des workloads utilisant du calcul accéléré par GPU

Deuxièmement, l’IA, qui utilise massivement des workloads accélérés, est en train de transformer les applications et beaucoup d’industries

Dernièrement, l’utilisation des agents IA explose et avec eux, la demande en capacités de calcul

“On a beaucoup parlé d’une bulle de l’IA. De notre point de vue, nous voyons quelque chose de très différent. Pour rappel, NVIDIA n’est comparable à aucun autre accélérateur. Nous excellons à toutes les étapes de l’IA, du pré-entraînement et du post-entraînement à l’inférence. Grâce à nos deux décennies d’investissements dans les bibliothèques d’accélération CUDA X, nous sommes également exceptionnels dans les simulations scientifiques et d’ingénierie, les graphiques informatiques, le traitement de données structurées et le machine learning classique.

[…]

Le monde traverse simultanément trois transformations massives de plateformes, une première depuis les débuts de la loi de Moore. NVIDIA répond de manière unique à chacune de ces trois transitions.

La première transition est le passage du calcul généraliste sur CPU au calcul accéléré par GPU, alors que la loi de Moore ralentit. Le monde a massivement investi dans des logiciels non IA — du traitement de données aux simulations scientifiques et d’ingénierie — représentant des centaines de milliards de dollars de dépenses annuelles en compute dans le cloud. Beaucoup de ces applications, autrefois exclusivement exécutées sur CPU, basculent désormais rapidement vers les GPU CUDA. Le computing accéléré a atteint un point d’inflexion.

Deuxièmement, l’IA a elle aussi atteint un point d’inflexion : elle transforme les applications existantes tout en en rendant entièrement nouvelles possibles.

[…]

Désormais, une nouvelle vague émerge : des systèmes d’IA agentiques capables de raisonner, planifier et utiliser des outils. Des assistants de code comme Cursor et Claude Code, aux outils de radiologie comme iDoc, aux assistants juridiques comme Harvey, jusqu’aux chauffeurs autonomes comme Tesla FSD et Waymo, ces systèmes marquent la prochaine frontière du computing.

Les entreprises à la croissance la plus rapide aujourd’hui — OpenAI, Anthropic, xAI, Google, Cursor, Lovable, Replet, Cognition AI, Open Evidence, Abridge, Tesla — sont celles qui ouvrent la voie à l’IA agentique.”

Ce qui est impressionnant avec Nvidia, c’est que le management a déjà 3 coups d’avance sur la concurrence… Nvidia est déjà en train de préparer son prochain relais de croissance avec la robotique 🤖, même si le segment data centers croît toujours à une vitesse impressionnante 👇

“L’IA physique est déjà une activité de plusieurs milliards de dollars, adressant une opportunité de plusieurs milliers de milliards, et représente la prochaine phase de croissance pour NVIDIA. Les principaux fabricants américains et innovateurs en robotique exploitent l’architecture à trois ordinateurs de NVIDIA pour s’entraîner sur NVIDIA, tester sur l’ordinateur Omniverse et déployer l’IA dans le monde réel sur les ordinateurs robotiques Jetson.

[…]

Des entreprises comme Belden, Caterpillar, Foxconn, Lucid Motors, Toyota, TSMC et Wistron construisent des usines jumeaux numériques Omniverse pour accélérer la fabrication et l’automatisation pilotées par l’IA. Agility Robotics, Amazon Robotics, Figure et Skilled at AI bâtissent sur notre plateforme, tirant parti d’offres telles que les modèles fondamentaux NVIDIA Cosmos World pour le développement, Omniverse pour la simulation et la validation, et Jetson pour alimenter la prochaine génération de robots intelligents.”

Pour revenir sur le segment data center et les puces, le management indique que Rubin sera disponible comme prévu, en seconde moitié de 2026, avec des améliorations notables face à Blackwell 👇

“La plateforme Rubin est en bonne voie pour monter en puissance au second semestre 2026. Propulsée par sept puces, la plateforme Vera Rubin offrira une nouvelle fois une amélioration de performance d’un facteur X par rapport à Blackwell.

[…]

Nos partenaires de la chaîne d’approvisionnement, de l’écosystème data center et du cloud maîtrisent désormais le processus allant de l’assemblage à l’installation de l’architecture en rack de NVIDIA. Notre écosystème sera prêt pour une montée en charge rapide de Rubin.”

Le management adresse aussi une interrogation d’un analyste sur la supply chain et les capacités d’Nvidia à répondre à la demande. Ce à quoi Jensen Huang a rappelé qu’Nvidia travaille avec toutes les entreprises technologiques au monde et qu’ils ont une bonne visibilité sur la supply chain 👇

“Comme vous le savez, nous avons fait un très bon travail dans la planification de notre chaîne d’approvisionnement. La chaîne d’approvisionnement de NVIDIA inclut pratiquement toutes les entreprises technologiques du monde. TSMC, leurs capacités de packaging, nos fournisseurs et partenaires mémoire, ainsi que tous nos ODM systèmes ont très bien travaillé avec nous dans cette planification.

[…]

Nous avons d’excellents partenaires avec lesquels nous collaborons depuis 33 ans. Sur la partie chaîne d’approvisionnement, nous sommes très confiants. Désormais, en regardant plus loin dans notre chaîne d’approvisionnement, nous avons établi des partenariats avec un très grand nombre d’acteurs dans le foncier, l’énergie, l’immobilier “shell”, et bien sûr le financement.

[…]

N’oubliez pas que nous planifions, nous prévoyons, nous planifions encore et nous négocions avec notre chaîne d’approvisionnement bien à l’avance. Notre chaîne d’approvisionnement connaît nos besoins depuis très longtemps. Et elle connaît depuis très longtemps notre demande. Nous travaillons et négocions avec elle depuis déjà un bon moment.”

Pour continuer sur Rubin, Jensen Huang a reprécisé que le Perf/Watt ainsi que le Perf/TCO étaient les deux métriques les plus importantes et qu’Nvidia gagnait sur les deux tableaux. Dans un monde contraint en électricité, il faut extraire le maximum de performances de chaque GW, et c’est la mission d’Nvidia avec chaque nouvelle génération de puce 👇

“À chacune de ces générations, le gain de performance est d’un facteur X. Par conséquent, le TCO client s’améliore également d’un facteur X. Le plus important est qu’au final, vous n’avez toujours qu’un gigawatt de puissance, un gigawatt de data centers, un gigawatt de puissance. Ainsi, la performance par watt, l’efficacité de votre architecture, est incroyablement importante. L’efficacité de votre architecture ne peut pas être obtenue par la force brute. Il n’y a aucun moyen de la “forcer”. Ce gigawatt se traduit directement — votre performance par watt se traduit directement, absolument directement — en revenus, ce qui explique pourquoi le choix de la bonne architecture est aujourd’hui si crucial. Le monde n’a pas de surplus à gaspiller.

[…]

À chaque génération, notre contribution économique sera plus grande. La valeur que nous apportons sera plus grande. Le plus important est que notre efficacité énergétique par watt sera extraordinaire à chaque génération.

[…]

C’est la meilleure performance par watt, et donc, pour n’importe quelle quantité d’énergie fournie, notre architecture générera le plus de revenus. Je pense que le rythme croissant de notre succès est évident : nous avons plus de succès à ce stade de l’année que nous n’en avions à la même période l’année dernière. Le nombre de clients qui viennent vers nous et le nombre de plateformes qui nous choisissent après avoir exploré d’autres options augmente, et non diminue.”

Pour finir, Jensen Huang a rappelé que concevoir un accélérateur IA aujourd’hui est bien plus complexe. Il ne s’agit plus seulement de concevoir une puce mais aussi de concevoir tout un écosystème pour extraire le maximum de performances de son matériel 👇

“Tout d’abord, vous ne vous mesurez pas simplement à d’autres équipes. Excusez-moi. Encore une fois, en tant qu’entreprise, vous êtes en compétition avec des équipes. Il n’existe tout simplement pas beaucoup d’équipes dans le monde capables de construire ces systèmes incroyablement complexes. À l’époque de Hopper et d’Ampere, nous construisions un seul GPU. C’est la définition d’un système d’IA accéléré. Aujourd’hui, nous devons construire des racks entiers, trois types de switchs différents : un switch scale-up, un switch scale-out et un switch scale-across. Il faut bien plus qu’une seule puce pour construire un nœud de calcul désormais.

[…]

Nous sommes maintenant la seule architecture au monde capable d’exécuter tous les modèles d’IA, tous les modèles d’IA de pointe. Nous exécutons les modèles d’IA open-source de manière exceptionnelle. Nous exécutons des modèles scientifiques, biologiques, de robotique. Nous exécutons chaque modèle. Nous sommes la seule architecture au monde à pouvoir le revendiquer.”

Mon analyse à chaud face à tout ça 🔥

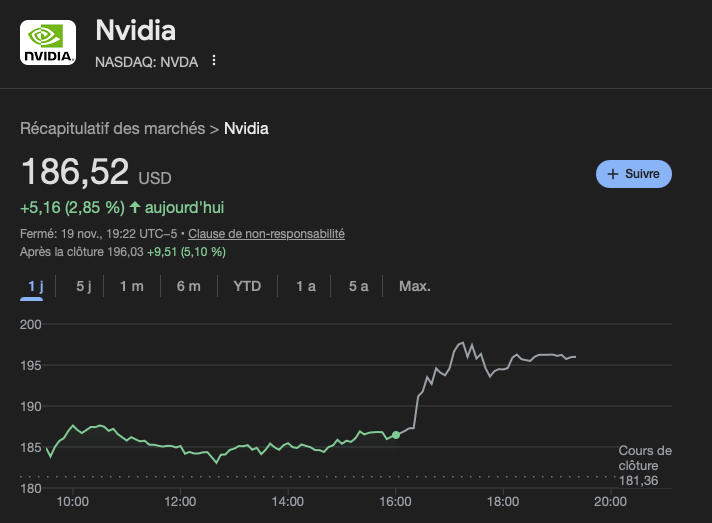

Honnêtement, je trouve que cette publication est excellente. D’ailleurs, le marché aussi apprécie, avec une hausse en after hours de +5,1% 🚀!

Non content d’avoir une croissance 📈 insolente, Nvidia se permet d’accélérer et de trouver de nouveaux relais de croissance comme la robotique. Son segment Datacenter se porte à merveilles et Nvidia continue de grignoter des parts de marchés face à un AMD qui peine à imposer ses GPUs 👇

Et ce, sans parler de la partie networking 🛜 en pleine explosion ! Nvidia se permet le luxe de chiper des parts de marché à Broadcom en attirant des clients très lourds comme Microsoft ou Oracle (Google et Meta avaient déjà annoncé au précédent trimestre qu’ils allaient utiliser Spectrum-X).

De plus, Rubin se porte bien, le ramp-up 🚀 devrait être rapide et avec beaucoup moins de problèmes qu’avec Blackwell. La puce promet d’être exceptionnelle et de creuser le gap avec ses concurrents.

Nvidia est clairement en passe de délivrer une année 2026 à plus de 350B$ de chiffres d’affaires 🤯, le tout en conservant une marge brute dans les 75% et une marge nette aux alentours de 55%. Tout ça devrait mener à un bénéfice net de 190-200B$ pour 2026, soit une valorisation de 24 à 26 fois les bénéfices CY2026.

Clairement, la visibilité est dingue pour ce type de business (5 mois contre 1 mois en temps normal), et la valorisation est loin d’être aberrante…

Concernant les points noirs, la dépréciation de GPUs est pour moi un non-sujet. Par contre, même si je suis en accord avec la stratégie de Jensen Huang, il est vrai que les financement circulaires ne sont pas non plus une pratique que j’apprécie. De plus, un point passé plus inaperçu qui me dérange est l’augmentation des inventaires. Je comprends que ça donne plus de visibilité au management au niveau du stock de composants mais ça reste un point à surveiller.

Personnellement, je ne crois pas en une bulle 🫧 de l’IA, et je constate aussi, depuis que je suis étudiant, une transformation de l’industrie, qui va profiter notamment à Nvidia. Maintenant, il faudra garder un oeil sur la partie financement, notamment au niveau de certains hyperscaler dont la santé financière se dégrade, mais aussi au niveau des labs IA. Le financement arrivera à ses limites à un moment donné et il faut que les acteurs atteignent la rentabilité avant d’atteindre ce point.

Concernant mes estimations de fair value, comme chaque trimestre, je les relève. Bien entendu, il ne s’agit ici aucunement d’un conseil en investissement. En prenant tout en considération, j’estime qu’Nvidia a une fair value située entre 195 et 245$.

Voilà, c’est tout pour ce suivi de résultat, j’espère qu’il vous aura plu !