Bonjour à tous et bienvenue dans le tout premier épisode de Deep Silicon !

Avant de commencer, je tiens à tous vous remercier pour l’accueil chaleureux que vous avez manifesté à l’égard de cette newsletter. Vous êtes actuellement 922 (vous êtes des grands malades 🤯!), et jamais je n’aurais pensé atteindre ce chiffre pour la première édition !

Si on t’a transféré cet e-mail, sache que tu peux t’inscrire gratuitement à cette newsletter en cliquant sur le bouton ci-dessous 👇

⚠ Cette newsletter est dense et j’ai dû condenser certains passages pour des raisons techniques. Si tu as des questions ou si certains points ne sont pas clairs, n’hésite pas à répondre directement à cet email.

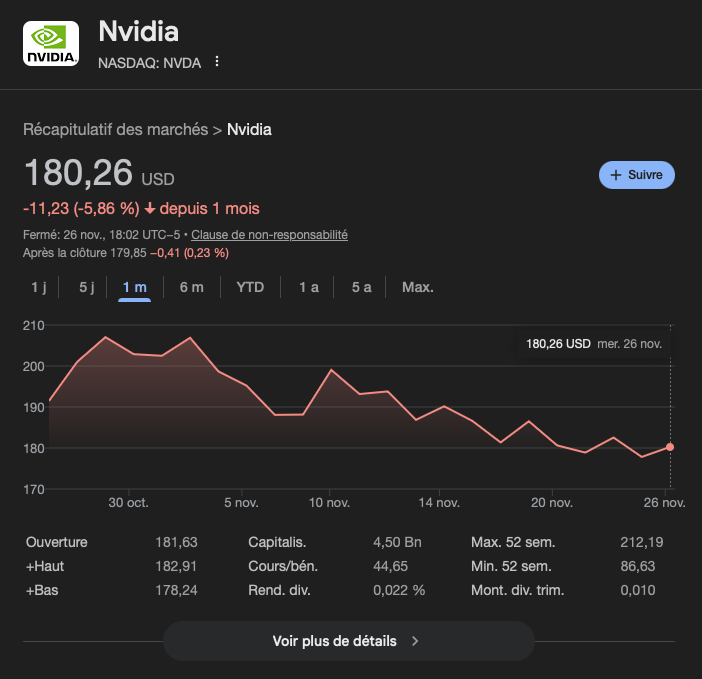

Tu l’auras remarqué, le mois de Novembre fut mouvementé pour Nvidia et la tech en général. En effet, le titre recule de 5.8% sur un mois et de 12.9% par rapport à ses plus hauts du mois. Et ce malgré d’excellents résultats publiés le 19 Novembre…

Pour des raisons de transparence, je précise que je suis actionnaire d’Nvidia et de Google à hauteur de 21% et 12% de mon portefeuille respectivement.

Pour cause, Michael Burry, le célèbre investisseur derrière le “Big Short” de la crise des subprimes, a initié une position short sur le titre et accuse les hyperscalers de fraude comptable tout en comparant Nvidia à Cisco dans les années 2000 🫧.

Pour rappel, le short c’est une manière de parier contre une action

De plus, les investisseurs sont de plus en plus inquiets face aux dépenses colossales des Big Tech, et le narratif autour de l’Intelligence Artificielle 🤖 bat un peu de l’aile. Certains investisseurs ont d’ailleurs également noté une hausse des inventaires et accusent directement Nvidia de fraude comptable. D’après eux, l’entreprise gonflerait ses bénéfices en comptant des ventes non-encaissées, et en mentant sur la demande réelle.

Et pour couronner le tout, le journal technologique “The Information” a révélé ce lundi 24 Novembre que Meta, gros client d’Nvidia, envisageait d’acheter des TPUs à Google pour ses propres datacenters, en plus de louer directement des capacités chez GCP.

Cependant, on va voir ensemble qu’au delà du narratif, il s’agit surtout de bruit, à l’instar de ce qu’il s’est passé plus tôt dans l’année avec DeepSeek (d’où le titre de cette newsletter).

📊 Des pratiques comptables douteuses ?

Si je ne m’attaquerai pas aux déclarations de Michael Burry ici car ça fera le sujet d’une autre newsletter, il reste tout de même en suspens la question autour de la comptabilité d’Nvidia. Décortiquons ça pas à pas…

⚠ Attention, ça va être un peu technique car on va parler comptabilité, mais je vais essayer d’expliquer au mieux pour les plus novices sur le sujet

Des bénéfices gonflés ?

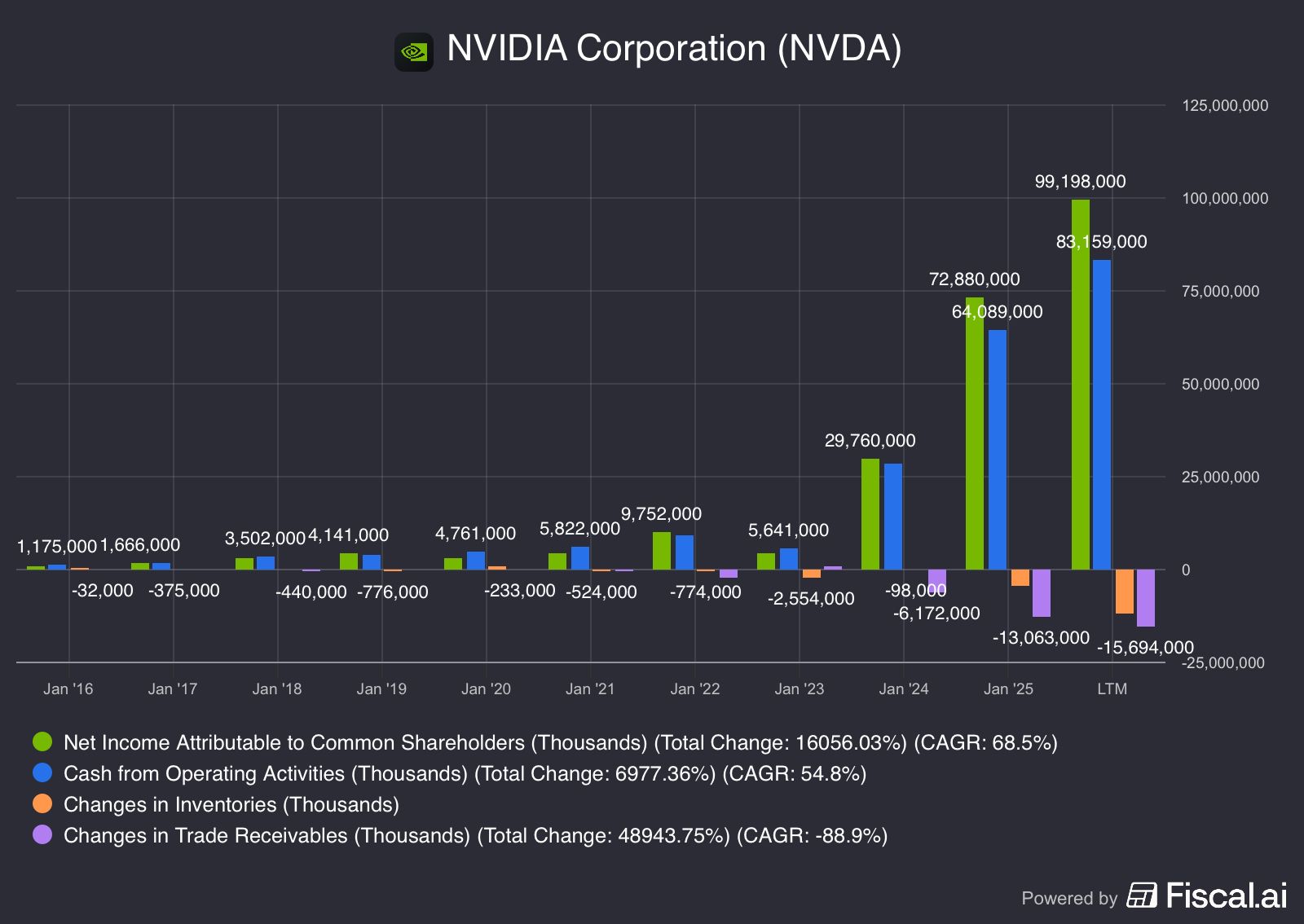

Une des premières remarques qui revient, c’est la différence assez nette entre le bénéfice net déclaré par Nvidia et les cash flows opérationnels (CFO). Comme Nvidia a une structure de BFR (besoins en fonds de roulement) normalement assez light, le bénéfice net devrait être sensiblement le même que les CFO.

Ce décalage s’explique en réalité assez simplement: les inventaires et comptes débiteurs d’Nvidia ont fortement augmenté depuis Janvier 2024. Cependant, c’est aussi sur ce point précis que les détracteurs attaquent l’entreprise.

source: fiscal.ai

Concernant les comptes débiteurs en hausse

Avant de commencer l’argumentaire, je pense qu’il est de bon ton d’expliquer ce qu’est un compte débiteur. Pour faire simple et rapide, c’est l’argent que doivent les clients à Nvidia. Quand un client passe commande, Nvidia enregistre une créance envers ce client, qui s’engage à payer Nvidia à la livraison. C’est une simple écriture comptable.

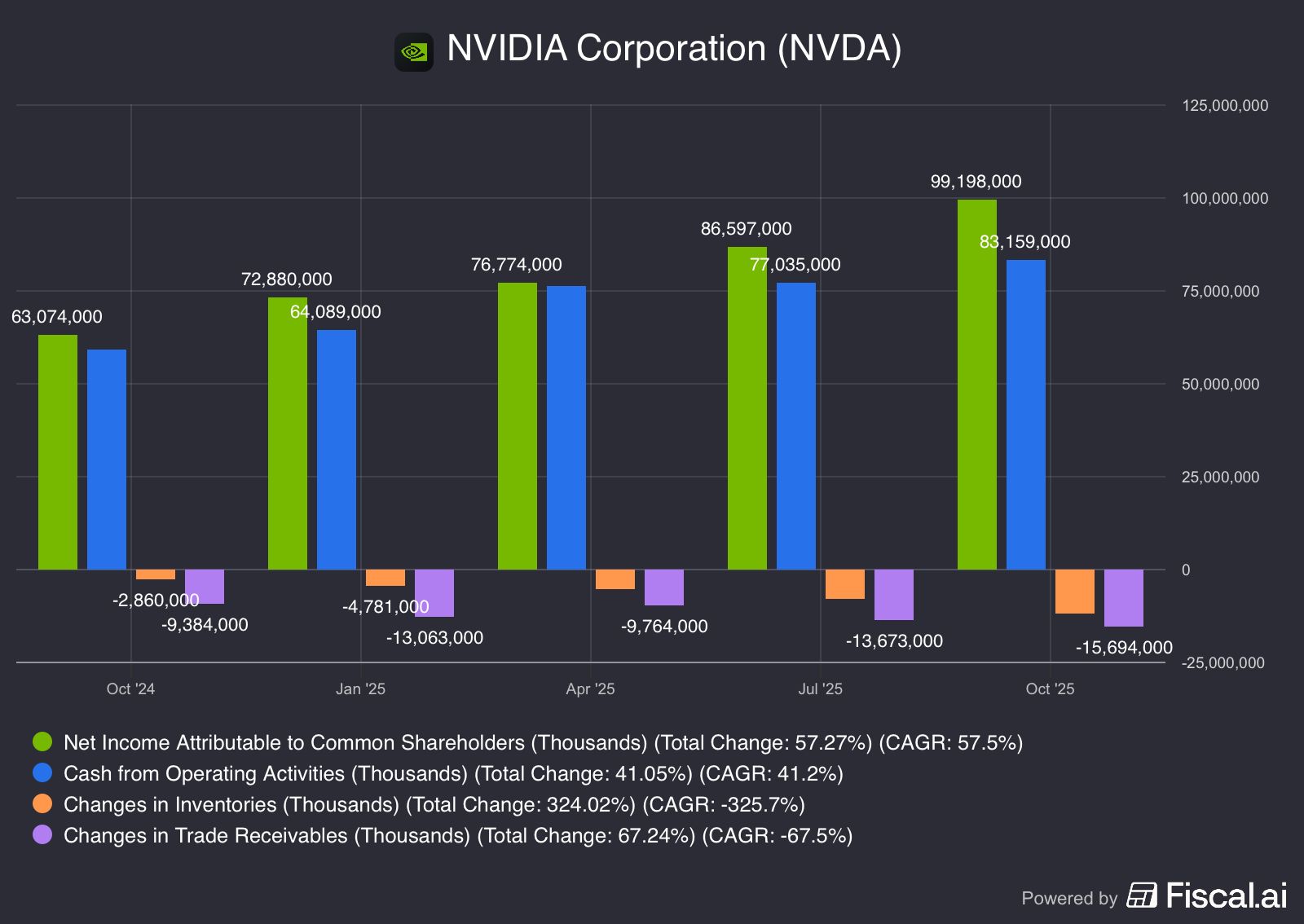

Si on regarde sur une année glissante, le bénéfice net est en hausse de 57.3%, quand les comptes débiteurs sont en hausse de 67.2% 📈… On ne peut pas dire qu’il y ait une explosion ici.

source: fiscal.ai

Ici, c’est tout simplement dû à la montée en complexité des racks serveurs d’Nvidia et à l’augmentation des délais ⏱ d’approvisionnement de certains composants critiques, ce qui retarde la livraison. Comme Nvidia a énormément de revenus reconnus à la livraison, tout le décalage logistique gonfle les comptes débiteurs naturellement sur le court terme.

Nvidia reconnaît simplement dans ses comptes les commandes qui seront livrées et payées sur ce trimestre dans les comptes débiteurs. Il s’agit d’une pratique comptable standard — certains peuvent la trouver discutable, mais elle est parfaitement conforme.

Concernant les inventaires

J’ai personnellement aussi noté une hausse des inventaires continue au cours des derniers trimestres (je t’invite à lire mon dernier compte-rendu des résultats), et, bien que je n’aie pas spécialement apprécié cela au premier abord, je dois dire aujourd’hui que je ne suis pas plus inquiet que cela.

Pour comprendre pourquoi ils sont en hausse il faut surveiller 2 points: le changement de business model d’Nvidia et la supply-chain. Et pour ça, je vais commencer par les commentaires du management lors des derniers résultats 👇

“Dans notre bilan, les stocks ont augmenté de 32 % d’un trimestre à l’autre, tandis que les engagements d’approvisionnement ont progressé de 63 % sur la même période. Nous nous préparons à une croissance importante et nous sommes confiants dans notre capacité à saisir les opportunités qui s’offrent à nous.”

Ici, l’entreprise accumule du stock de composants critiques pour la fabrication de ces serveurs. Ça inclut les wafer gravés qui sortent de chez TSMC et attendent les étapes finales de la fabrication, la HBM qu’ils achètent chez SKHynix, ou simplement d’autres composants comme des alimentations ou du matériel de refroidissement.

Wafer gravé

Là où je pense que les internautes se trompent, c’est qu’ils partent du principe que les inventaires sont forcément composés de puces prêtes à être vendues. C’est possible qu’il y en ait dedans, et d’ailleurs Nvidia a mis en inventaire (après write-down, ou charge exceptionnelle de dépréciation des stocks) les H20 invendues après l’interdiction à la vente de ces dernières en Chine.

Cependant, au vu des pénuries sur toute la supply-chain (il suffit d’écouter le discours des CEO), c’est fortement probable que cette hausse des inventaires soit bel et bien due à une constitution de stock sur composants critiques (dont possiblement de la HBM4 qui va bientôt équiper Rubin)…

Jensen Huang a d’ailleurs complété avec quelques commentaires sur la supply-chain 👇

“Je pense que la seule chose que j’ajouterais est qu’il faut se rappeler que nous planifions, nous prévoyons, nous planifions encore, et nous négocions avec notre chaîne d’approvisionnement bien à l’avance. Notre chaîne d’approvisionnement connaît nos besoins depuis assez longtemps.”

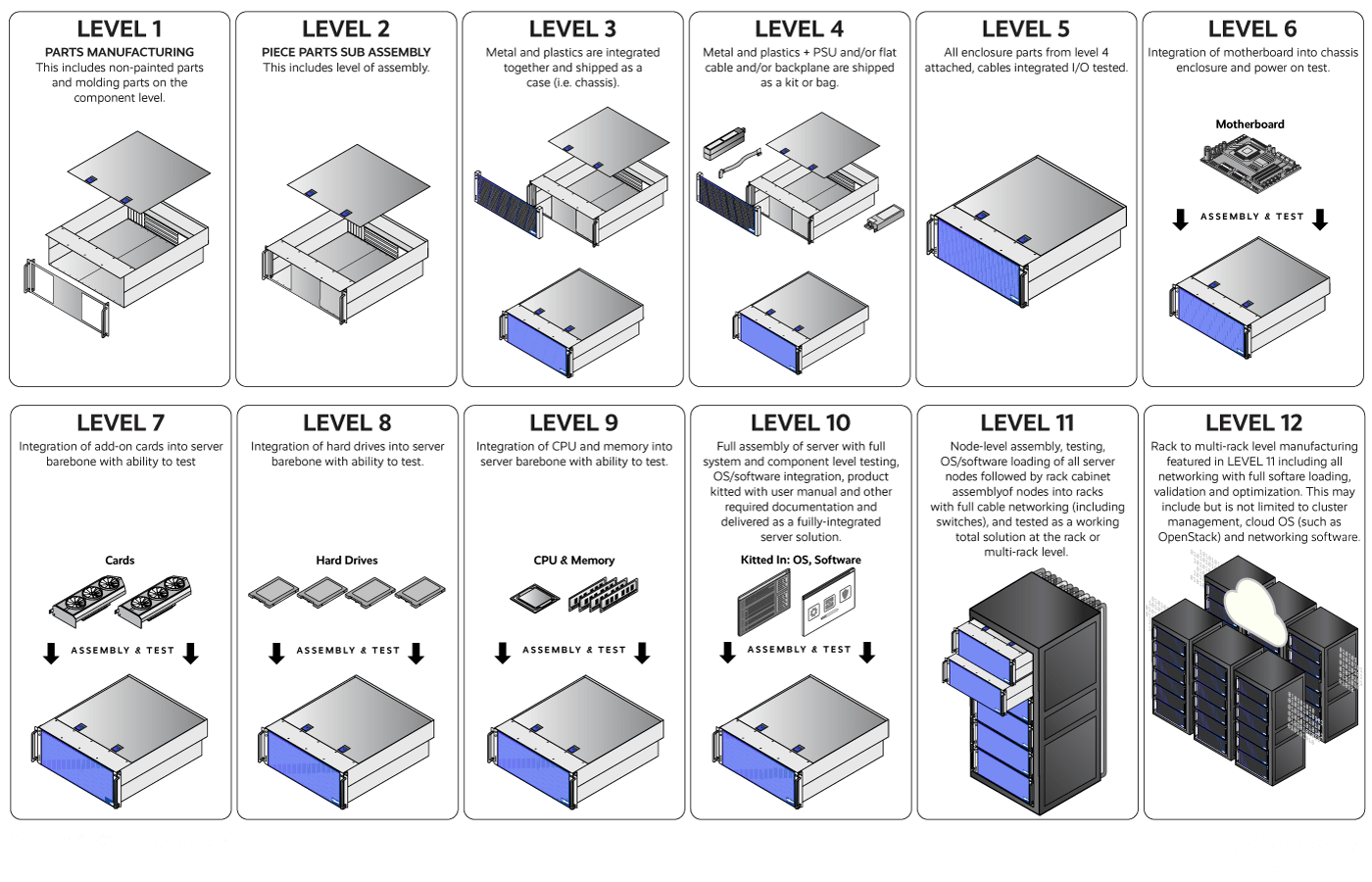

Il ne faut d’ailleurs pas oublier la transformation du business model d’Nvidia, qui propose aujourd’hui des systèmes bien plus complexes (on est passé de serveurs HGX/DGX aux racks complets NVL72). Pour Rubin, Nvidia monte encore d’un cran en passant de serveurs L6 à L10 (Nvidia fournit plus de composants dans ses serveurs).

Types de serveurs (L1 à L12)

Pour en savoir plus, je t’invite à lire la newsletter que j’ai écrite avec Abdallah de Bourseko ici 👉 https://www.bourseko.fr/p/comprendre-moat-nvidia

Tout ceci fait naturellement monter la charge sur les inventaires et il n’y a rien d’anormal à cela, même si c’est un point à surveiller car ça peut se retourner contre l’entreprise en cas de faiblesse de la demande.

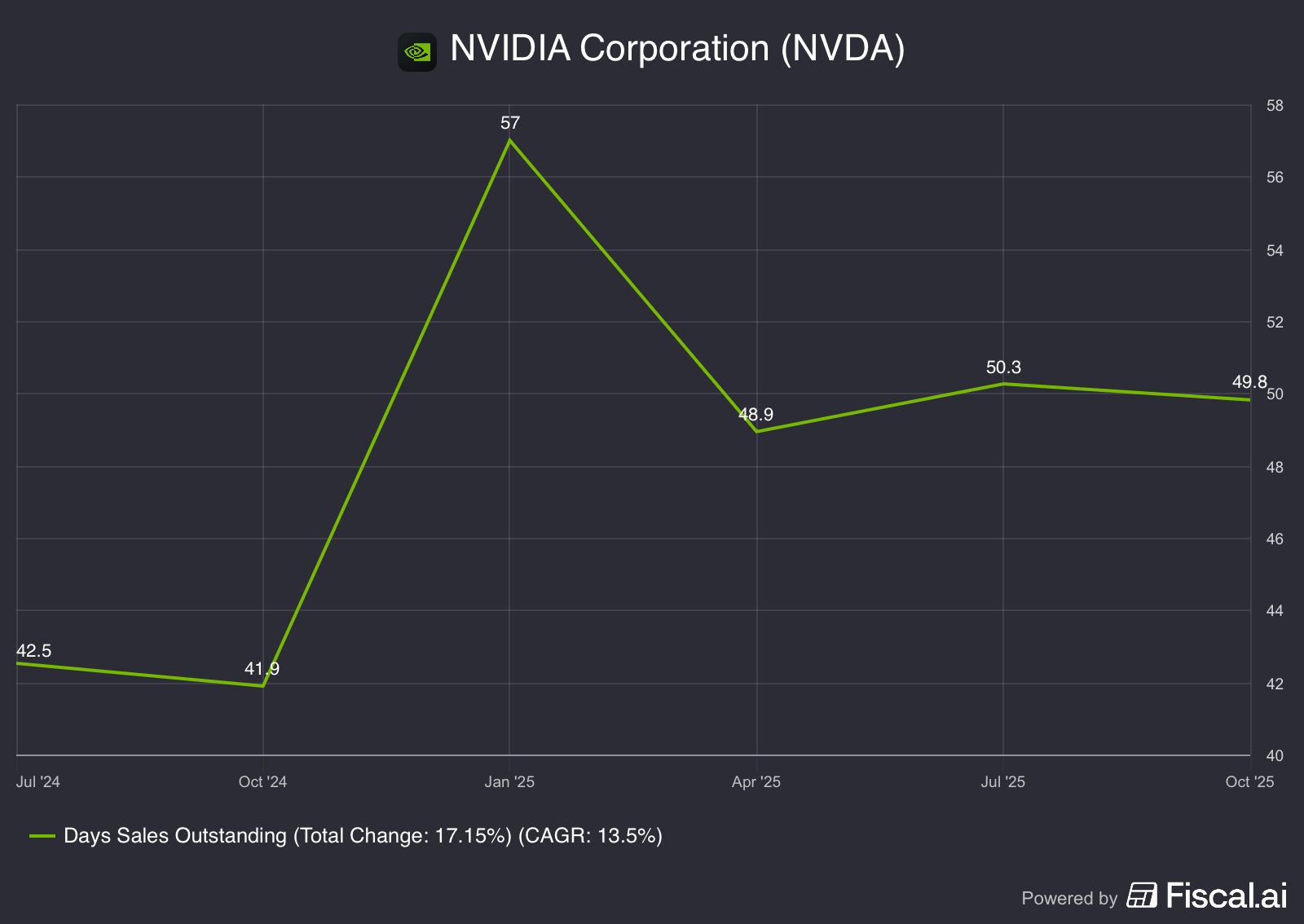

Un DSO en hausse ?

Un dernier point qui a été soulevé sur la comptabilité, c’est la hausse du Days Sales Outstanding (DSO): en gros, le délai entre la facturation et le paiement effectif. Là où c’est inquiétant, c’est que ça pourrait indiquer:

Soit une fragilité des clients qui mettent plus de temps à régler les factures

Soit une fraude comptable d’Nvidia qui enregistre des ventes qui ne sont pas encore réalisées

Premièrement, c’est faux. Le DSO est relativement stable, en témoigne les données en année glissante 👇

DSO (LTM) - source: fiscal.ai

Oui, les DSO sont en hausse séquentiellement (d’un trimestre sur l’autre), mais sur un an, on est globalement à un niveau stable. 50 jours pour recevoir un paiement peut paraître important, mais en réalité c’est intrinsèquement lié au business model d’Nvidia qui présente une forte concentration de clients (les 4 plus gros clients d’Nvidia représentent 65% des comptes débiteurs — source: 10-Q).

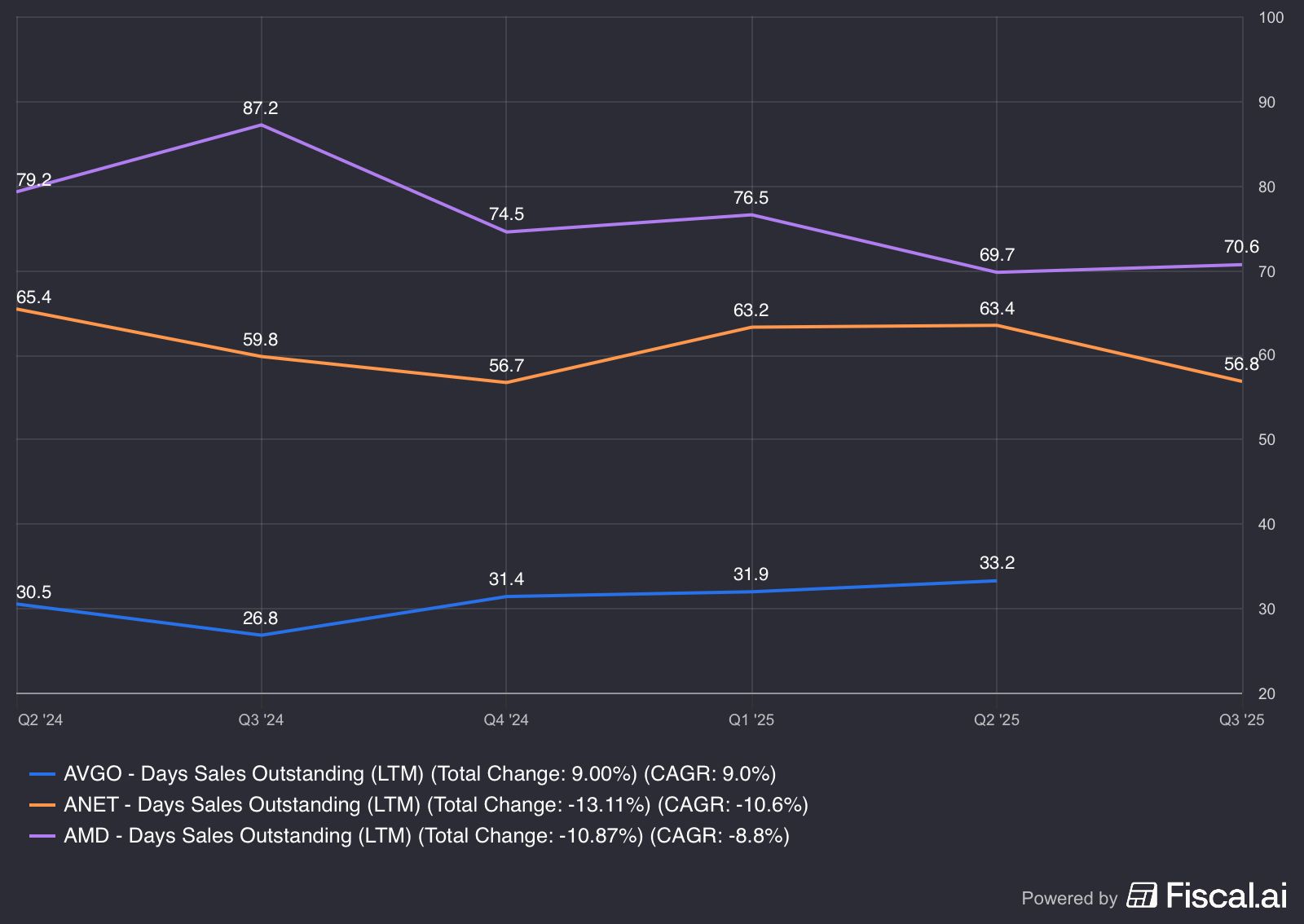

On peut d’ailleurs le remarquer chez Broadcom, Arista Networks et AMD, avec un DSO respectif de 33.2, 56.8 et 70.6 sur les 12 derniers mois👇

source: fiscal.ai

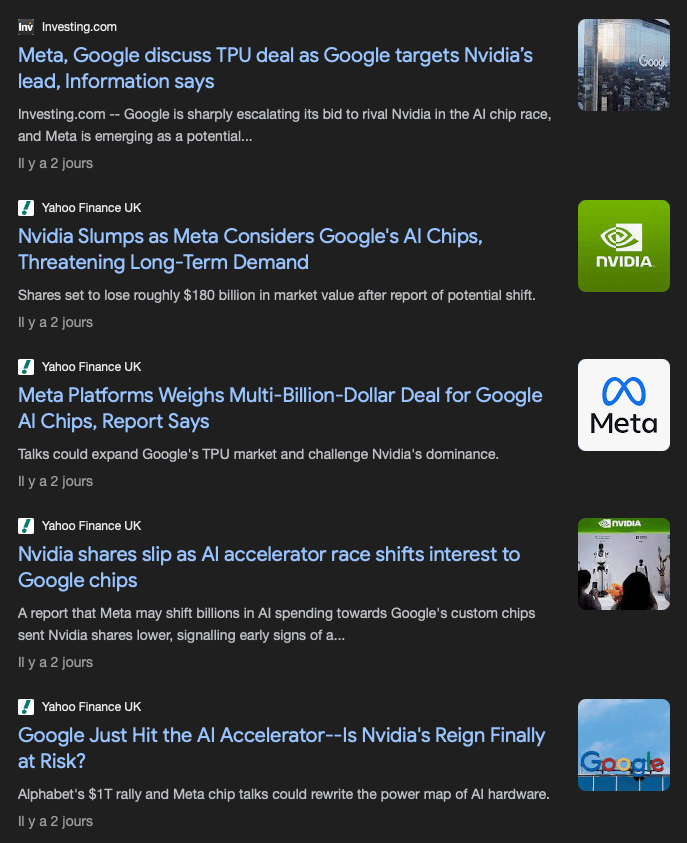

🍽️ Des TPUs mangeurs de GPUs

Penchons nous désormais sur la news de ce Lundi: Meta envisagerait d’utiliser les TPUs dans ses datacenters.

Comme tu as sans doute pu le voir, les médias se sont rapidement saisis de la nouvelle et en ont profité pour écrire des articles bien plus alarmistes 🚨 que ne l’est la réalité.

Bien qu’il serait très intéressant de creuser les différences techniques entre les GPUs et TPUs, ce sera le sujet d’une prochaine newsletter. Ici, je ne resterai qu’en surface.

Un narratif qui a bien évolué

Ce qui est fascinant avec cette nouvelle, c’est la puissance du narratif. Si tu te souviens bien, il y a moins d’un an, Google était vu comme un des grands perdants de l’IA.

Aujourd’hui, tout le monde semble redécouvrir l’existence des TPUs alors qu’ils existent depuis dix ans. Les TPUs apparaissent soudain comme une alternative crédible aux GPUs Nvidia, alors que peu de choses ont changé sur les derniers mois. J’écrivais d’ailleurs ceci en Février de cette année👇

“Là où c’est intéressant, c’est que la meilleure alternative à la plateforme d’Nvidia (CUDA + GPU) réside dans les TPU de Google. En fait, Google planche sur ses TPUs depuis 2013 et a depuis sorti plusieurs librairies optimisées pour les TPU. Google est donc extrêmement bien placé sur le software ce qui lui donne un avantage considérable.”

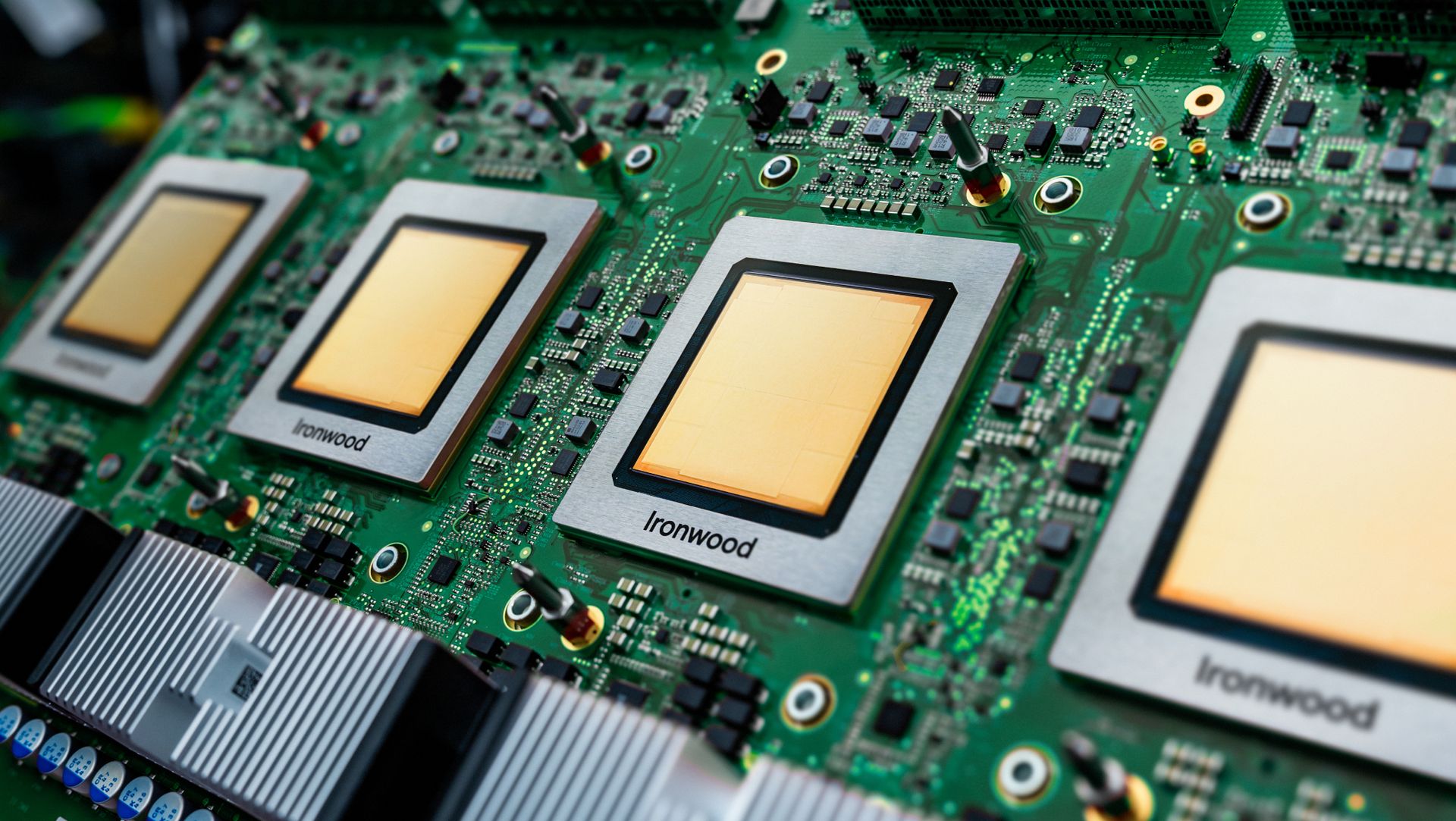

Pour rappel, TPU veut dire Tensor Processing Unit. Ces puces font partie des ASICs et sont des puces spécialisées pour l’Intelligence Artificielle.

Je pense qu’il faut également rappeler que Google a dépensé deux fois plus dans des GPUs Nvidia en 2025 que dans ses propres TPUs, comme le souligne une note de Morgan Stanley 👇

“Pour ce qui est de la performance de Google sur la partie LLM, nous pensons que Nvidia a gagné des parts chez Google cette année. Google dépense environ 20B$ pour du Nvidia, contre un budget dans les 10B$ pour les TPU. Cette tendance devrait en partie s’inverser l’année prochaine, mais nous ne prévoyons pas une croissance en mode “winner-takes-all”.”

D’ailleurs, GCP (Google Cloud Platform) est un des plus gros fournisseurs de capacité de calcul IA, avec une flotte de GPUs Nvidia parmi les plus importantes au monde.

Malgré tout, plusieurs articles publiés cette année font part d’un manque de disponibilité des GPUs, ce qui a obligé Google à acheter 💸 de la capacité supplémentaire chez CoreWeave 👇

Une soif pour la puissance de calcul et une supply-chain qui ne ment pas

Là où je pense que le marché se trompe le plus, c’est qu’il raisonne en jeu à somme nulle. En réalité, la demande en capacité de calcul est telle que peu importe si Nvidia perd des parts de marché, l’impact devrait être négligeable.

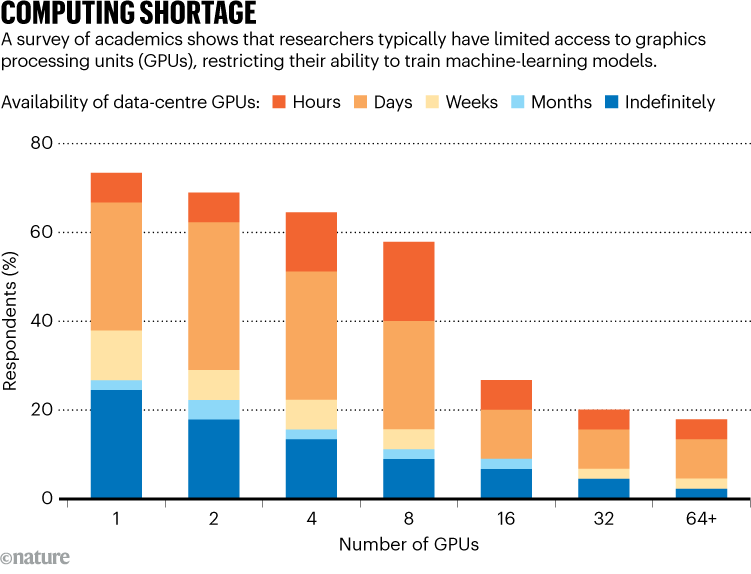

Le problème a d’ailleurs été souligné dans un article de Nature, daté du 20 Novembre 2024, qui explique que les chercheurs 🔍 ont de plus en plus de difficulté pour accéder aux capacités de calcul.

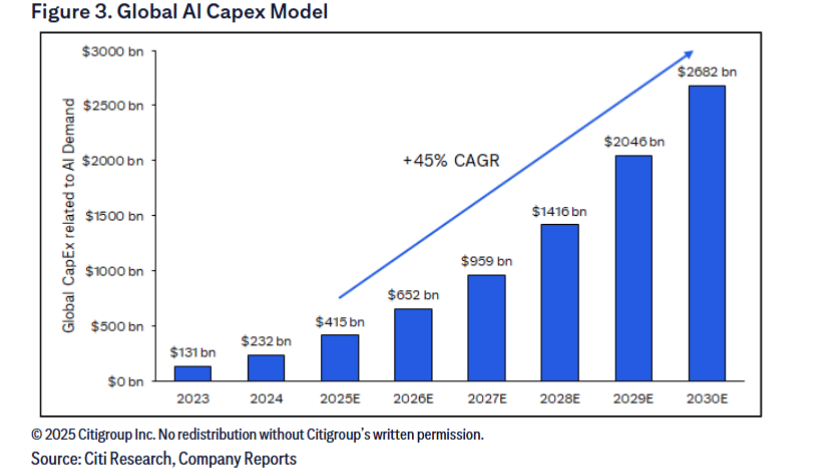

Si l’on regarde les prévisions des CapEx IA, on peut remarquer une forte accélération et un marché en plein boom avec des prévisions allant jusqu’à 2 682B$ 💰 annuels en 2030.

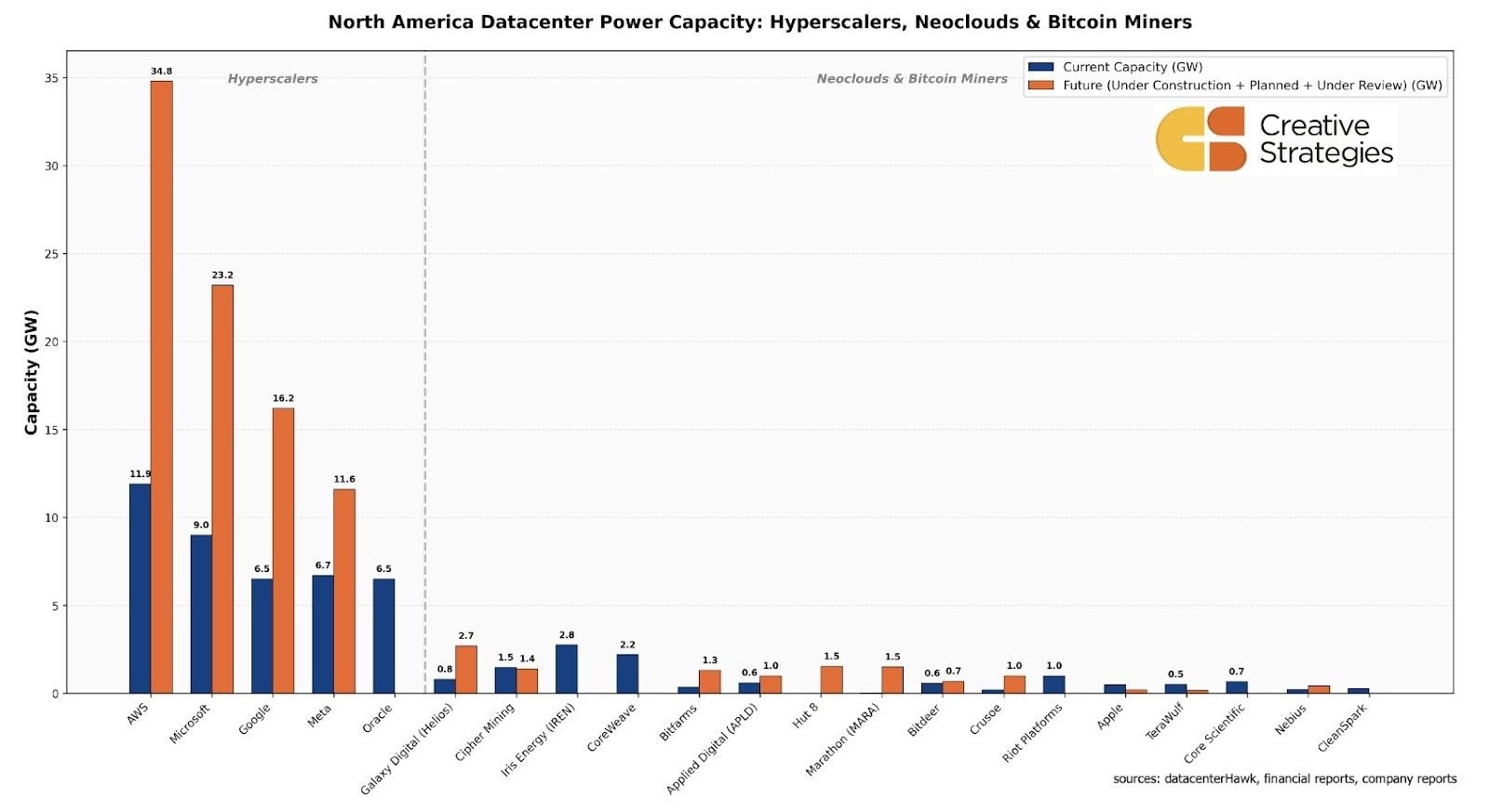

Du côté des projets de construction de datacenters, Creative Strategies anticipe plus de 100GW ⚡ de capacités additionnelles dans les prochaines années, et ce seulement en Amérique du Nord (attention cependant, cette étude comprend les datacenters IA et généralistes).

Pour rappel, un datacenter d’1 GW consomme autant qu’un réacteur nucléaire ☢ moderne. Au niveau des coûts, on estime qu’il faut prévoir entre 40 et 60B$/GW de capacité sur les datacenters IA.

Rien qu’avec ces données, on est en mesure de dire qu’il y a de la place pour tout le monde. D’ailleurs, si ces prévisions se révélaient inexactes, Nvidia ne serait pas le seul à souffrir et les programmes ASICs seraient d’ailleurs probablement coupés en premier.

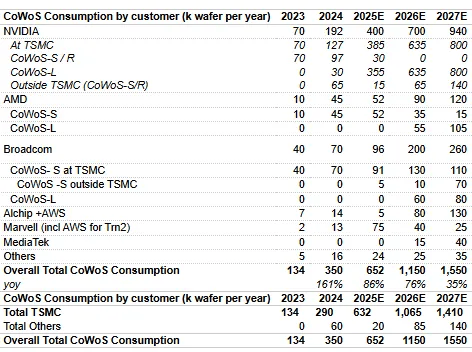

En plus des prévisions sur la taille du marché, je pense qu’il reste intéressant de regarder du côté de la supply-chain, et mon indicateur préféré ici c’est les allocation CoWoS chez TSMC.

Le packaging avancé 2.5D (TSMC CoWoS et CoWoP, Intel EMIB + Forevos, …) est aujourd’hui indispensable à la fabrication d’accélérateurs IA, qu’il s’agisse de GPUs ou d’ASICs.

TSMC est leader dans le secteur et ses capacités sont entièrement réservées. Comme on peut le voir, les estimations placent l’allocation d’Nvidia à 700k wafers par an, en hausse de 75% d’une année sur l’autre, contre 200k pour Broadcom (en hausse de 108% d’une année sur l’autre).

Pour rappel, Broadcom fabrique les TPUs de Google. Ce qu’il faut noter ici cependant, c’est que Broadcom réserve aussi des capacités CoWoS pour d’autres clients ASICs et ses propres puces (TomaHawk 5 et 6).

Donc, même si Broadcom affiche une croissance plus élevée, Nvidia reste très largement en tête en volume. Si l’on se fie à la supply-chain, l’entreprise devrait continuer de dominer largement le marché des accélérateurs IA sur les prochaines années.

Nvidia, encore indétrônable

Comme j’ai déjà pu l’expliquer dans la newsletter sur Nvidia que j’ai pu co-écrire avec Abdallah de Bourseko, le principal avantage compétitif de l’entreprise ne réside pas seulement dans une puce plus puissante que la concurrence.

Le véritable avantage compétitif d’Nvidia réside non seulement dans un écosystème matériel bien en avance par rapport à la concurrence, mais aussi dans tout un écosystème logiciel hyper optimisé qui vient sublimer le matériel, à l’instar d’Apple dans ses meilleures années.

Côté matériel, la solution rack-scale d’Nvidia, le NVL72 GB200/300, est souvent mis en avant car ils sont les seuls à proposer un tel produit. Cependant, il ne faut pas non plus négliger NVLink (avec les NVSwitch), ni tout leur attirail réseau (BlueField 3/4 Smart NIC, Spectum-X/XGS, Quantum-X).

Écosystème Blackwell

Côté logiciel, CUDA a fait le tour des journaux, et pourtant, quand on creuse un peu, on pourrait presque dire qu’il ne s’agit que de la cerise sur le gâteau 🍰. En effet, Nvidia propose tout un écosystème logiciel inconnu du grand public, mais qui rend leur solution incontournable pour les tâches HPC/IA:

NVML (NVidia Management Library): il s’agit d’une bibliothèque permettant le diagnostique et le contrôle des GPUs Nvidia

Nvidia DaemonSet: un programme qui permet une meilleure intégration et orchestration avec Kubernetes, l’outil le plus utilisé pour déployer des infrastructures distribuées

NCCL (Nvidia Collective Communications Library): bibliothèque standard pour le deep learning distribué et l’entraînement de modèles massifs. C’est le réseau interne qui permet aux GPUs de “parler entre eux” très vite et efficacement

Ces trois logiciels expliquent probablement à eux-seuls le succès d’Nvidia dans les datacenters et les environnements distribués depuis 2017.

Bien évidemment, Google a sûrement des équivalences propriétaires internes pour ses TPUs, mais s’ils venaient à vendre leurs puces “nues” comme certains médias le suggèrent, ils seront dans l’obligation de dévoiler une partie de leur technologie et de rendre public leurs librairies.

Là où je doute encore plus sur le fait que Google pourrait venir concurrencer Nvidia sur son propre terrain, c’est que les TPUs sont extrêmement dépendants de l’architecture réseau. Je m’explique:

Les TPUs actuels disponibles à la location (v6e / Trillium) ont une mémoire plus petite (32GB @ 1.38TB/s pour les TPU v6e contre 288GB @ 8TB/s pour Blackwell Ultra) et un design plus shardé, ce qui force la distribution des tâches sur plusieurs puces, augmentant les communications inter-puces et la charge réseau.

Le jeu d’instruction des GPUs est plus généraliste et plus complexe, ce qui permet d’effectuer plus de calculs sur la puce avant de la synchroniser avec le reste du cluster, là où les TPUs, à cause de leur conception, vont avoir besoin de partager plus souvent les instructions et donc de solliciter le réseau.

Les GPUs Nvidia sont accompagnés d’NVLink qui, couplé à un NVSwitch, permet de connecter jusqu’à 72 puces en all-to-all (full mesh) au sein d’un même rack avec une bande passante de 1.8TB/s. NVLink rend aussi possible une cohérence mémoire (mémoire partagée entre plusieurs puces), ce qui permet au rack de se comporter comme un GPU géant. Ces racks sont ensuite connectés entre-eux, soit en RoCE (RDMA over Converged Ethernet), soit avec InfiniBand, permettant la création de clusters massifs de dizaines à centaines de milliers de puces.

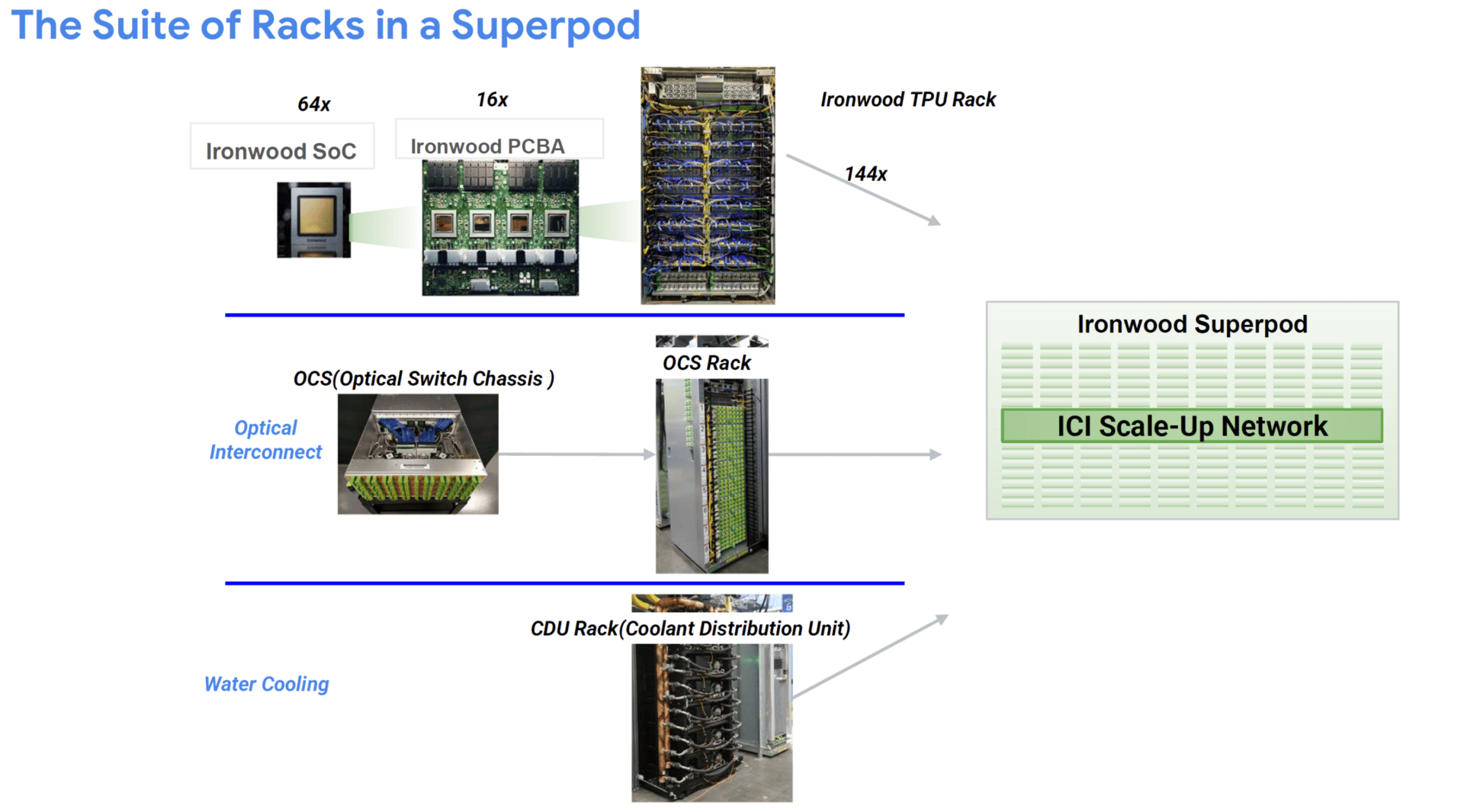

Les TPUs quant à eux sont connectés à l’aide d’ICI (Inter-Chip Interconnect), une architecture en 3D mesh qui permet de connecter jusqu’à 8 puces au sein d’un même serveur avec une bande passante de 1.2TB/s. Google utilise ensuite OCS (Optical Circuit Switch) et son architecture réseau 3D torus pour étendre l’interconnexion au sein du rack puis du cluster, allant jusqu’à 9216 TPUs. Même si les TPUs ne gèrent pas la data de la même manière, l’architecture interconnect de Google est nativement plus intensive en usage réseau, rendant l’orchestration plus complexe.

⚠ J’ai utilisé les dernières puces disponibles à la location pour illustrer la différence mémoire qui est le facteur limitant n°1. Ironwood devrait bientôt être disponible et corrige en grande partie ce défaut, car chaque puce possède 192GB de HBM à 7.38TB/s de bande passante.

Ironwood semble introduire une forme de global addressing, mais pas encore une cohérence mémoire comparable au NVLink+NVSwitch.

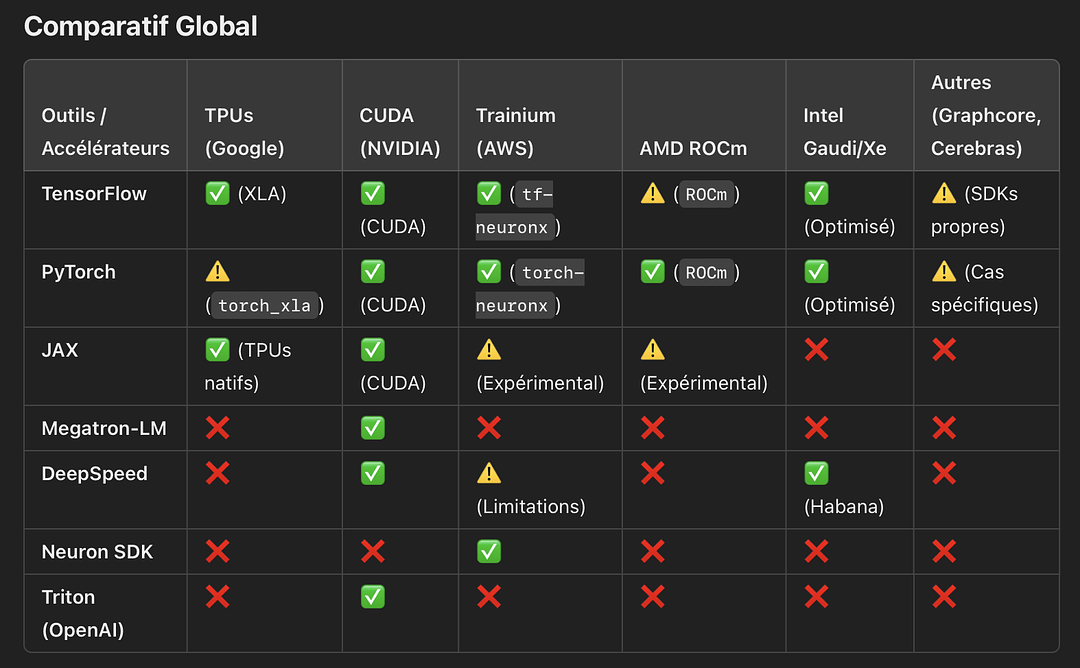

Par ailleurs, si l’on revient purement et simplement sur l’écosystème logiciel, là où les puces Nvidia sont optimisées pour toutes les librairies majeures utilisées en IA, Google n’a optimisé ses TPUs que pour les librairies de son écosystème (TensorFlow/JAX — PyTorch via XLA existe mais ne représente qu’une part marginale des workloads).

Le dernier point que j’aimerais aborder, c’est que peu importe la puissance brute par puce ou l’écosystème logiciel, ce qui importera sera: soit le Perf/Watt dans une économie limitée par l’énergie (ce vers quoi les États-Unis se dirigent), soit le Revenue/TCO dans l’autre cas.

Pour le premier scénario, Nvidia garde un fort avantage sur le nombre de tokens générés par Watt. Dans un environnement contraint sur la capacité énergétique, Nvidia restera devant car sa plateforme permet d’avoir le meilleur ratio Chiffre d’affaires/Watt.

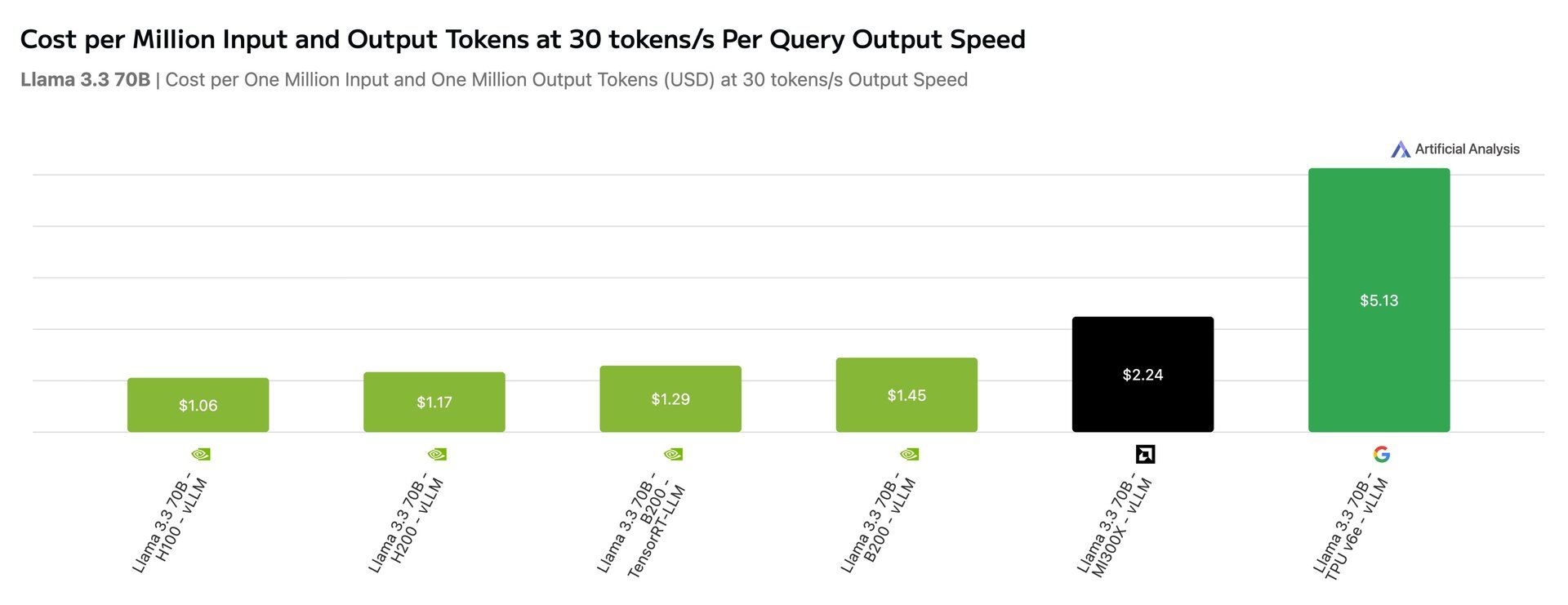

Pour ce qui est du deuxième cas, on a un début de réponse grâce au travail de Artificial Analysis sur X 👇

Avant de commenter les résultats, je me dois de critiquer l’approche qui est imparfaite. Premièrement, ils ont utilisé la version vLLM de Llama3.3 qui biaise les résultats. L’utilisation de vLLM avantage structurellement les GPUs, car vLLM est optimisé pour CUDA et très peu pour XLA. Cela pénalise artificiellement les TPUs dans ce test.

Deuxièmement, ils ont limité la vitesse de génération des tokens par seconde à 30, ce qui ne permet pas d’avoir une représentation correcte de la réalité. Pour cela, il aurait mieux valu normaliser en Perf/Coût en excluant le facteur limitant.

Maintenant que cela est dit, ça permet tout de même donner une idée de la compétitivité de chaque puce. Ici, on voit que les H100 sont les puces les moins chères, mais, phénomène étrange en grande partie expliquée par mon point 2), la B200 est moins compétitive que la H100.

Concernant le TPU, ils ont utilisé Trillium (TPU v6e) car Ironwood (TPU v7) n’est pas encore disponible à la location. Elle devrait être 4 fois plus puissante que son prédécesseur, donc on peut estimer un Perf/Coût dans les 1.3-1.4$ sur ce benchmark précis.

Il faut comprendre que les TPUs sont bien moins chers à fabriquer pour Google car ils n’ont pas à payer la taxe Nvidia (Nvidia a une marge brute de 75% environ). Donc, même s’ils sont légèrement moins puissants, Google y gagne largement sur le TCO car un TPU coûte environ 15k$ là où un GPU Nvidia avoisine les 40-45k$.

Ce qu’il faut retenir, c’est que la réalité est bien plus nuancée et que les TPUs peuvent présenter un avantage sur des tâches bien précises. Chaque plateforme a ses avantages et inconvénients.

Conclusion

Comme on a pu le voir tout au long de cette longue newsletter, les craintes sur Nvidia, que ce soit sur la partie comptable ou bien sur la concurrence avec les TPUs relèvent principalement d’un manque de compréhension.

Niveau comptabilité, rien d’inquiétant pour le moment, même s’il faudra tout de même surveiller l’évolution des inventaires et du DSO.

Concernant les TPUs, ils ne présentent pas à mon sens une concurrence directe, mais restent tout de même l’alternative la plus crédible aux GPUs. Ironwood a l’air très prometteur et le succès des TPUs va grandement profiter à Google à travers GCP.

Si je devais donner ma prévision sur le futur de l’infrastructure HPC/IA, je dirais que le plus probable, c’est de voir apparaître un mix GPU+TPU. À horizon 2030, ça ne m’étonnerait pas qu’Nvidia ait toujours entre 60 et 70% de parts de marché, qu’AMD reste dans les 3-4% et que les ASICs (TPU/XPU/LPU/NPU) prennent le reste.

Voilà, c’est tout pour cette édition. Si tu as des questions ou des retours à me faire, n’hésite pas à répondre directement à cet email 😃.

PS: J’ai fini de migrer mon contenu de Medium vers cette newsletter, seul l’article sur le Nucléaire y restera temporairement car il est trop long pour Beehiiv. Si tu souhaites lire ce que j’ai pu écrire par le passé, tu pourras retrouver les articles sur la page d’accueil de mon site 😉.